深入理解redis(一)

一个开源的高性能键值存储数据库,支持多种数据结构如字符串、哈希、列表、集合等,常用于缓存、消息队列和持久化存储。

初识Redis

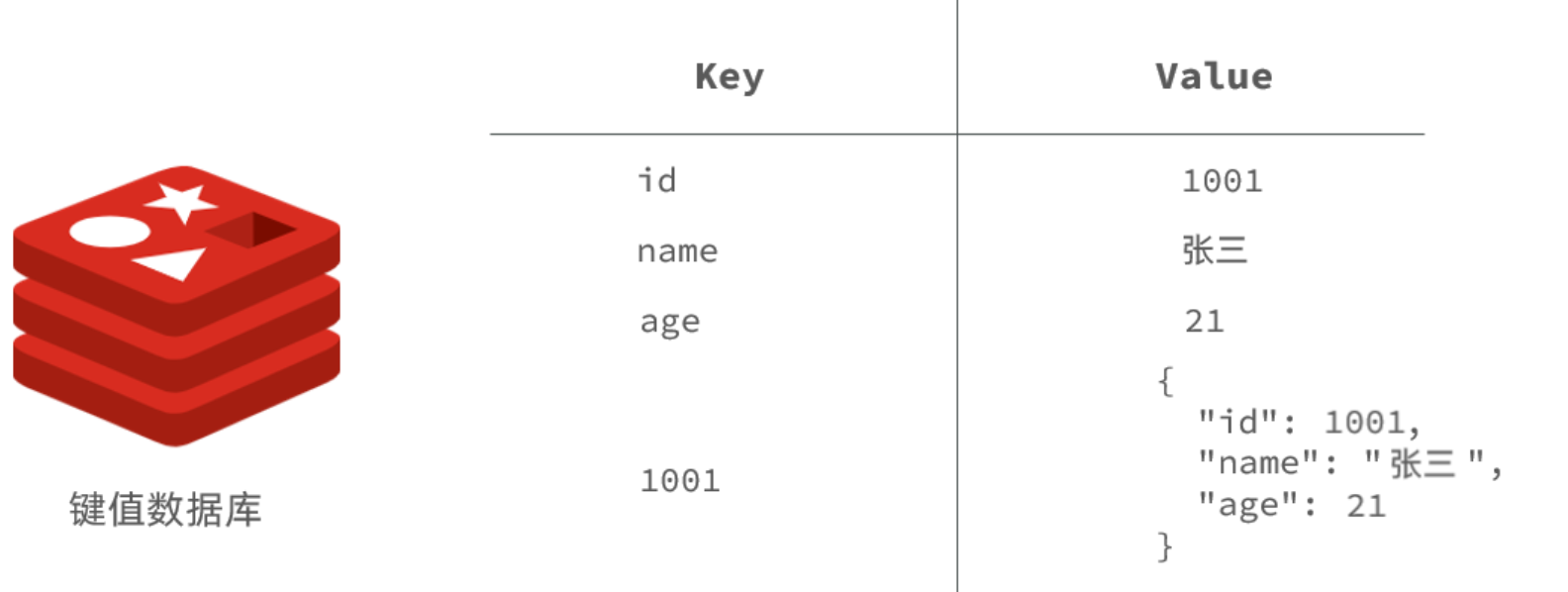

Redis是一种键值型的NoSql数据库,这里有两个关键字:

键值型

NoSql

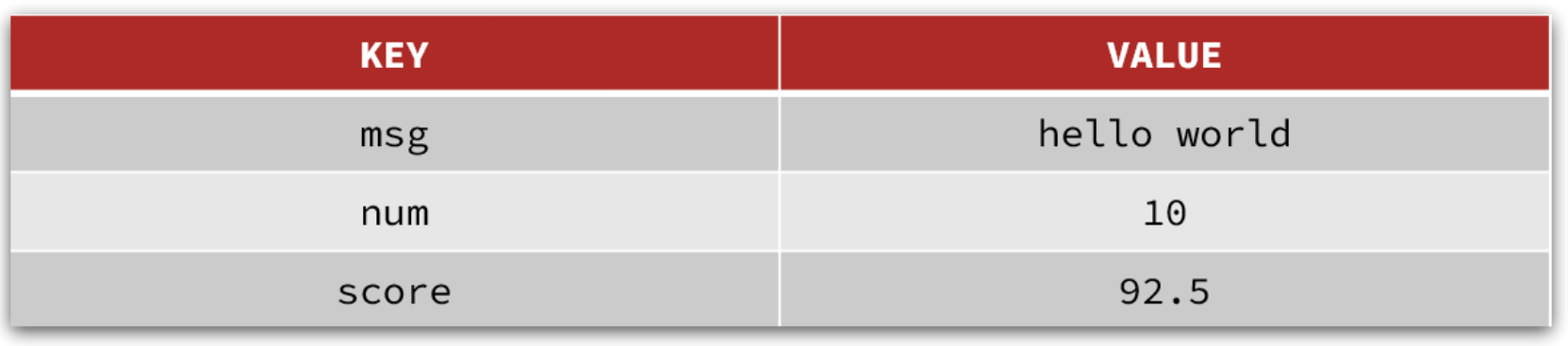

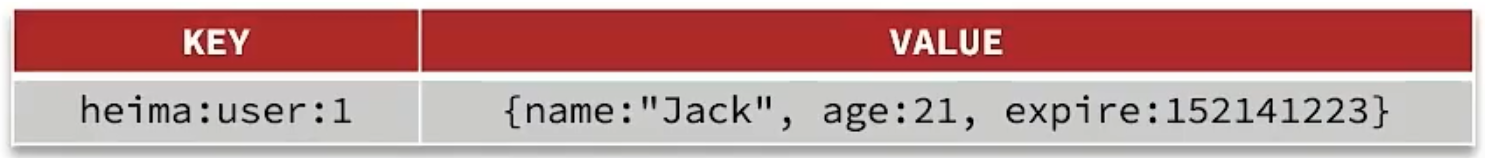

其中键值型,是指Redis中存储的数据都是以key、value对的形式存储,而value的形式多种多样,可以是字符串、数值、甚至json:

而NoSql则是相对于传统关系型数据库而言,有很大差异的一种数据库。

认识NoSQL

NoSql可以翻译做Not Only Sql(不仅仅是SQL),或者是No Sql(非Sql的)数据库。是相对于传统关系型数据库而言,有很大差异的一种特殊的数据库,因此也称之为非关系型数据库。

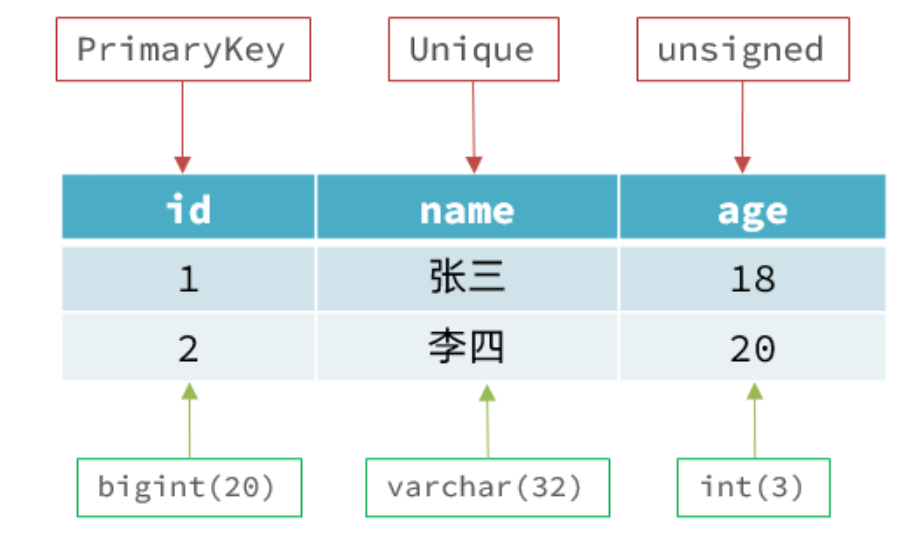

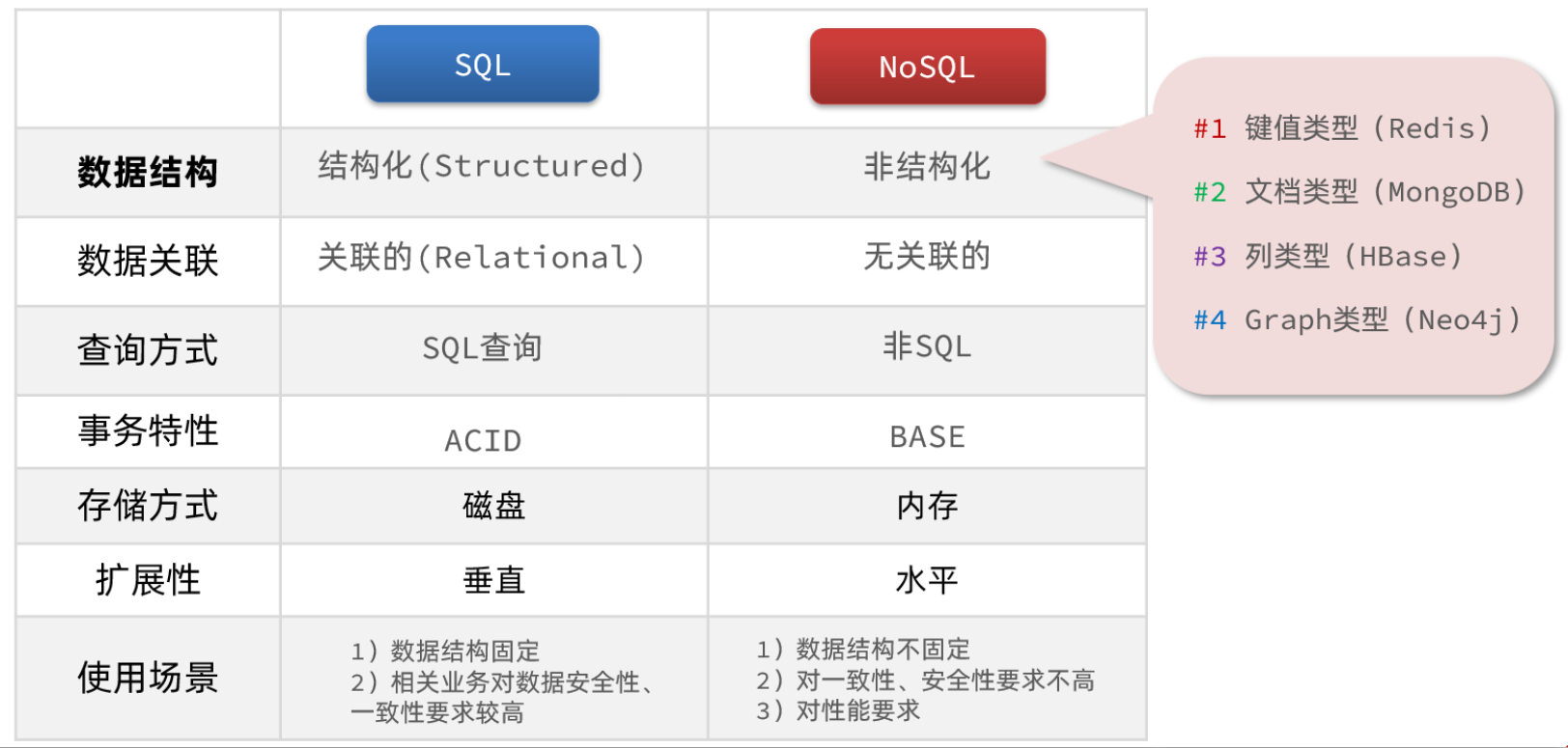

结构化和非结构化

传统关系型数据库是结构化数据,每一张表都有严格的约束信息:字段名、字段数据类型、字段约束等等信息,插入的数据必须遵守这些约束:

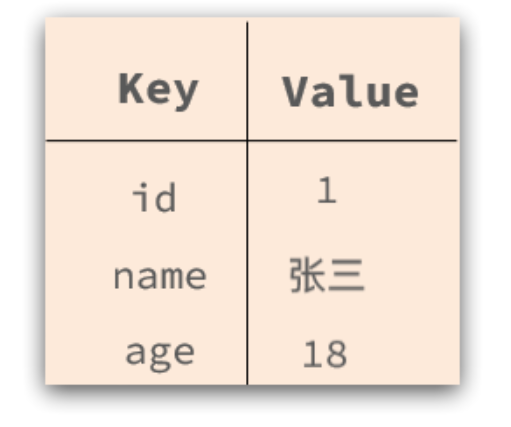

而NoSql则对数据库格式没有严格约束,往往形式松散,自由。

可以是键值型:

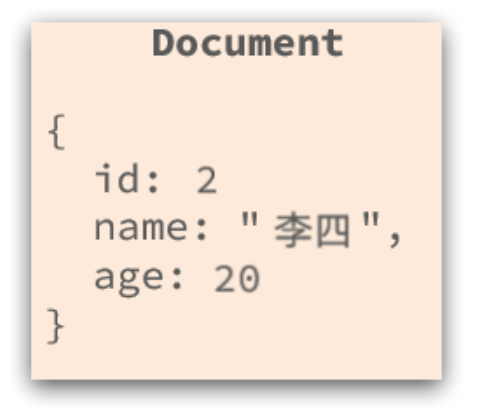

也可以是文档型(elasticsearch):

也可以是文档型(elasticsearch):

甚至可以是图格式:

甚至可以是图格式:

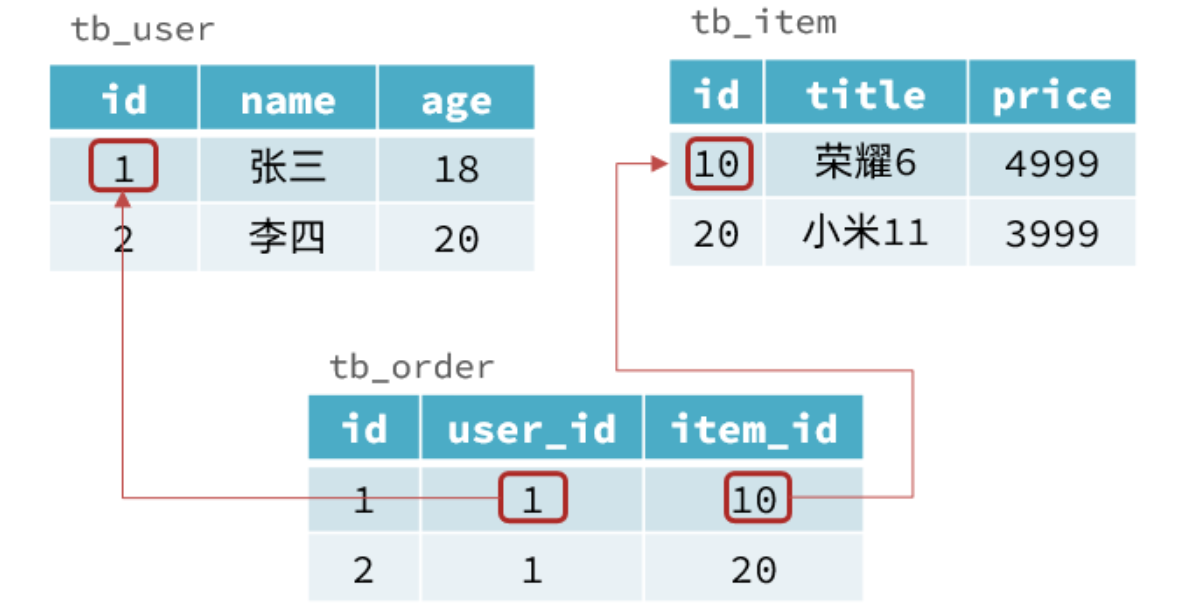

关联和非关联

传统数据库的表与表之间往往存在关联,例如外键:

而非关系型数据库不存在关联关系,要维护关系要么靠代码中的业务逻辑,要么靠数据之间的耦合:

{

id: 1,

name: "张三",

orders: [

{

id: 1,

item: {

id: 10, title: "荣耀6", price: 4999

}

},

{

id: 2,

item: {

id: 20, title: "小米11", price: 3999

}

}

]

}此处要维护“张三”的订单与商品“荣耀”和“小米11”的关系,不得不冗余的将这两个商品保存在张三的订单文档中,不够优雅。还是建议用业务来维护关联关系。

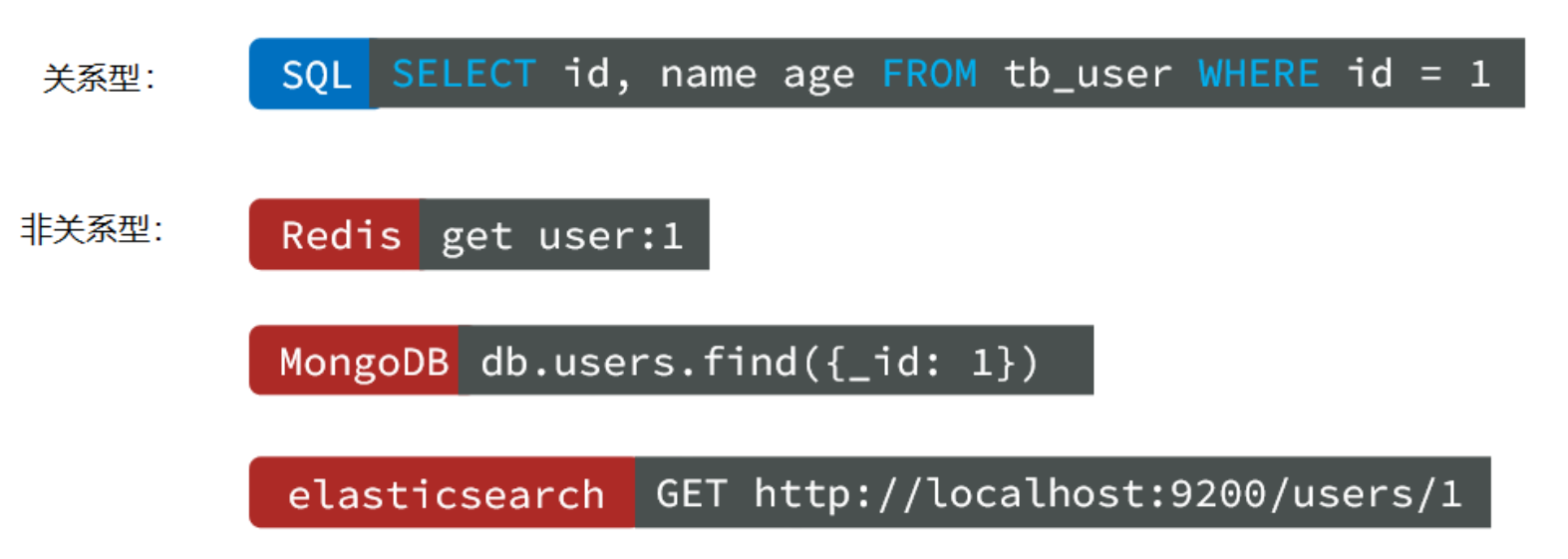

查询方式

传统关系型数据库会基于Sql语句做查询,语法有统一标准;

而不同的非关系数据库查询语法差异极大,五花八门各种各样。

事务

传统关系型数据库能满足事务ACID的原则。

而非关系型数据库往往不支持事务,或者不能严格保证ACID的特性,只能实现基本的一致性。

总结

除了上述四点以外,在存储方式、扩展性、查询性能上关系型与非关系型也都有着显著差异,总结如下:

存储方式

关系型数据库基于磁盘进行存储,会有大量的磁盘IO,对性能有一定影响

非关系型数据库,他们的操作更多的是依赖于内存来操作,内存的读写速度会非常快,性能自然会好一些

扩展性

关系型数据库集群模式一般是主从,主从数据一致,起到数据备份的作用,称为垂直扩展。

非关系型数据库可以将数据拆分,存储在不同机器上,可以保存海量数据,解决内存大小有限的问题。称为水平扩展。

关系型数据库因为表之间存在关联关系,如果做水平扩展会给数据查询带来很多麻烦。

认识Redis

Redis诞生于2009年全称是Remote Dictionary Server 远程词典服务器,是一个基于内存的键值型NoSQL数据库。

特征:

键值(key-value)型,value支持多种不同数据结构,功能丰富

单线程,每个命令具备原子性

低延迟,速度快(基于内存、IO多路复用、良好的编码)。

支持数据持久化

支持主从集群、分片集群

支持多语言客户端

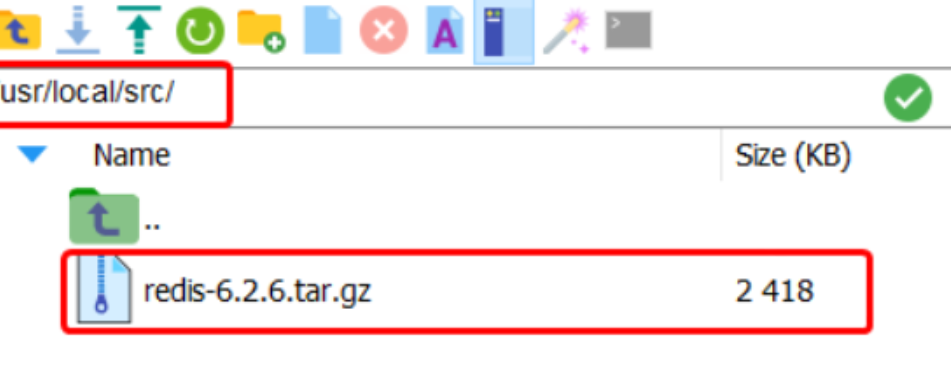

安装Redis

大多数企业都是基于Linux服务器来部署项目。

依赖库

Redis是基于C语言编写的,因此首先需要安装Redis所需要的gcc依赖:

yum install -y gcc tcl解压

解压缩:

解压缩:

tar -xzf redis-6.2.6.tar.gz进入redis目录:

cd redis-6.2.6运行编译命令:

make && make install如果没有出错,应该就安装成功了。

启动

redis的启动方式有很多种,例如:

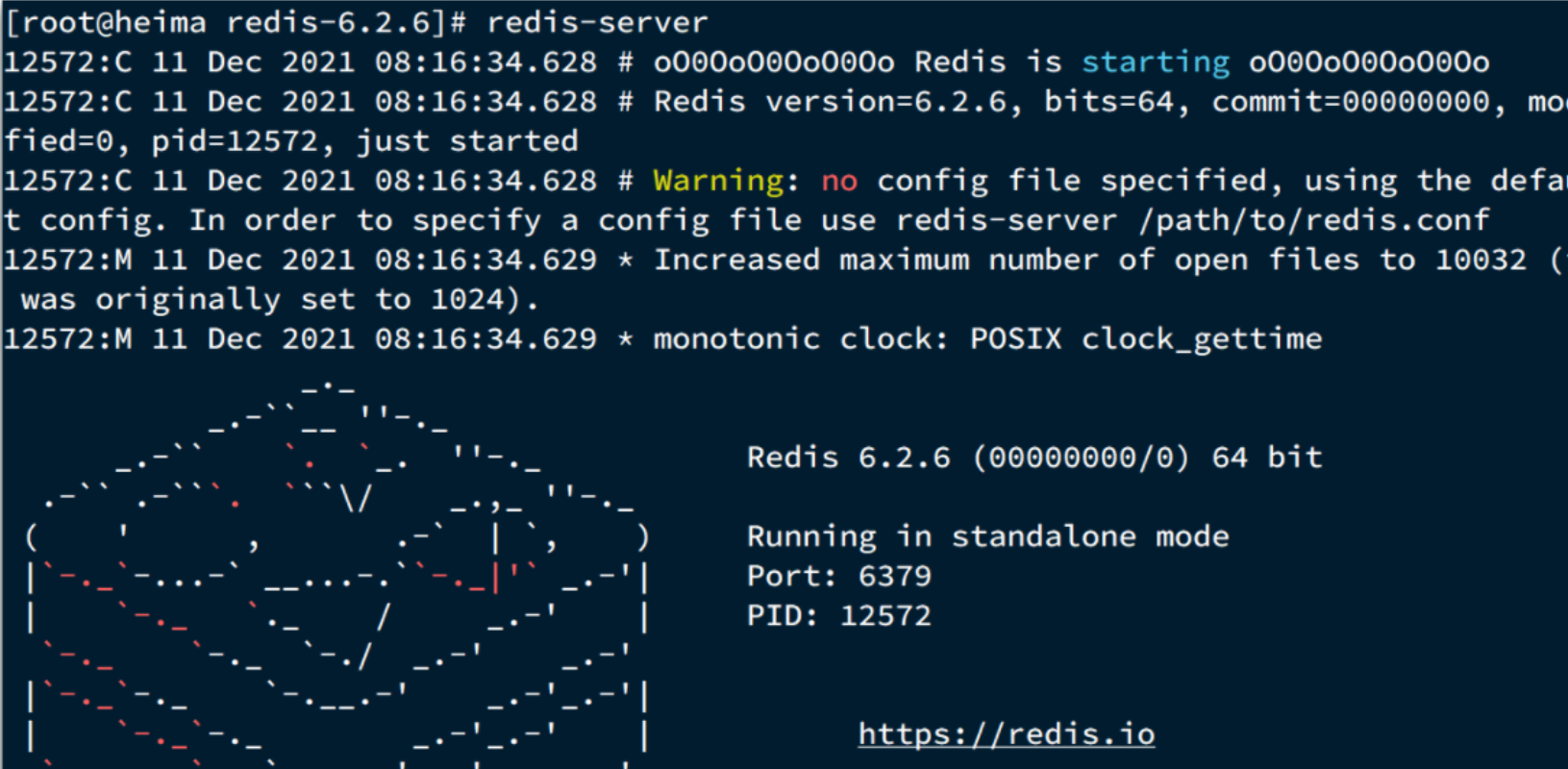

默认启动

指定配置启动

开机自启

默认启动

安装完成后,在任意目录输入redis-server命令即可启动Redis:

redis-server如图:

这种启动属于前台启动,会阻塞整个会话窗口,窗口关闭或者按下CTRL + C则Redis停止。不推荐使用。

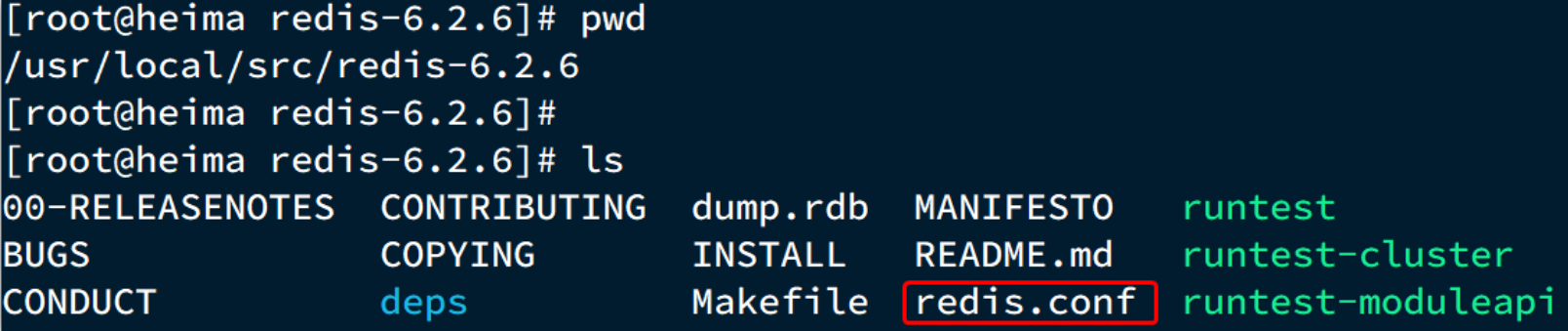

指定配置启动

如果要让Redis以后台方式启动,则必须修改Redis配置文件,就在我们之前解压的redis安装包下(/usr/local/src/redis-6.2.6),名字叫redis.conf:

我们先将这个配置文件备份一份:

cp redis.conf redis.conf.bak然后修改redis.conf文件中的一些配置:

## 允许访问的地址,默认是127.0.0.1,会导致只能在本地访问。修改为0.0.0.0则可以在任意IP访问,生产环境不要设置为0.0.0.0

bind 0.0.0.0

## 守护进程,修改为yes后即可后台运行

daemonize yes

## 密码,设置后访问Redis必须输入密码

requirepass 123321Redis的其它常见配置:

## 监听的端口

port 6379

## 工作目录,默认是当前目录,也就是运行redis-server时的命令,日志、持久化等文件会保存在这个目录

dir .

## 数据库数量,设置为1,代表只使用1个库,默认有16个库,编号0~15

databases 1

## 设置redis能够使用的最大内存

maxmemory 512mb

## 日志文件,默认为空,不记录日志,可以指定日志文件名

logfile "redis.log"启动Redis:

## 进入redis安装目录

cd /usr/local/src/redis-6.2.6

## 启动

redis-server redis.conf停止服务:

## 利用redis-cli来执行 shutdown 命令,即可停止 Redis 服务,

## 因为之前配置了密码,因此需要通过 -u 来指定密码

redis-cli -u 123321 shutdown开机自启

需要配置系统服务,这里不再赘述。

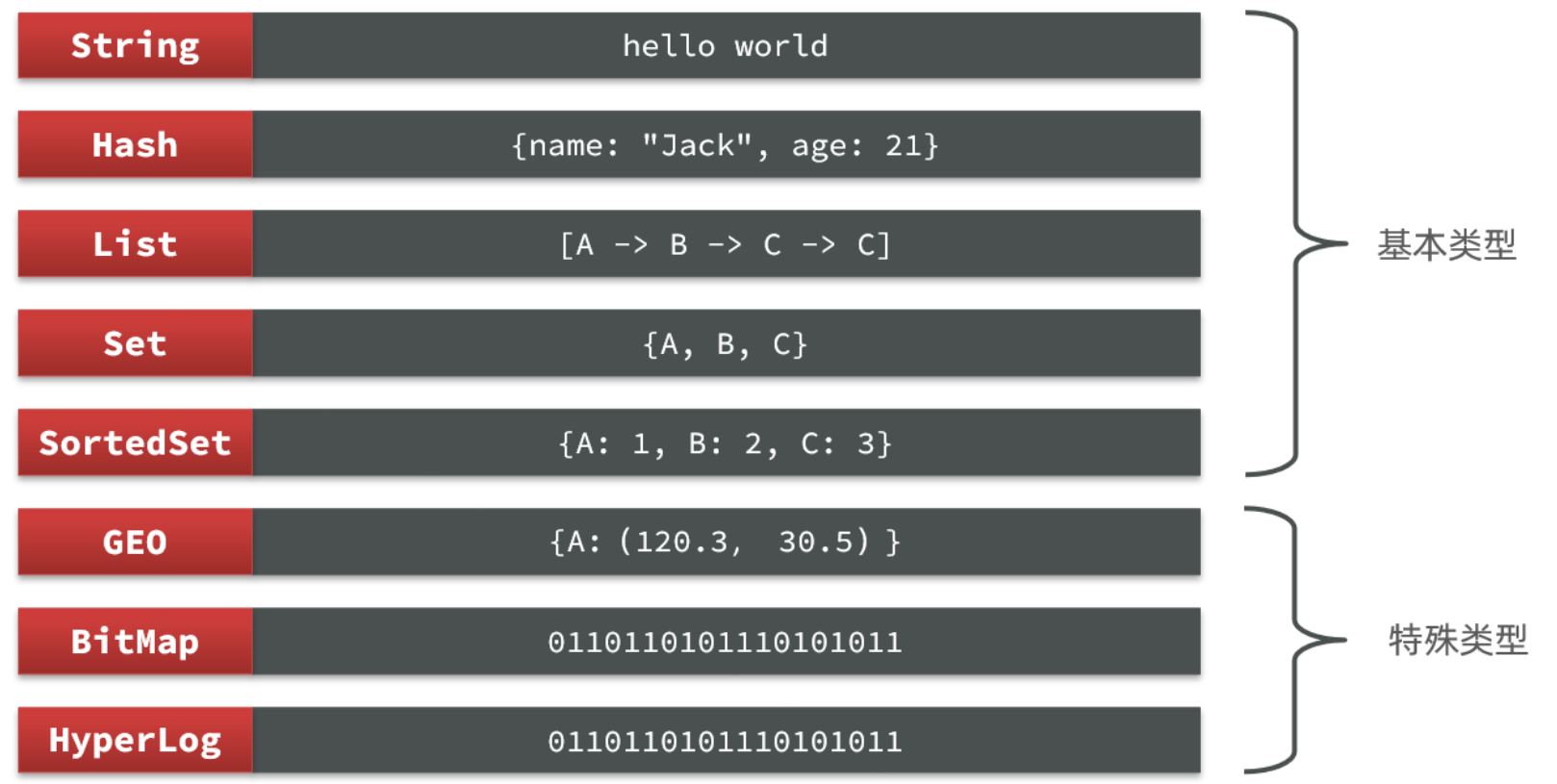

Redis常见命令

Redis是典型的key-value数据库,key一般是字符串,而value包含很多不同的数据类型:

Redis为了方便我们学习,将操作不同数据类型的命令也做了分组,在官网( https://redis.io/commands )可以查看到不同的命令:

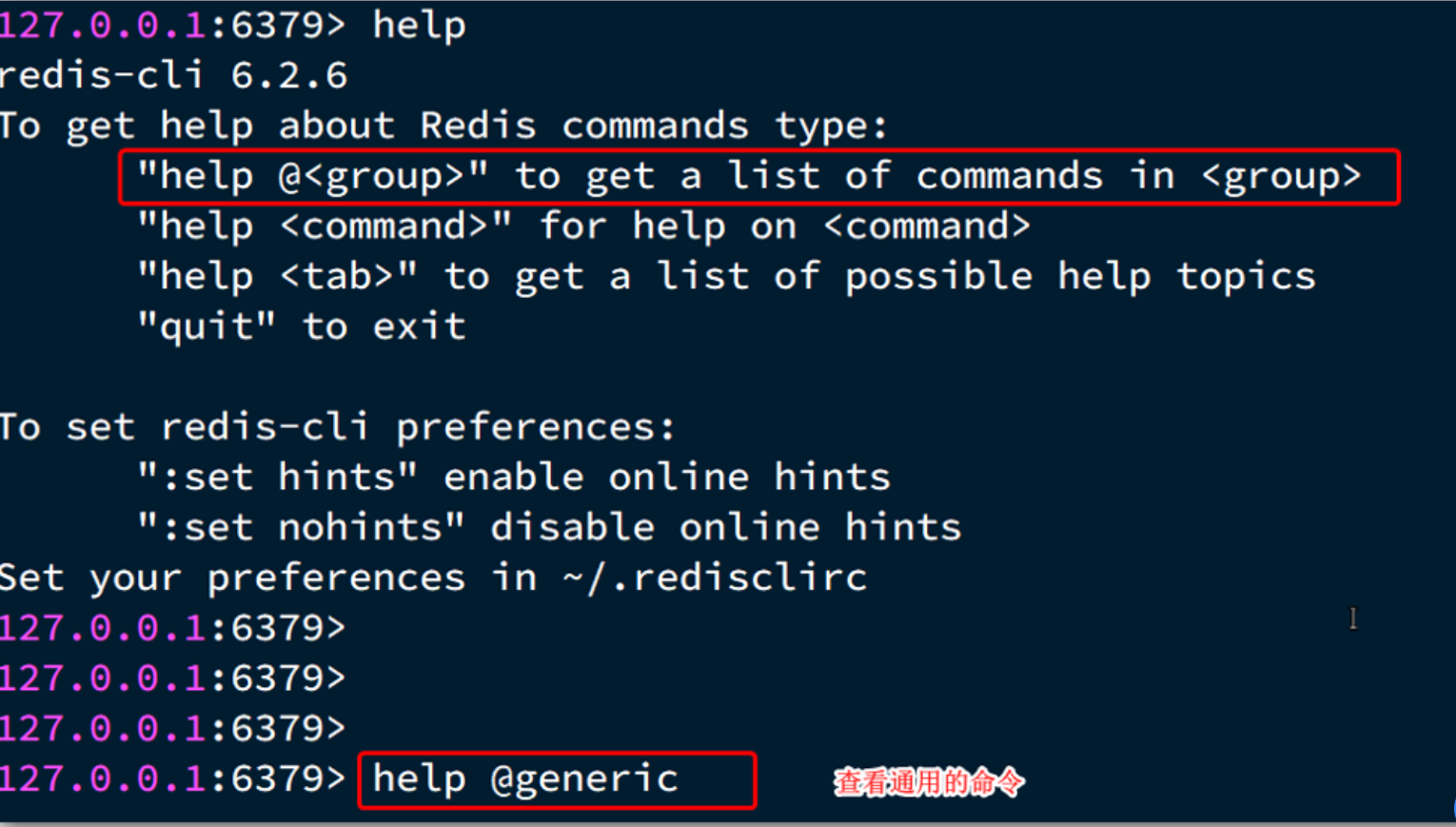

不同类型的命令称为一个group,我们也可以通过help命令来查看各种不同group的命令:

通用命令

通用指令是部分数据类型的,都可以使用的指令,常见的有:

KEYS:查看符合模板的所有key

DEL:删除一个指定的key

EXISTS:判断key是否存在

EXPIRE:给一个key设置有效期,有效期到期时该key会被自动删除

TTL:查看一个KEY的剩余有效期

通过help [command] 可以查看一个命令的具体用法,例如:

## 查看keys命令的帮助信息:

127.0.0.1:6379> help keys

KEYS pattern

summary: Find all keys matching the given pattern

since: 1.0.0

group: genericString类型

String类型,也就是字符串类型,是Redis中最简单的存储类型。

其value是字符串,不过根据字符串的格式不同,又可以分为3类:

string:普通字符串

int:整数类型,可以做自增、自减操作

float:浮点类型,可以做自增、自减操作

不管是哪种格式,底层都是字节数组形式存储,只不过是编码方式不同。字符串类型的最大空间不能超过512m.

String常见命令

String的常见命令有:

SET:添加或者修改已经存在的一个String类型的键值对

GET:根据key获取String类型的value

MSET:批量添加多个String类型的键值对

MGET:根据多个key获取多个String类型的value

INCR:让一个整型的key自增1

INCRBY:让一个整型的key自增并指定步长,例如:incrby num 2 让num值自增2

INCRBYFLOAT:让一个浮点类型的数字自增并指定步长

SETNX:添加一个String类型的键值对,前提是这个key不存在,否则不执行

SETEX:添加一个String类型的键值对,并且指定有效期

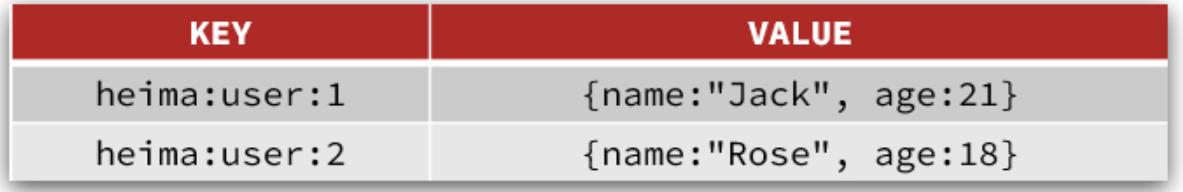

Key结构

Redis没有类似MySQL中的Table的概念,我们该如何区分不同类型的key呢?

例如,需要存储用户、商品信息到redis,有一个用户id是1,有一个商品id恰好也是1,此时如果使用id作为key,那就会冲突了,该怎么办?

我们可以通过给key添加前缀加以区分,不过这个前缀不是随便加的,有一定的规范:

Redis的key允许有多个单词形成层级结构,多个单词之间用':'隔开,格式如下:

项目名:业务名:类型:idHash类型

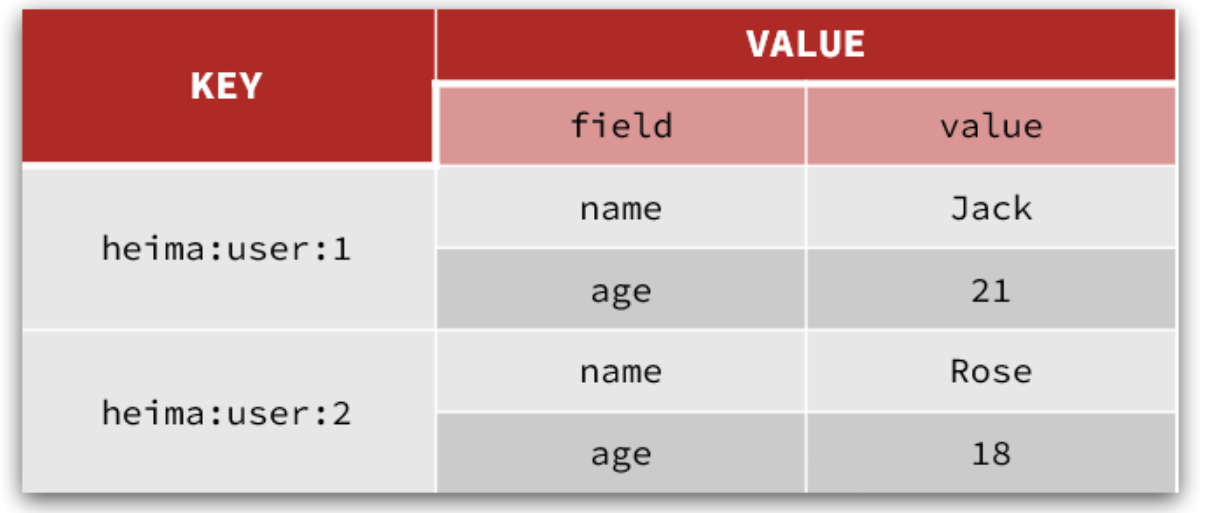

Hash类型,也叫散列,其value是一个无序字典,类似于Java中的HashMap结构。

String结构是将对象序列化为JSON字符串后存储,当需要修改对象某个字段时很不方便:

Hash结构可以将对象中的每个字段独立存储,可以针对单个字段做CRUD:

Hash的常见命令有:

HSET key field value:添加或者修改hash类型key的field的值

HGET key field:获取一个hash类型key的field的值

HMSET:批量添加多个hash类型key的field的值

HMGET:批量获取多个hash类型key的field的值

HGETALL:获取一个hash类型的key中的所有的field和value

HKEYS:获取一个hash类型的key中的所有的field

HINCRBY:让一个hash类型key的字段值自增并指定步长

HSETNX:添加一个hash类型的key的field值,前提是这个field不存在,否则不执行

List类型

Redis中的List类型与Java中的LinkedList类似,可以看做是一个双向链表结构。既可以支持正向检索和也可以支持反向检索。

特征也与LinkedList类似:

有序

元素可以重复

插入和删除快

查询速度一般

常用来存储一个有序数据,例如:朋友圈点赞列表,评论列表等。

List的常见命令有:

LPUSH key element ... :向列表左侧插入一个或多个元素

LPOP key:移除并返回列表左侧的第一个元素,没有则返回nil

RPUSH key element ... :向列表右侧插入一个或多个元素

RPOP key:移除并返回列表右侧的第一个元素

LRANGE key star end:返回一段角标范围内的所有元素

BLPOP和BRPOP:与LPOP和RPOP类似,只不过在没有元素时等待指定时间,而不是直接返回nil

Set类型

Redis的Set结构与Java中的HashSet类似,可以看做是一个value为null的HashMap。因为也是一个hash表,因此具备与HashSet类似的特征:

无序

元素不可重复

查找快

支持交集、并集、差集等功能

Set的常见命令有:

SADD key member ... :向set中添加一个或多个元素

SREM key member ... : 移除set中的指定元素

SCARD key: 返回set中元素的个数

SISMEMBER key member:判断一个元素是否存在于set中

SMEMBERS:获取set中的所有元素

SINTER key1 key2 ... :求key1与key2的交集

SortedSet类型

Redis的SortedSet是一个可排序的set集合,与Java中的TreeSet有些类似,但底层数据结构却差别很大。SortedSet中的每一个元素都带有一个score属性,可以基于score属性对元素排序,底层的实现是一个跳表(SkipList)加 hash表。

SortedSet具备下列特性:

可排序

元素不重复

查询速度快

因为SortedSet的可排序特性,经常被用来实现排行榜这样的功能。

SortedSet的常见命令有:

ZADD key score member:添加一个或多个元素到sorted set ,如果已经存在则更新其score值

ZREM key member:删除sorted set中的一个指定元素

ZSCORE key member : 获取sorted set中的指定元素的score值

ZRANK key member:获取sorted set 中的指定元素的排名

ZCARD key:获取sorted set中的元素个数

ZCOUNT key min max:统计score值在给定范围内的所有元素的个数

ZINCRBY key increment member:让sorted set中的指定元素自增,步长为指定的increment值

ZRANGE key min max:按照score排序后,获取指定排名范围内的元素

ZRANGEBYSCORE key min max:按照score排序后,获取指定score范围内的元素

ZDIFF、ZINTER、ZUNION:求差集、交集、并集

注意:所有的排名默认都是升序,如果要降序则在命令的Z后面添加REV即可,例如:

升序获取sorted set 中的指定元素的排名:ZRANK key member

降序获取sorted set 中的指定元素的排名:ZREVRANK key memeber

Redis的Java客户端

在Redis官网中提供了各种语言的客户端,地址:https://redis.io/docs/clients/

其中Java客户端也包含很多:

Jedis和Lettuce:这两个主要是提供了Redis命令对应的API,方便我们操作Redis,而SpringDataRedis又对这两种做了抽象和封装,因此我们后期会直接以SpringDataRedis来学习。

Redisson:是在Redis基础上实现了分布式的可伸缩的java数据结构,例如Map、Queue等,而且支持跨进程的同步机制:Lock、Semaphore等待,比较适合用来实现特殊的功能需求。

Jedis客户端

Jedis的官网地址: https://github.com/redis/jedis

快速入门

我们先来个快速入门:

1)引入依赖:

<!--jedis-->

<dependency>

<groupId>redis.clients</groupId>

<artifactId>jedis</artifactId>

<version>3.7.0</version>

</dependency>

<!--单元测试-->

<dependency>

<groupId>org.junit.jupiter</groupId>

<artifactId>junit-jupiter</artifactId>

<version>5.7.0</version>

<scope>test</scope>

</dependency>2)建立连接

新建一个单元测试类,内容如下:

private Jedis jedis;

@BeforeEach

void setUp() {

// 1.建立连接

// jedis = new Jedis("192.168.150.101", 6379);

jedis = JedisConnectionFactory.getJedis();

// 2.设置密码

jedis.auth("123321");

// 3.选择库

jedis.select(0);

}3)测试:

@Test

void testString() {

// 存入数据

String result = jedis.set("name", "虎哥");

System.out.println("result = " + result);

// 获取数据

String name = jedis.get("name");

System.out.println("name = " + name);

}

@Test

void testHash() {

// 插入hash数据

jedis.hset("user:1", "name", "Jack");

jedis.hset("user:1", "age", "21");

// 获取

Map<String, String> map = jedis.hgetAll("user:1");

System.out.println(map);

}4)释放资源

@AfterEach

void tearDown() {

if (jedis != null) {

jedis.close();

}

}连接池

Jedis本身是线程不安全的,并且频繁的创建和销毁连接会有性能损耗,因此我们推荐大家使用Jedis连接池代替Jedis的直连方式。

package com.heima.jedis.util;

import redis.clients.jedis.*;

public class JedisConnectionFactory {

private static JedisPool jedisPool;

static {

// 配置连接池

JedisPoolConfig poolConfig = new JedisPoolConfig();

poolConfig.setMaxTotal(8);

poolConfig.setMaxIdle(8);

poolConfig.setMinIdle(0);

poolConfig.setMaxWaitMillis(1000);

// 创建连接池对象,参数:连接池配置、服务端ip、服务端端口、超时时间、密码

jedisPool = new JedisPool(poolConfig, "192.168.150.101", 6379, 1000, "123321");

}

public static Jedis getJedis(){

return jedisPool.getResource();

}

}SpringDataRedis客户端

SpringData是Spring中数据操作的模块,包含对各种数据库的集成,其中对Redis的集成模块就叫做SpringDataRedis,官网地址:https://spring.io/projects/spring-data-redis

提供了对不同Redis客户端的整合(Lettuce和Jedis)

提供了RedisTemplate统一API来操作Redis

支持Redis的发布订阅模型

支持Redis哨兵和Redis集群

支持基于Lettuce的响应式编程

支持基于JDK、JSON、字符串、Spring对象的数据序列化及反序列化

支持基于Redis的JDKCollection实现

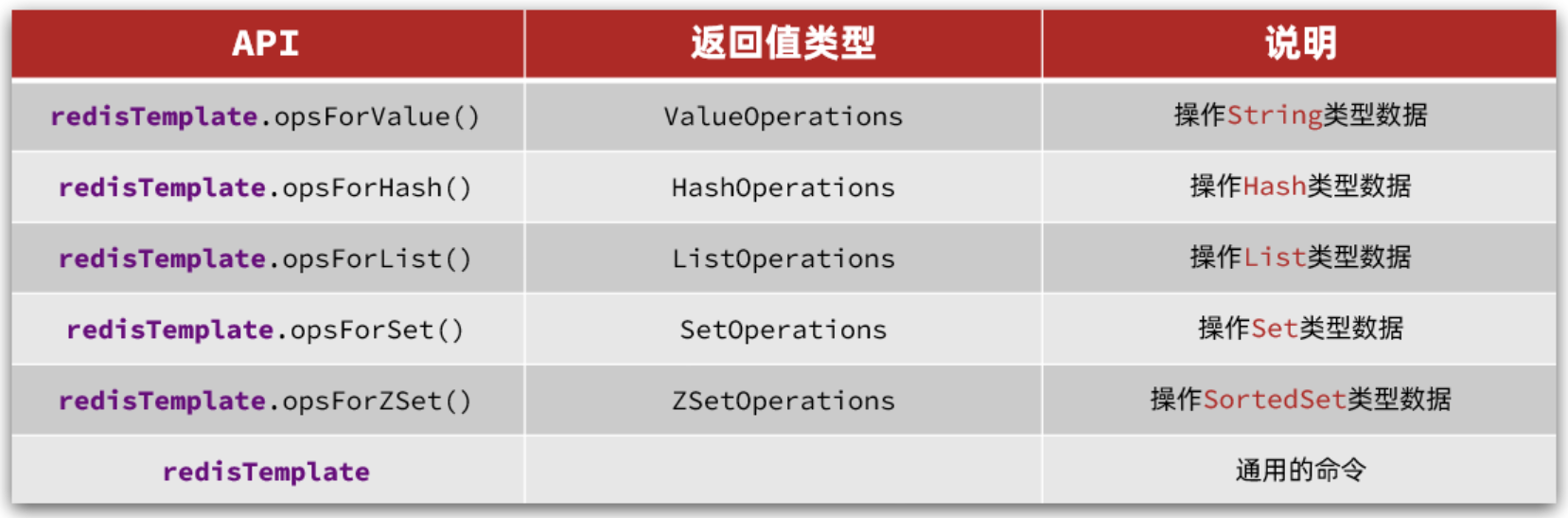

SpringDataRedis中提供了RedisTemplate工具类,其中封装了各种对Redis的操作。并且将不同数据类型的操作API封装到了不同的类型中:

快速入门

SpringBoot已经提供了对SpringDataRedis的支持,使用非常简单。

首先,新建一个maven项目,然后按照下面步骤执行:

1)引入依赖

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>2.5.7</version>

<relativePath/> <!-- lookup parent from repository -->

</parent>

<groupId>com.heima</groupId>

<artifactId>redis-demo</artifactId>

<version>0.0.1-SNAPSHOT</version>

<name>redis-demo</name>

<description>Demo project for Spring Boot</description>

<properties>

<java.version>1.8</java.version>

</properties>

<dependencies>

<!--redis依赖-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

</dependency>

<!--common-pool-->

<dependency>

<groupId>org.apache.commons</groupId>

<artifactId>commons-pool2</artifactId>

</dependency>

<!--Jackson依赖-->

<dependency>

<groupId>com.fasterxml.jackson.core</groupId>

<artifactId>jackson-databind</artifactId>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<configuration>

<excludes>

<exclude>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

</exclude>

</excludes>

</configuration>

</plugin>

</plugins>

</build>

</project>2)配置Redis

spring:

redis:

host: 192.168.150.101

port: 6379

password: 123321

lettuce:

pool:

max-active: 8

max-idle: 8

min-idle: 0

max-wait: 100ms3)注入RedisTemplate

因为有了SpringBoot的自动装配,我们可以拿来就用:

@SpringBootTest

class RedisStringTests {

@Autowired

private RedisTemplate redisTemplate;

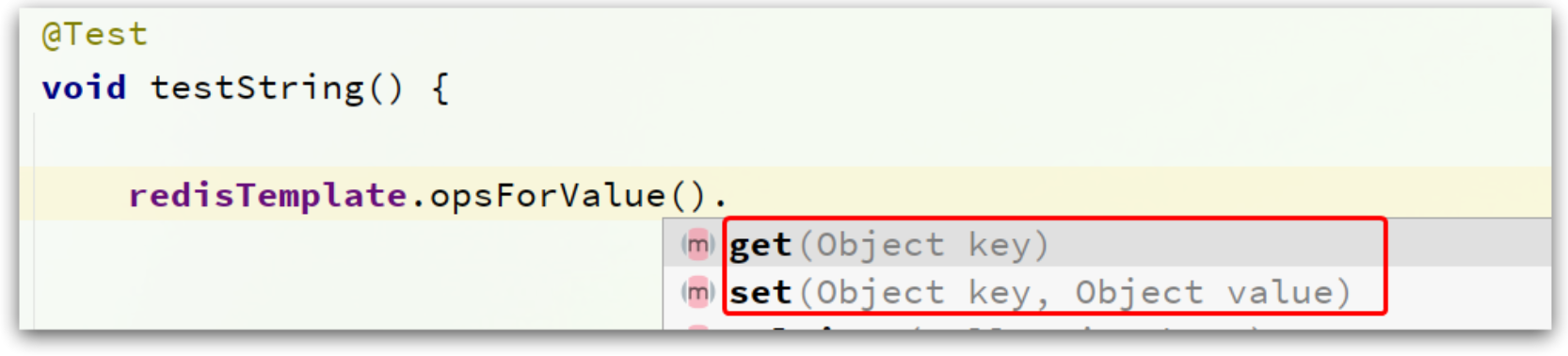

}4)编写测试

@SpringBootTest

class RedisStringTests {

@Autowired

private RedisTemplate edisTemplate;

@Test

void testString() {

// 写入一条String数据

redisTemplate.opsForValue().set("name", "虎哥");

// 获取string数据

Object name = stringRedisTemplate.opsForValue().get("name");

System.out.println("name = " + name);

}

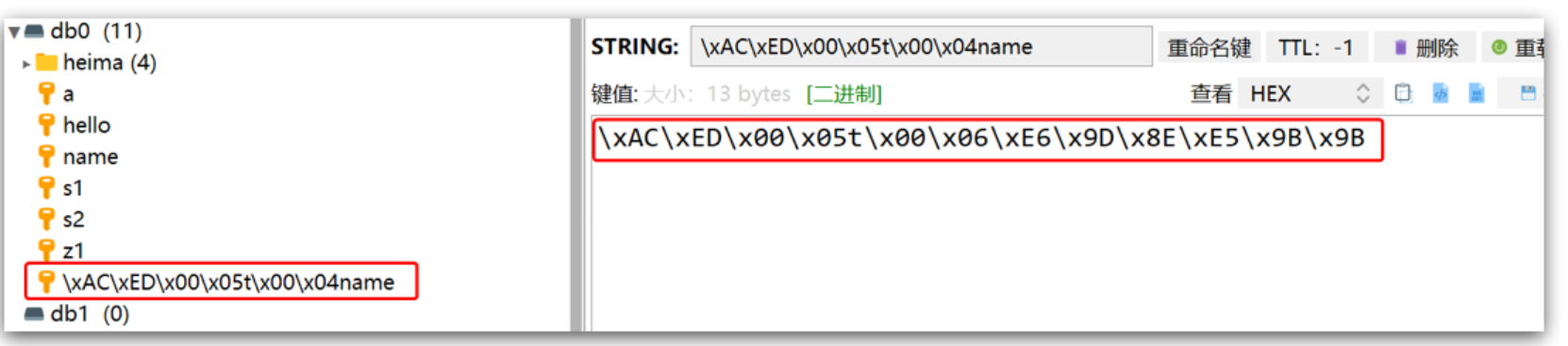

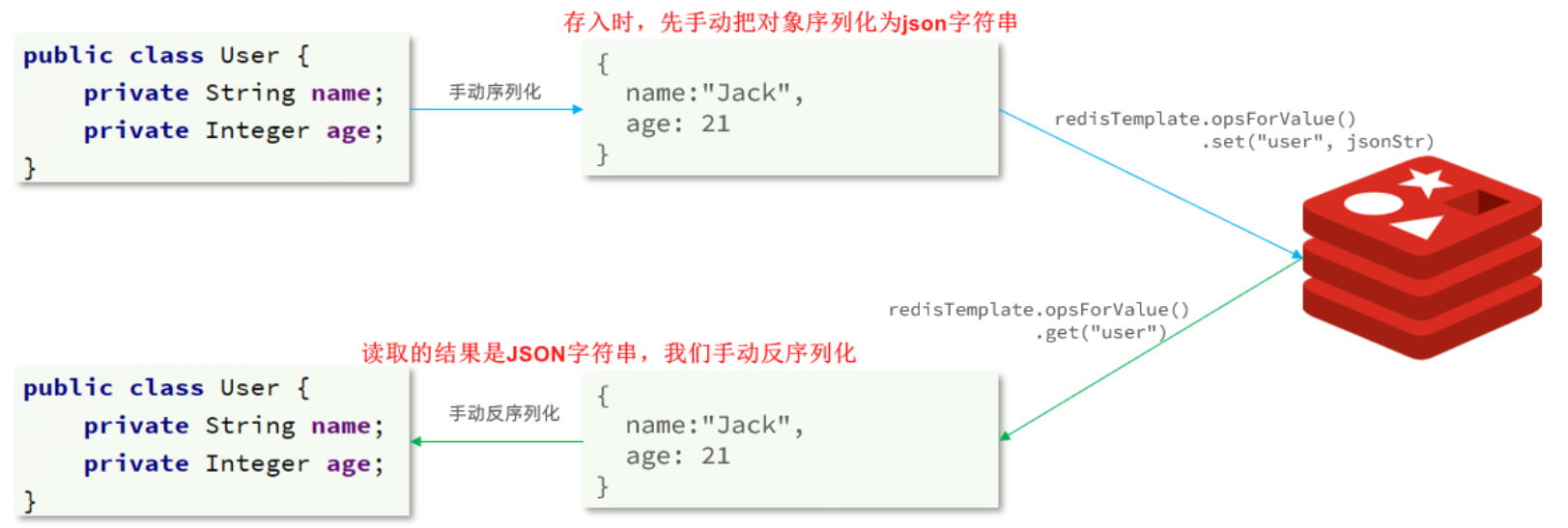

}自定义序列化

RedisTemplate可以接收任意Object作为值写入Redis:

只不过写入前会把Object序列化为字节形式,默认是采用JDK序列化,得到的结果是这样的:

缺点:

可读性差

内存占用较大

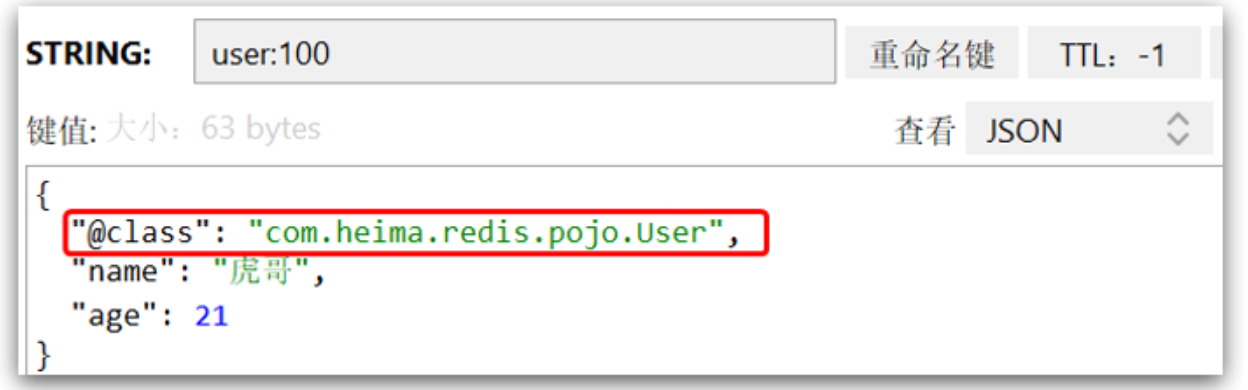

我们可以自定义RedisTemplate的序列化方式,代码如下:

@Configuration

public class RedisConfig {

@Bean

public RedisTemplate<String, Object> redisTemplate(RedisConnectionFactory connectionFactory){

// 创建RedisTemplate对象

RedisTemplate<String, Object> template = new RedisTemplate<>();

// 设置连接工厂

template.setConnectionFactory(connectionFactory);

// 创建JSON序列化工具

GenericJackson2JsonRedisSerializer jsonRedisSerializer =

new GenericJackson2JsonRedisSerializer();

// 设置Key的序列化

template.setKeySerializer(RedisSerializer.string());

template.setHashKeySerializer(RedisSerializer.string());

// 设置Value的序列化

template.setValueSerializer(jsonRedisSerializer);

template.setHashValueSerializer(jsonRedisSerializer);

// 返回

return template;

}

}这里采用了JSON序列化来代替默认的JDK序列化方式。最终结果如图:

整体可读性有了很大提升,并且能将Java对象自动的序列化为JSON字符串,并且查询时能自动把JSON反序列化为Java对象。不过,其中记录了序列化时对应的class名称,目的是为了查询时实现自动反序列化。这会带来额外的内存开销。

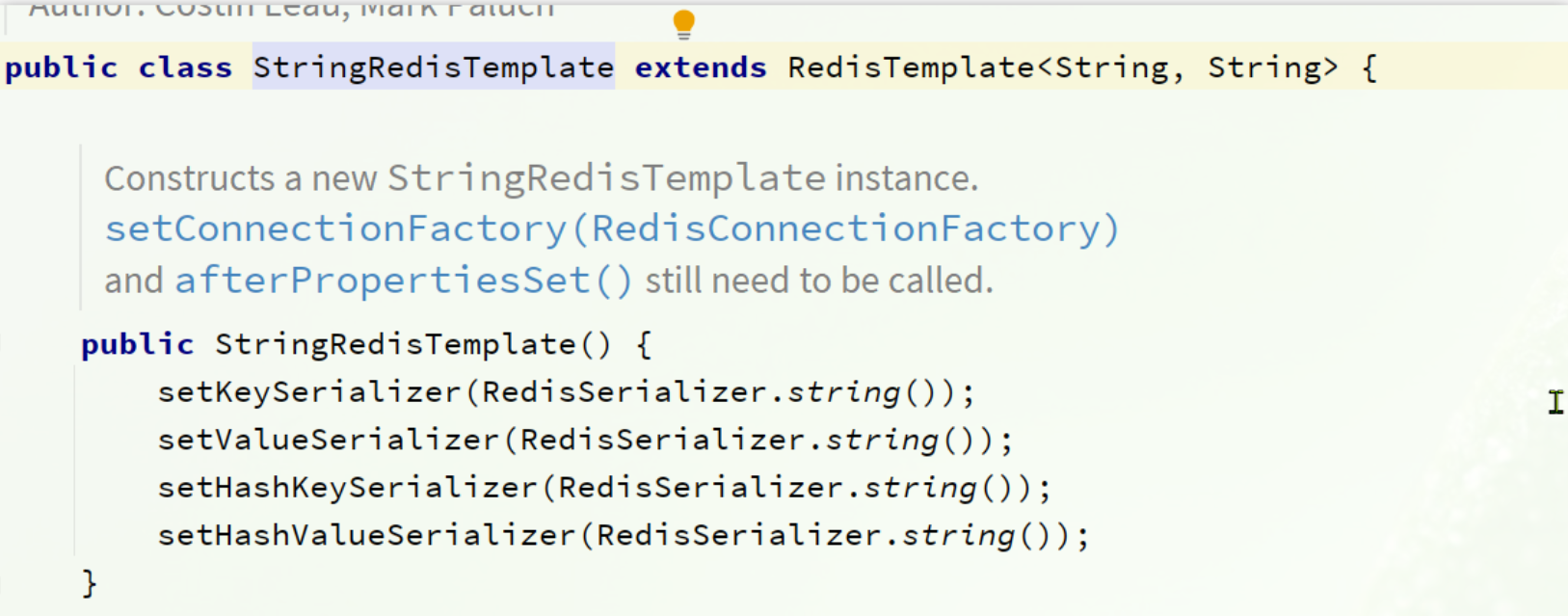

StringRedisTemplate

为了节省内存空间,我们可以不使用JSON序列化器来处理value,而是统一使用String序列化器,要求只能存储String类型的key和value。当需要存储Java对象时,手动完成对象的序列化和反序列化。

因为存入和读取时的序列化及反序列化都是我们自己实现的,SpringDataRedis就不会将class信息写入Redis了。

这种用法比较普遍,因此SpringDataRedis就提供了RedisTemplate的子类:StringRedisTemplate,它的key和value的序列化方式默认就是String方式。

省去了我们自定义RedisTemplate的序列化方式的步骤,而是直接使用:

@Autowired

private StringRedisTemplate stringRedisTemplate;

// JSON序列化工具

private static final ObjectMapper mapper = new ObjectMapper();

@Test

void testSaveUser() throws JsonProcessingException {

// 创建对象

User user = new User("虎哥", 21);

// 手动序列化

String json = mapper.writeValueAsString(user);

// 写入数据

stringRedisTemplate.opsForValue().set("user:200", json);

// 获取数据

String jsonUser = stringRedisTemplate.opsForValue().get("user:200");

// 手动反序列化

User user1 = mapper.readValue(jsonUser, User.class);

System.out.println("user1 = " + user1);

}场景运用

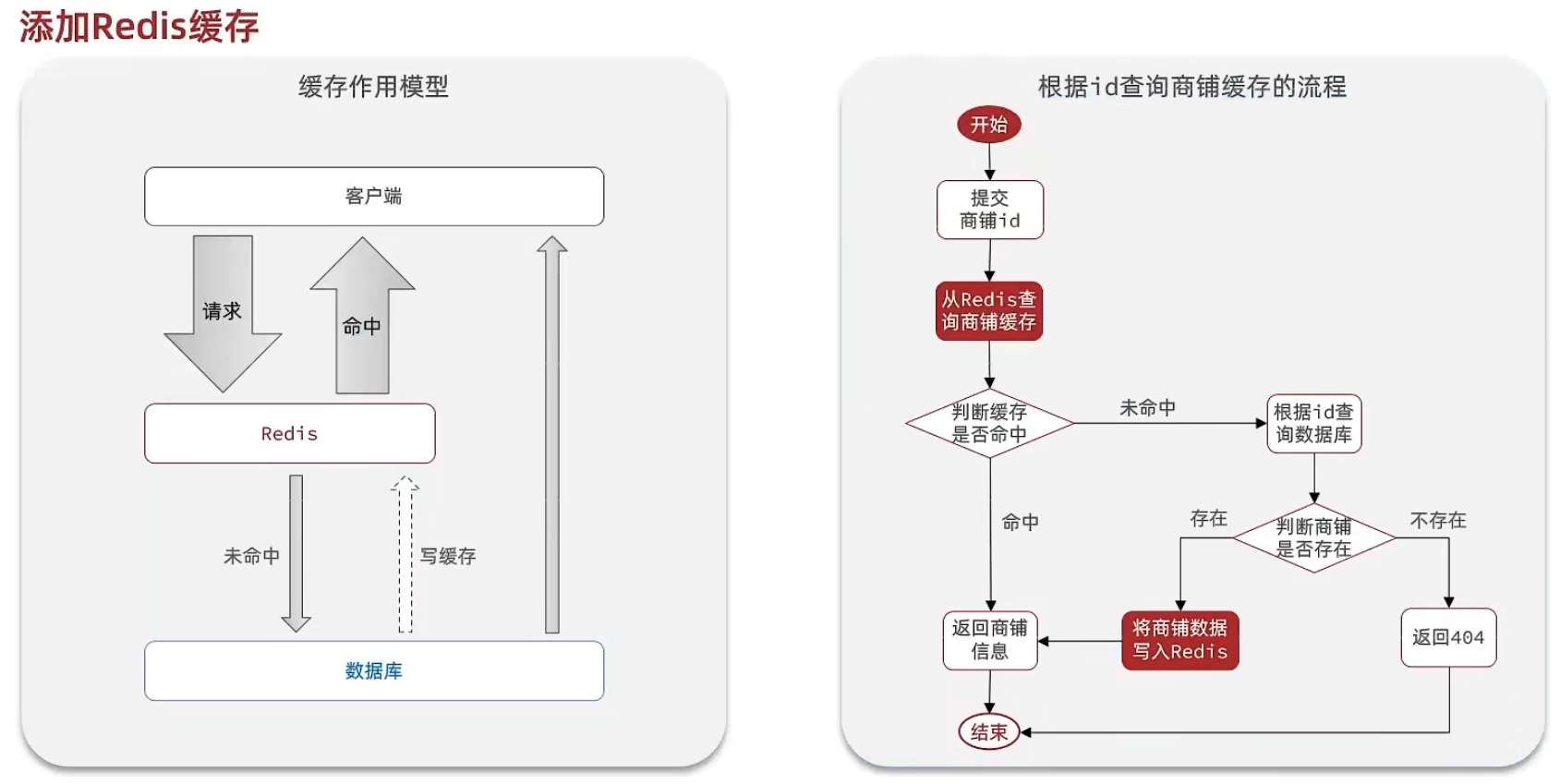

商户查询缓存

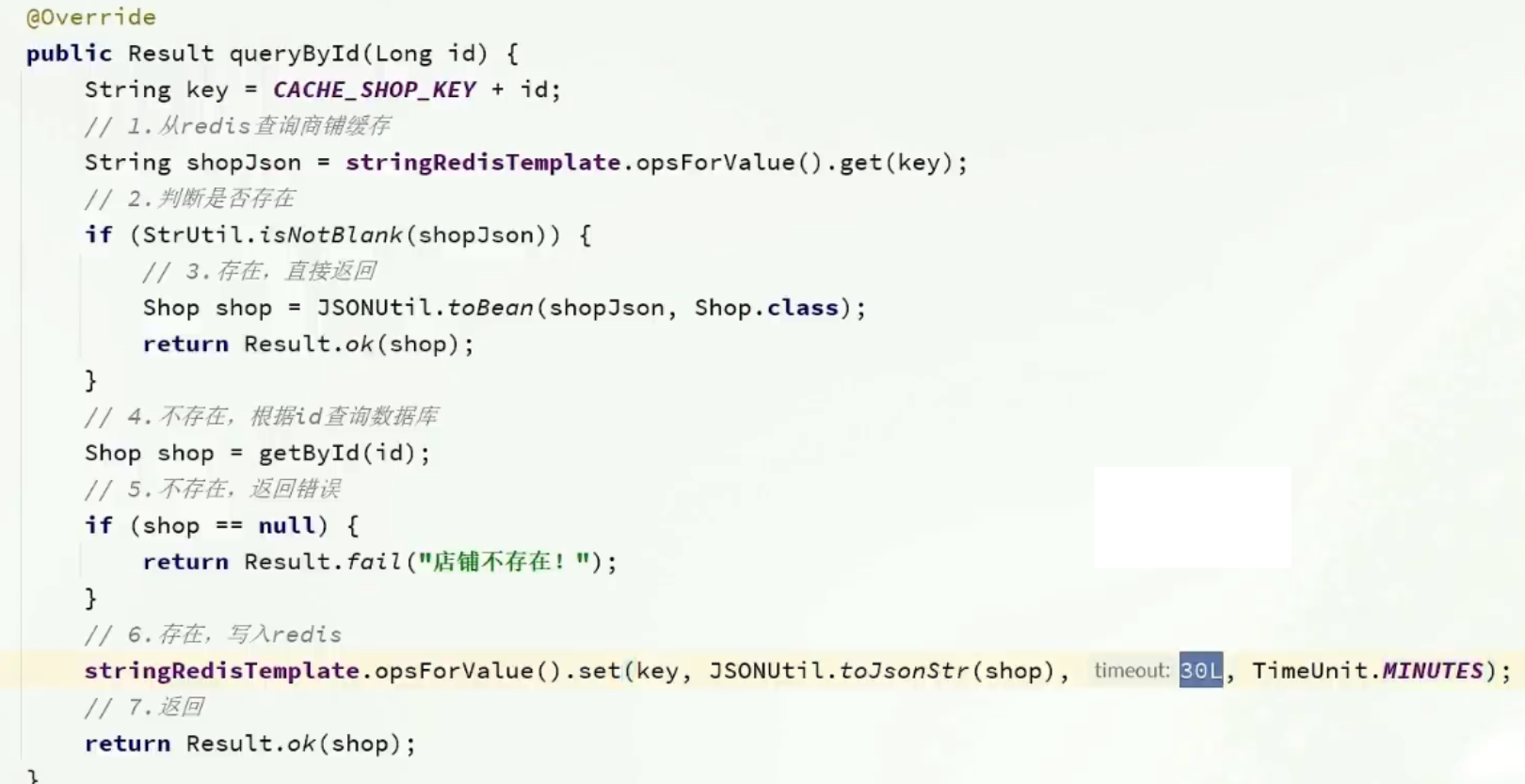

标准的操作方式就是查询数据库之前先查询缓存,如果缓存数据存在,则直接从缓存中返回,如果缓存数据不存在,再查询数据库,然后将数据存入redis。

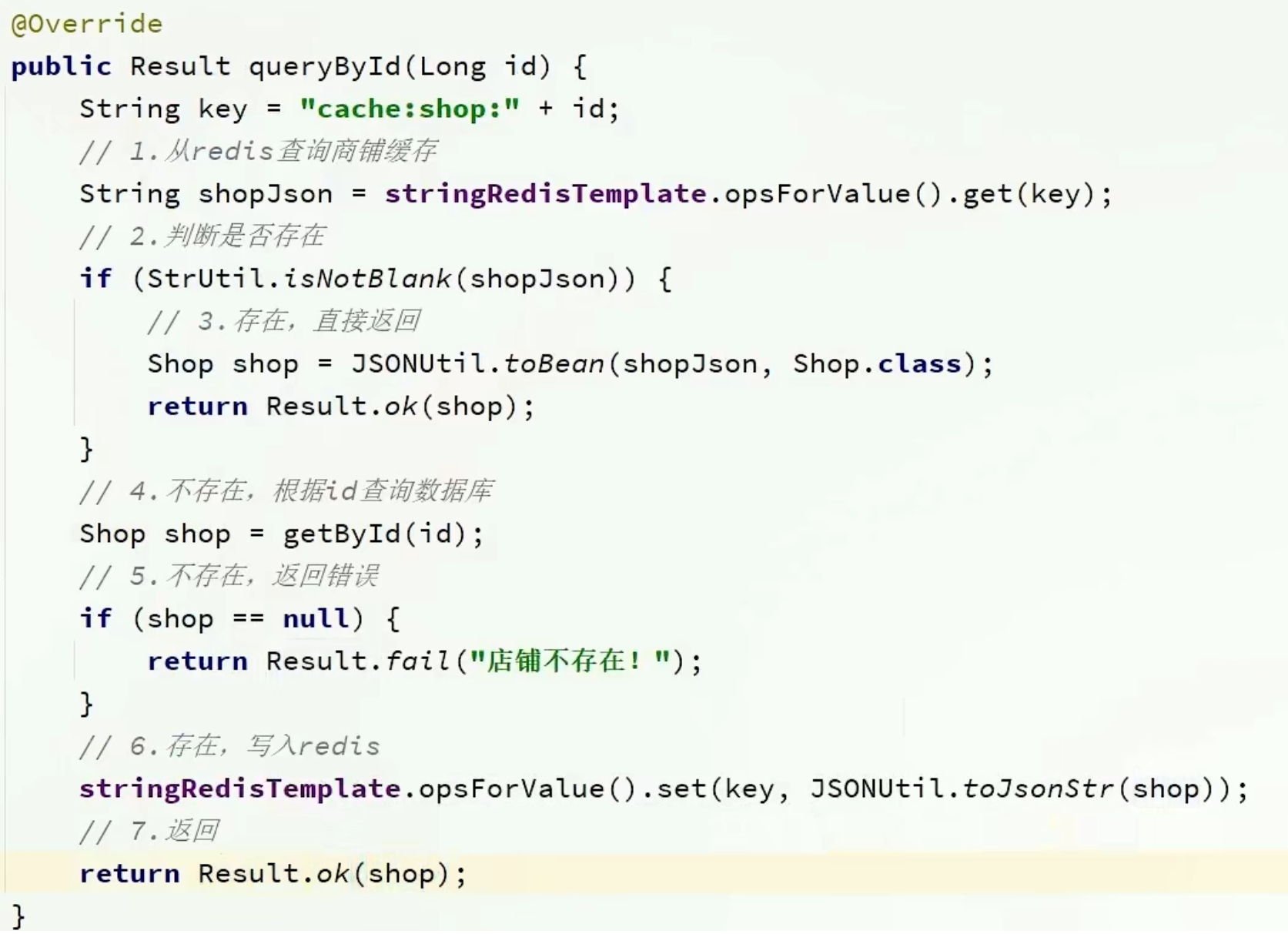

核心实现

代码思路:如果缓存有,则直接返回,如果缓存不存在,则查询数据库,然后存入redis。

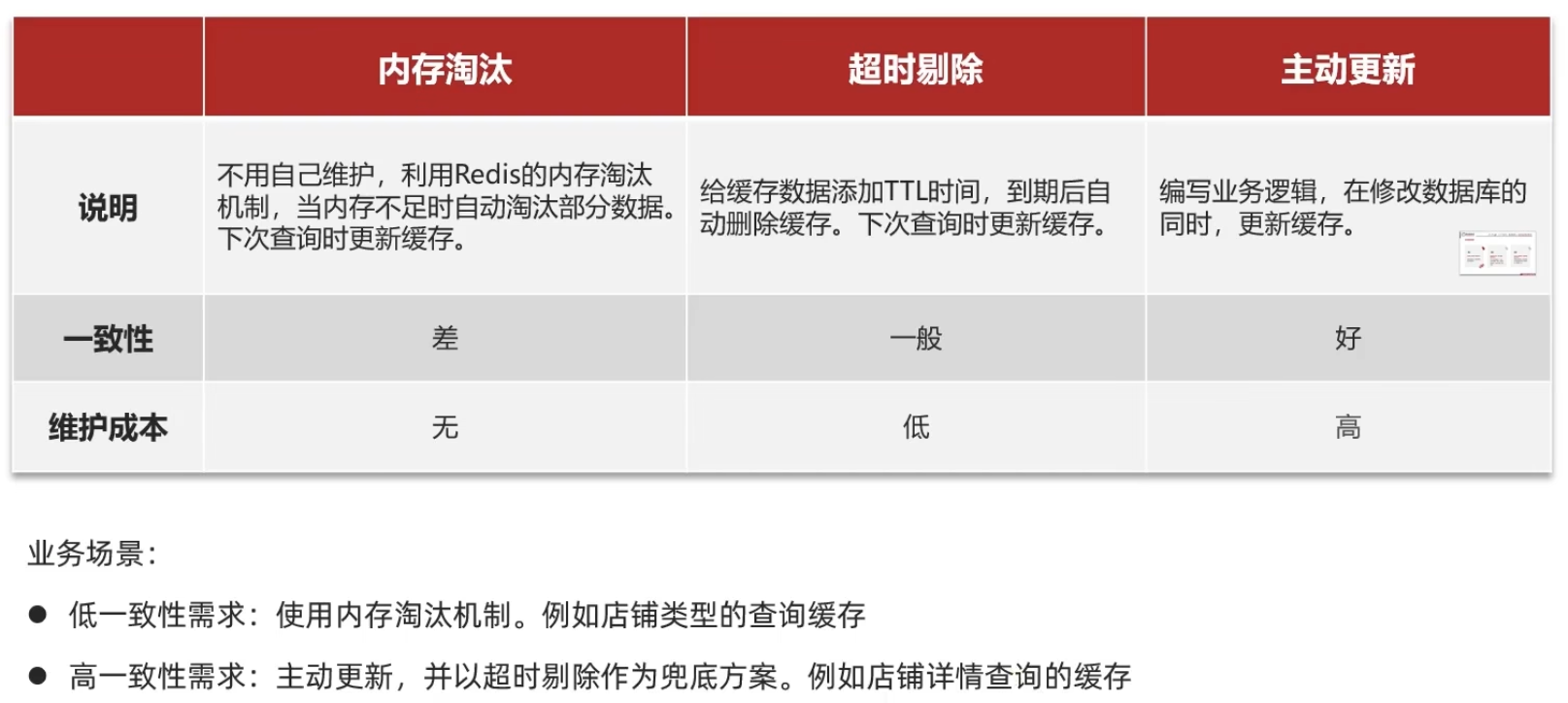

缓存更新策略

缓存更新是redis为了节约内存而设计出来的一个东西,主要是因为内存数据宝贵,当我们向redis插入太多数据,此时就可能会导致缓存中的数据过多,所以redis会对部分数据进行更新,或者把他叫为淘汰更合适。

内存淘汰: redis自动进行,当redis内存达到咱们设定的max-memery的时候,会自动触发淘汰机制,淘汰掉一些不重要的数据(可以自己设置策略方式)。

超时剔除: 当我们给redis设置了过期时间ttl之后,redis会将超时的数据进行删除,方便咱们继续使用缓存。

主动更新: 我们可以手动调用方法把缓存删掉,通常用于解决缓存和数据库不一致问题。

数据库缓存不一致解决方案

由于我们的缓存的数据源来自于数据库,而数据库的数据是会发生变化的,因此,如果当数据库中数据发生变化,而缓存却没有同步,此时就会有一致性问题存在,其后果是:

用户使用缓存中的过时数据,就会产生类似多线程数据安全问题,从而影响业务,产品口碑等;怎么解决呢?有如下几种方案

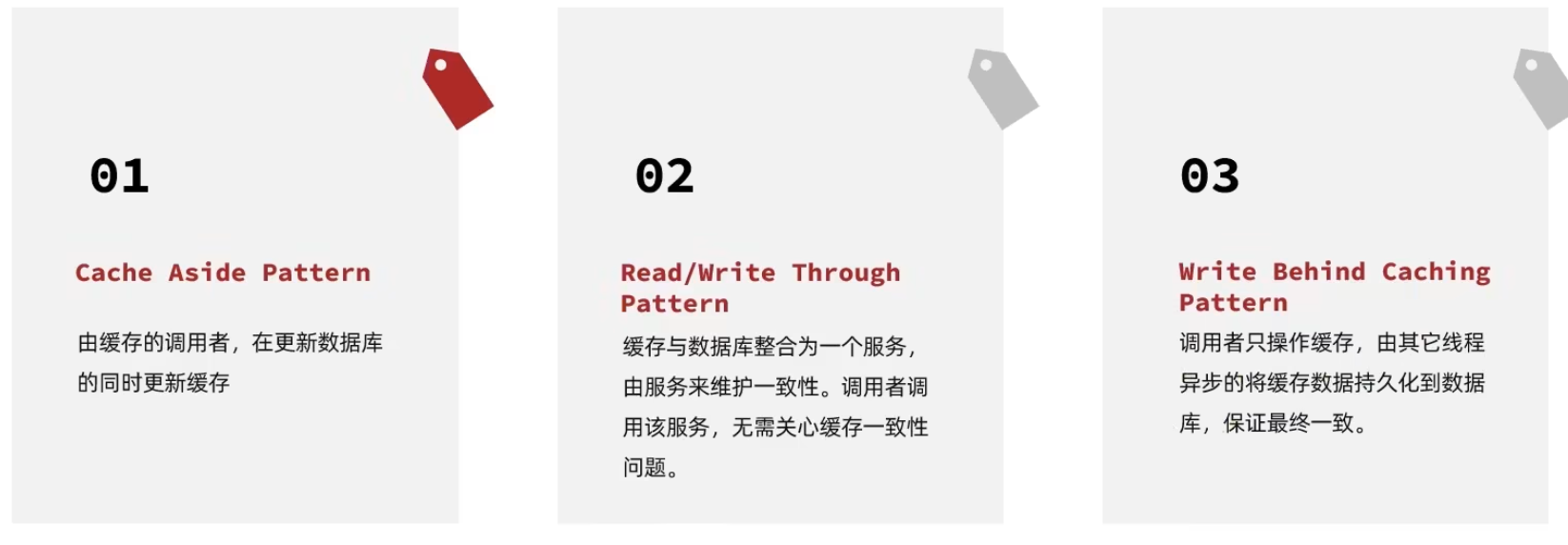

综合考虑使用方案一,但是方案一调用者如何处理呢?这里有几个问题

操作缓存和数据库时有三个问题需要考虑:

如果采用第一个方案,那么假设我们每次操作数据库后,都操作缓存,但是中间如果没有人查询,那么这个更新动作实际上只有最后一次生效,中间的更新动作意义并不大,我们可以把缓存删除,等待再次查询时,将缓存中的数据加载出来

删除缓存还是更新缓存?

更新缓存:每次更新数据库都更新缓存,无效写操作较多

删除缓存:更新数据库时让缓存失效,查询时再更新缓存

如何保证缓存与数据库的操作的同时成功或失败?

单体系统,将缓存与数据库操作放在一个事务

分布式系统,利用TCC等分布式事务方案

应该具体操作缓存还是操作数据库,我们应当是先操作数据库,再删除缓存,原因在于,如果你选择第一种方案,在两个线程并发来访问时,假设线程1先来,他先把缓存删了,此时线程2过来,他查询缓存数据并不存在,此时他写入缓存,当他写入缓存后,线程1再执行更新动作时,实际上写入的就是旧的数据,新的数据被旧数据覆盖了。

先操作缓存还是先操作数据库?

先删除缓存,再操作数据库

先操作数据库,再删除缓存

综合考虑还是先操作数据库,再删除缓存更优。

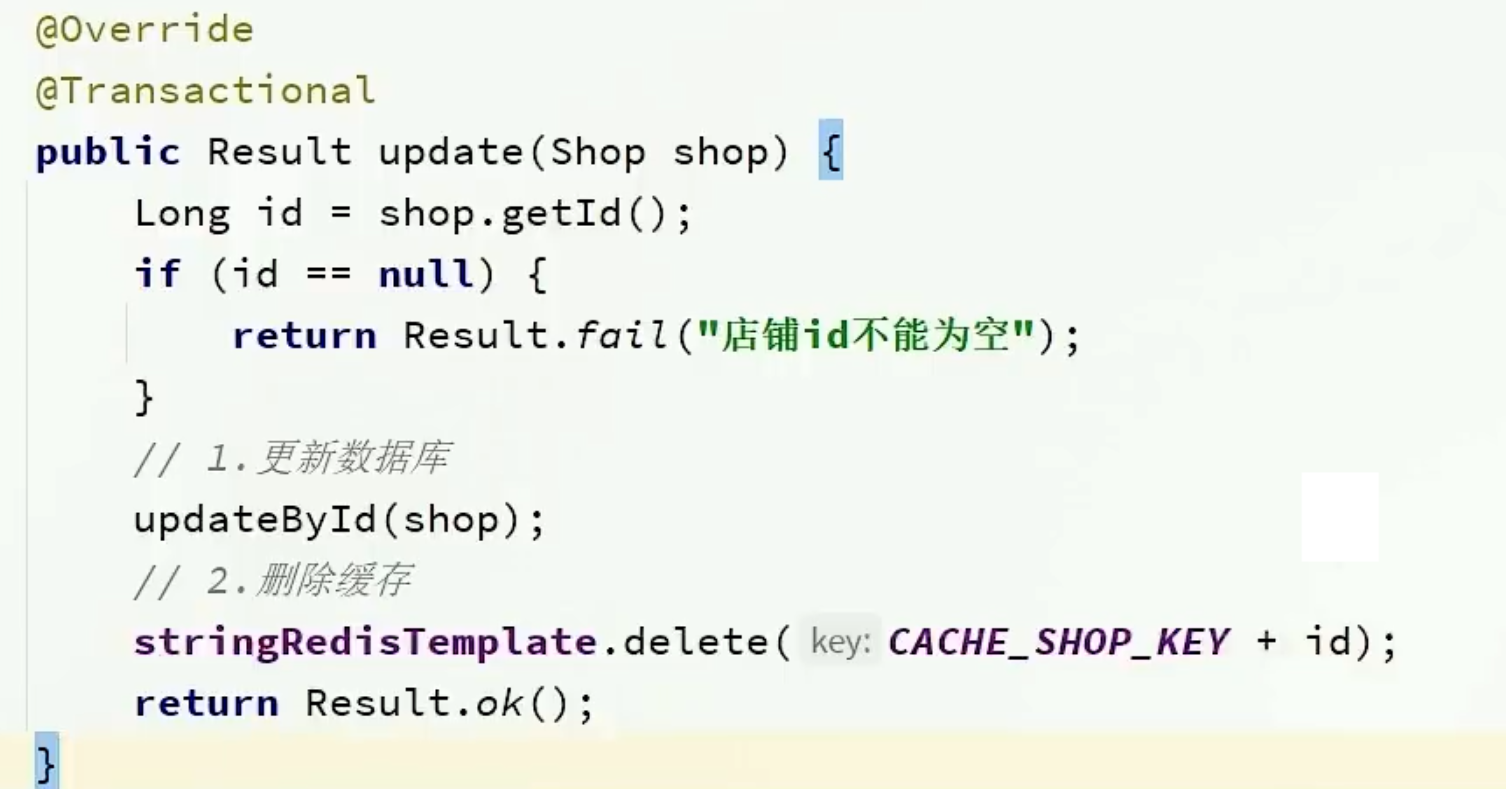

双写一致&解决思路

根据id查询店铺时,如果缓存未命中,则查询数据库,将数据库结果写入缓存,并设置超时时间

根据id修改店铺时,先修改数据库,再删除缓存

修改重点代码1:修改ShopServiceImpl的queryById方法

设置redis缓存时添加过期时间

修改重点代码2

代码分析:通过之前的淘汰,我们确定了采用删除策略,来解决双写问题,当我们修改了数据之后,然后把缓存中的数据进行删除,查询时发现缓存中没有数据,则会从mysql中加载最新的数据,从而避免数据库和缓存不一致的问题。

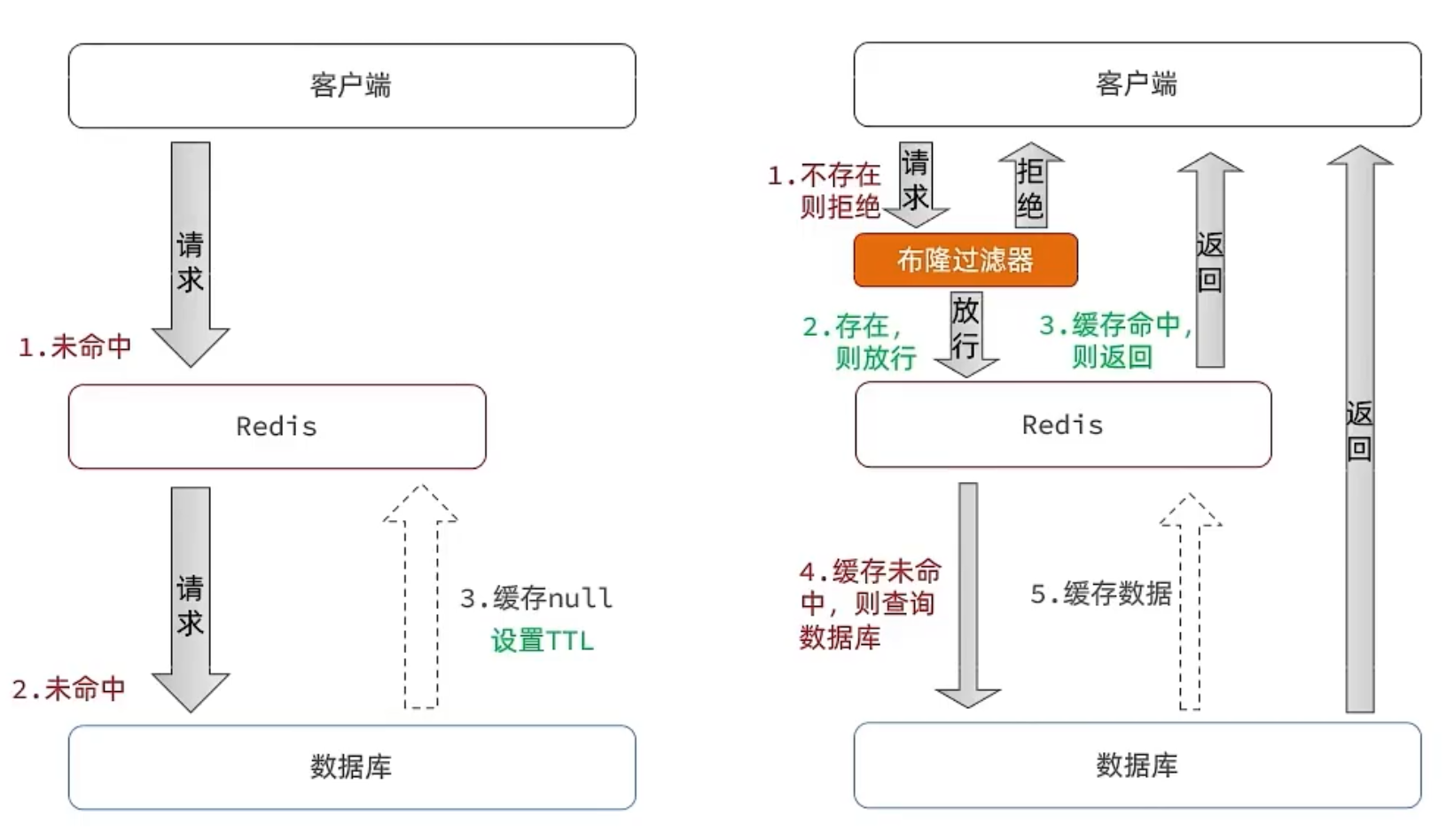

缓存穿透&解决思路

缓存穿透 :缓存穿透是指客户端请求的数据在缓存中和数据库中都不存在,这样缓存永远不会生效,这些请求都会打到数据库。

常见的解决方案有两种:

缓存空对象

优点:实现简单,维护方便

缺点:

额外的内存消耗

可能造成短期的不一致

布隆过滤

优点:内存占用较少,没有多余key

缺点:

实现复杂

存在误判可能

缓存空对象思路分析: 当我们客户端访问不存在的数据时,先请求redis,但是此时redis中没有数据,此时会访问到数据库,但是数据库中也没有数据,这个数据穿透了缓存,直击数据库,我们都知道数据库能够承载的并发不如redis这么高,如果大量的请求同时过来访问这种不存在的数据,这些请求就都会访问到数据库,简单的解决方案就是哪怕这个数据在数据库中也不存在,我们也把这个数据存入到redis中去,这样,下次用户过来访问这个不存在的数据,那么在redis中也能找到这个数据就不会进入到缓存了

布隆过滤: 布隆过滤器其实采用的是哈希思想来解决这个问题,通过一个庞大的二进制数组,走哈希思想去判断当前这个要查询的这个数据是否存在,如果布隆过滤器判断存在,则放行,这个请求会去访问redis,哪怕此时redis中的数据过期了,但是数据库中一定存在这个数据,在数据库中查询出来这个数据后,再将其放入到redis中,假设布隆过滤器判断这个数据不存在,则直接返回。这种方式优点在于节约内存空间,存在误判,误判原因在于:布隆过滤器走的是哈希思想,只要哈希思想,就可能存在哈希冲突。

总结

缓存穿透产生的原因是什么?

- 用户请求的数据在缓存中和数据库中都不存在,不断发起这样的请求,给数据库带来巨大压力

缓存穿透的解决方案有哪些?

缓存null值

布隆过滤

增强id的复杂度,避免被猜测id规律

做好数据的基础格式校验

加强用户权限校验

做好热点参数的限流

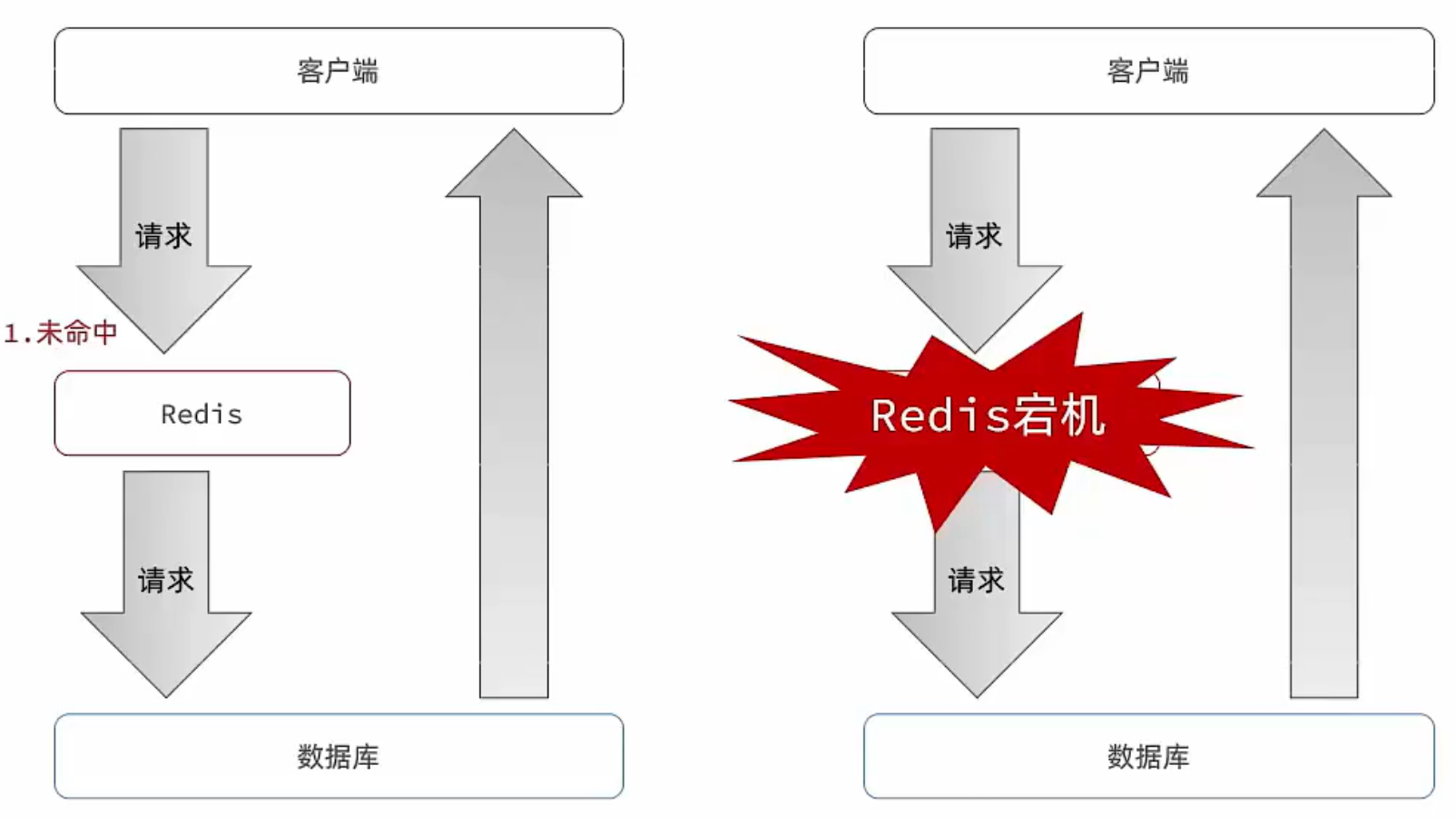

缓存雪崩&解决思路

缓存雪崩是指在同一时段大量的缓存key同时失效或者Redis服务宕机,导致大量请求到达数据库,带来巨大压力。

解决方案:

给不同的Key的TTL添加随机值

利用Redis集群提高服务的可用性

给缓存业务添加降级限流策略

给业务添加多级缓存

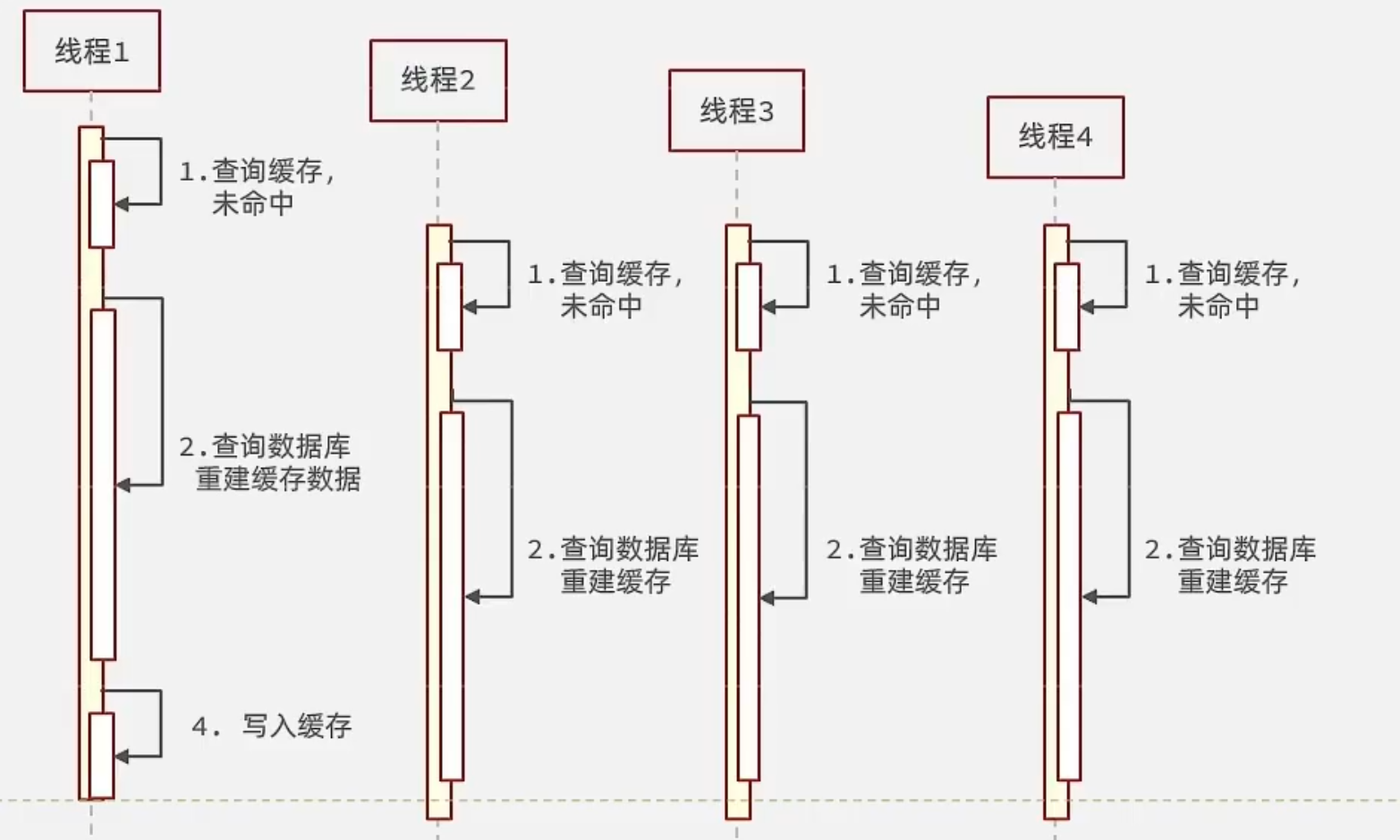

缓存击穿&解决思路

缓存击穿问题也叫热点Key问题,就是一个被高并发访问并且缓存重建业务较复杂的key突然失效了,无数的请求访问会在瞬间给数据库带来巨大的冲击。

常见的解决方案有两种:

互斥锁

逻辑过期

逻辑分析:假设线程1在查询缓存之后,本来应该去查询数据库,然后把这个数据重新加载到缓存的,此时只要线程1走完这个逻辑,其他线程就都能从缓存中加载这些数据了,但是假设在线程1没有走完的时候,后续的线程2,线程3,线程4同时过来访问当前这个方法, 那么这些线程都不能从缓存中查询到数据,那么他们就会同一时刻来访问查询缓存,都没查到,接着同一时间去访问数据库,同时的去执行数据库代码,对数据库访问压力过大

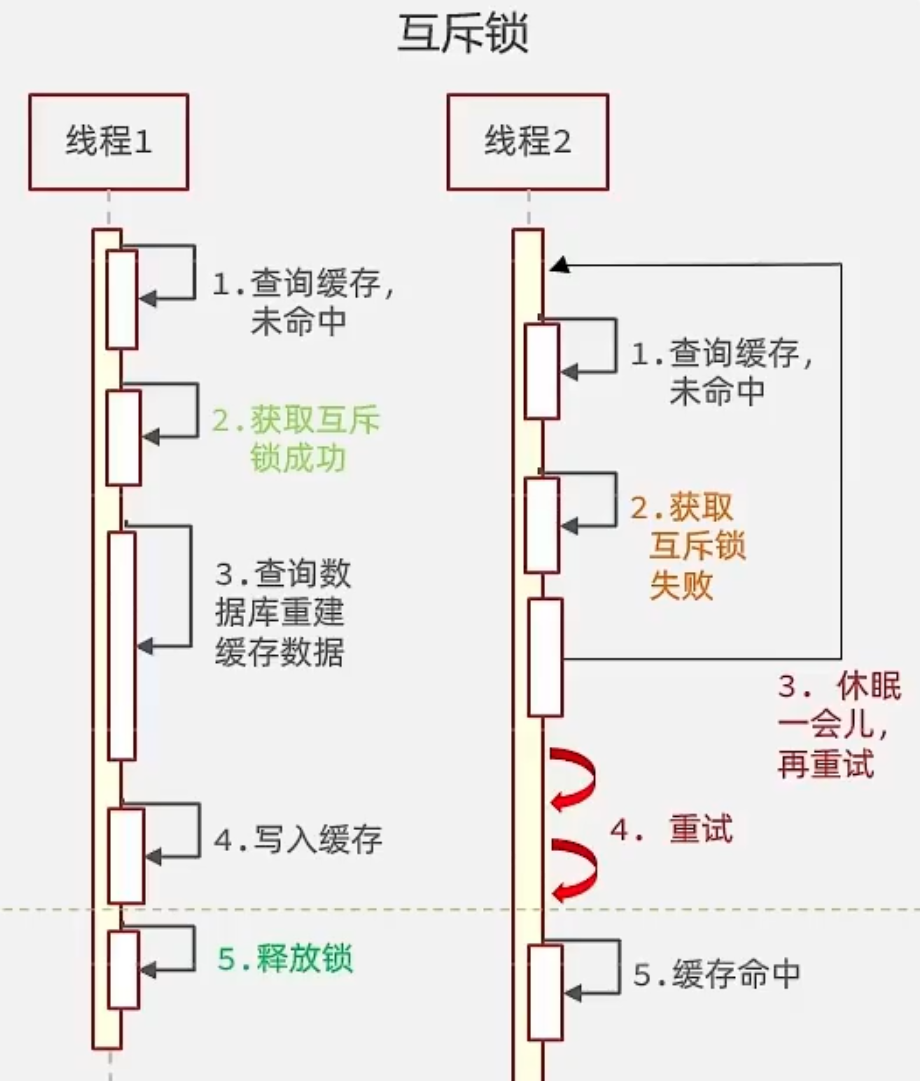

互斥锁

解决方案一、使用锁来解决:

因为锁能实现互斥性。假设线程过来,只能一个人一个人的来访问数据库,从而避免对于数据库访问压力过大,但这也会影响查询的性能,因为此时会让查询的性能从并行变成了串行,我们可以采用tryLock方法 + double check来解决这样的问题。

假设现在线程1过来访问,他查询缓存没有命中,但是此时他获得到了锁的资源,那么线程1就会一个人去执行逻辑,假设现在线程2过来,线程2在执行过程中,并没有获得到锁,那么线程2就可以进行到休眠,直到线程1把锁释放后,线程2获得到锁,然后再来执行逻辑,此时就能够从缓存中拿到数据了。

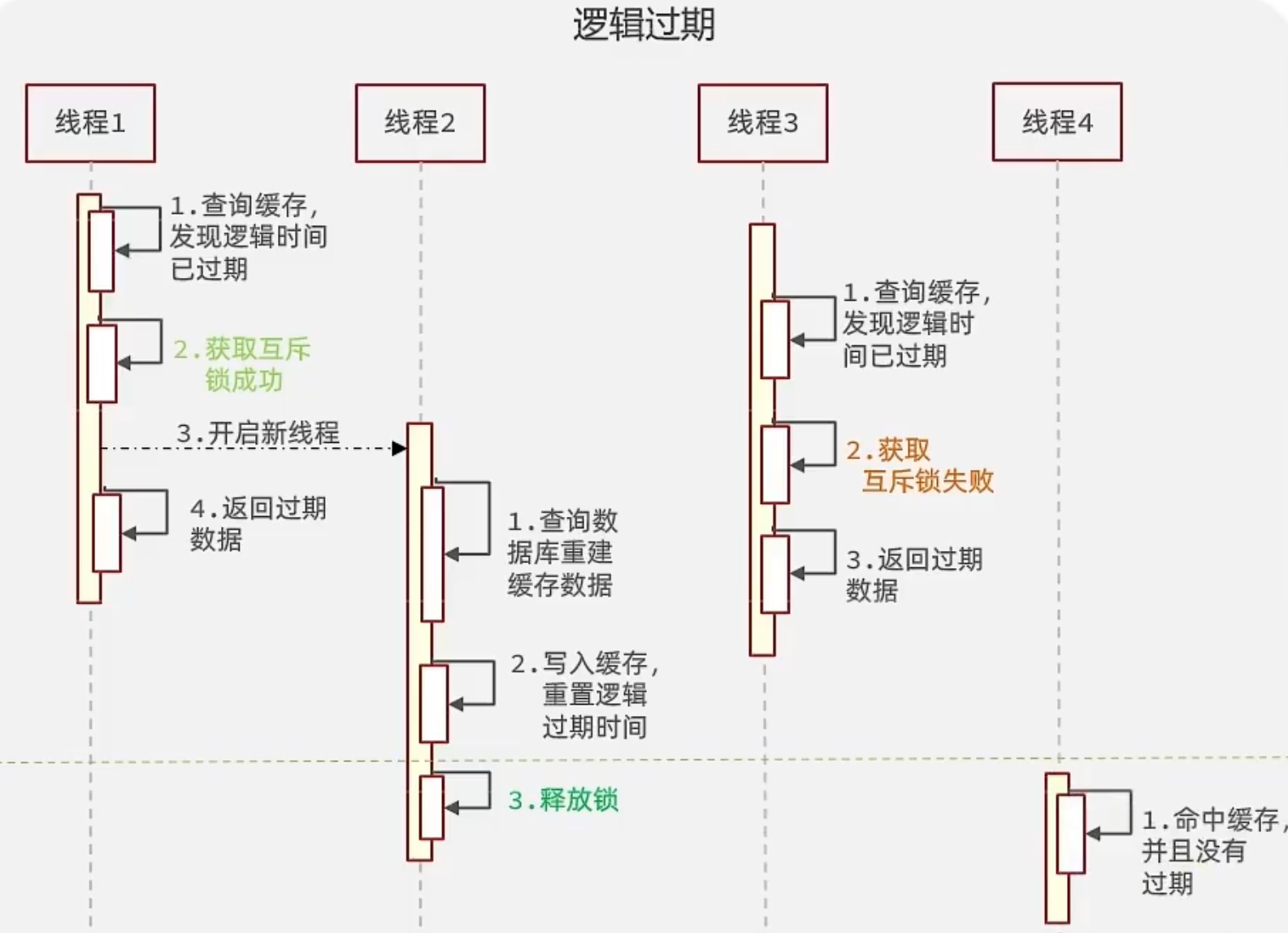

逻辑过期

解决方案二、逻辑过期方案

方案分析:我们之所以会出现这个缓存击穿问题,主要原因是在于我们对key设置了过期时间,假设我们不设置过期时间,其实就不会有缓存击穿的问题,但是不设置过期时间,这样数据不就一直占用我们内存了吗,我们可以采用逻辑过期方案。

我们把过期时间设置在 redis的value中,注意:这个过期时间并不会直接作用于redis,而是我们后续通过逻辑去处理。假设线程1去查询缓存,然后从value中判断出来当前的数据已经过期了,此时线程1去获得互斥锁,那么其他线程会进行阻塞,获得了锁的线程他会开启一个 线程去进行 以前的重构数据的逻辑,直到新开的线程完成这个逻辑后,才释放锁, 而线程1直接进行返回,假设现在线程3过来访问,由于线程线程2持有着锁,所以线程3无法获得锁,线程3也直接返回数据,只有等到新开的线程2把重建数据构建完后,其他线程才能走返回正确的数据。

这种方案巧妙在于 ,异步的构建缓存,缺点在于在构建完缓存之前,返回的都是脏数据。

方案对比

互斥锁方案: 由于保证了互斥性,所以数据一致,且实现简单,因为仅仅只需要加一把锁而已,也没其他的事情需要操心,所以没有额外的内存消耗,缺点在于有锁就有死锁问题的发生,且只能串行执行性能肯定受到影响。

逻辑过期方案: 线程读取过程中不需要等待,性能好,有一个额外的线程持有锁去进行重构数据,但是在重构数据完成前,其他的线程只能返回之前的数据,且实现起来比较复杂。

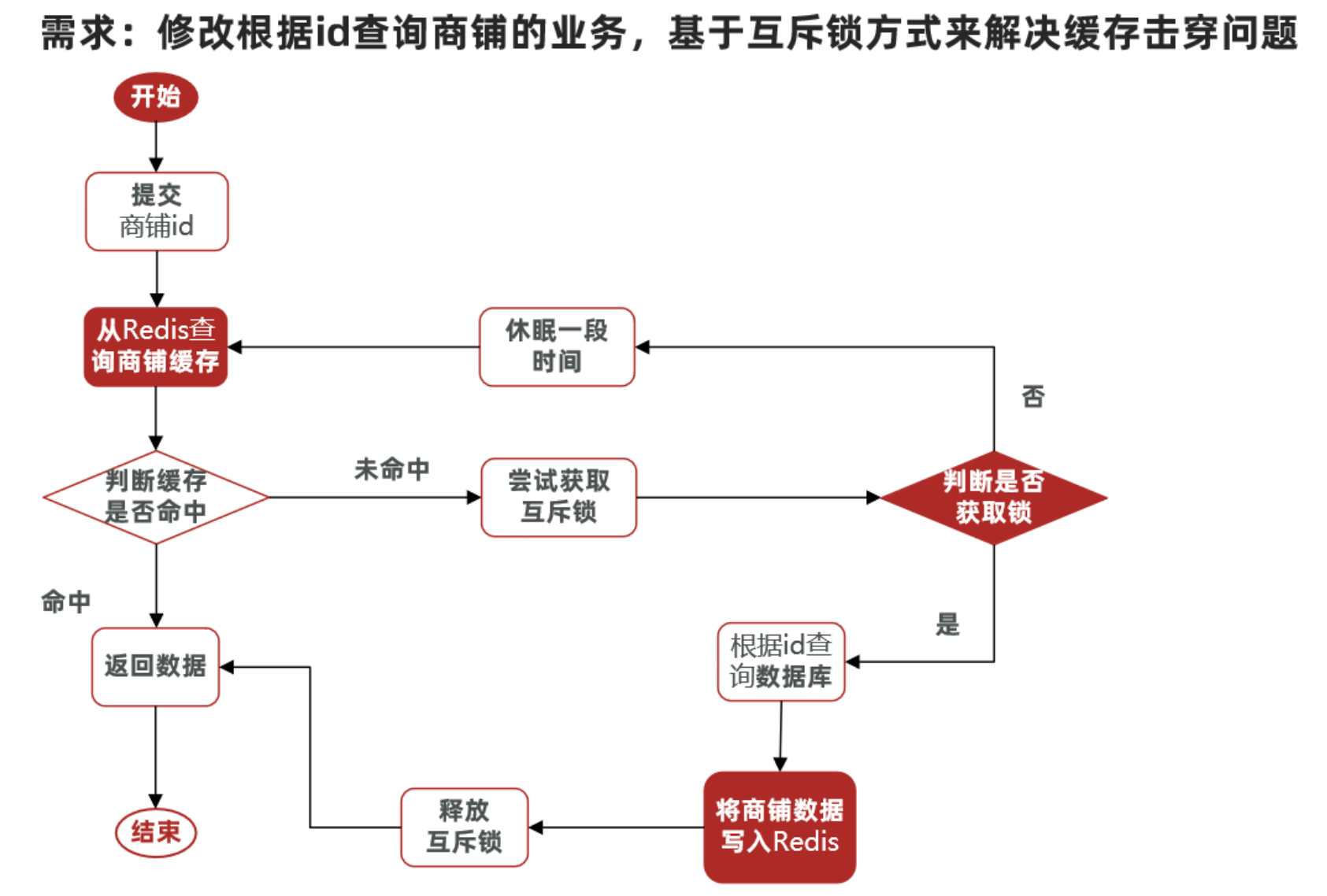

互斥锁实现

核心思路:相较于原来从缓存中查询不到数据后直接查询数据库而言,现在的方案是 进行查询之后,如果从缓存没有查询到数据,则进行互斥锁的获取,获取互斥锁后,判断是否获得到了锁,如果没有获得到,则休眠,过一会再进行尝试,直到获取到锁为止,才能进行查询

如果获取到了锁的线程,再去进行查询,查询后将数据写入redis,再释放锁,返回数据,利用互斥锁就能保证只有一个线程去执行操作数据库的逻辑,防止缓存击穿。

操作锁的代码:

核心思路就是利用redis的setnx方法来表示获取锁,该方法含义是redis中如果没有这个key,则插入成功,返回1,在stringRedisTemplate中返回true, 如果有这个key则插入失败,则返回0,在stringRedisTemplate返回false,我们可以通过true,或者是false,来表示是否有线程成功插入key,成功插入的key的线程我们认为他就是获得到锁的线程。

private boolean tryLock(String key) {

Boolean flag = stringRedisTemplate.opsForValue().setIfAbsent(key, "1", 10, TimeUnit.SECONDS);

return BooleanUtil.isTrue(flag);

}

private void unlock(String key) {

stringRedisTemplate.delete(key);

}操作代码:

public Shop queryWithMutex(Long id) {

String key = CACHE_SHOP_KEY + id;

// 1、从redis中查询商铺缓存

String shopJson = stringRedisTemplate.opsForValue().get("key");

// 2、判断是否存在

if (StrUtil.isNotBlank(shopJson)) {

// 存在,直接返回

return JSONUtil.toBean(shopJson, Shop.class);

}

//判断命中的值是否是空值

if (shopJson != null) {

//返回一个错误信息

return null;

}

// 4.实现缓存重构

//4.1 获取互斥锁

String lockKey = "lock:shop:" + id;

Shop shop = null;

try {

boolean isLock = tryLock(lockKey);

// 4.2 判断否获取成功

if(!isLock){

//4.3 失败,则休眠重试

Thread.sleep(50);

return queryWithMutex(id);

}

//4.4 成功,根据id查询数据库

shop = getById(id);

// 5.不存在,返回错误

if(shop == null){

//将空值写入redis

stringRedisTemplate.opsForValue().set(key,"",CACHE_NULL_TTL,TimeUnit.MINUTES);

//返回错误信息

return null;

}

//6.写入redis

stringRedisTemplate.opsForValue().set(key,JSONUtil.toJsonStr(shop),CACHE_NULL_TTL,TimeUnit.MINUTES);

}catch (Exception e){

throw new RuntimeException(e);

}

finally {

//7.释放互斥锁

unlock(lockKey);

}

return shop;

}逻辑过期实现

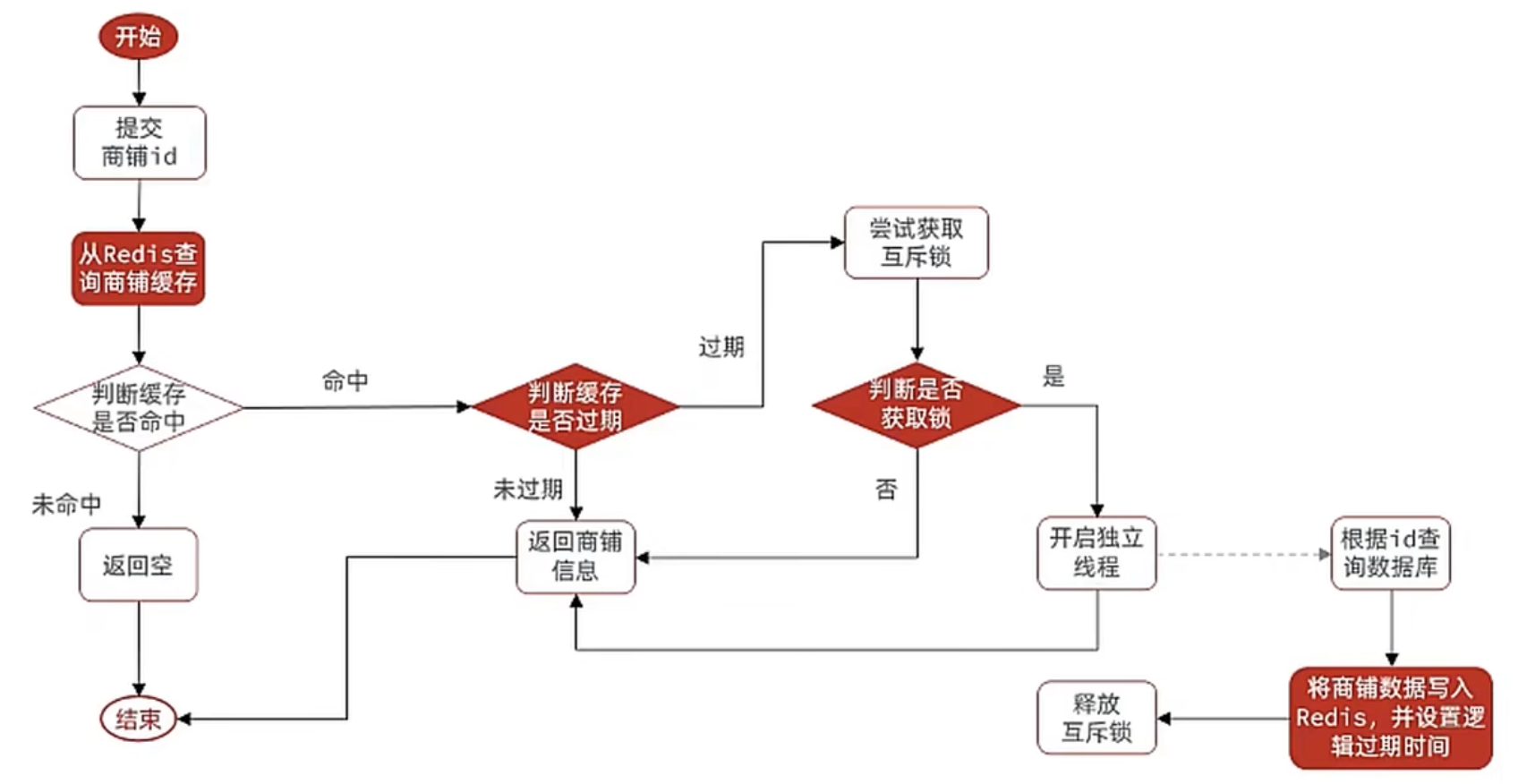

需求:修改根据id查询商铺的业务,基于逻辑过期方式来解决缓存击穿问题

思路分析:当用户开始查询redis时,判断是否命中,如果没有命中则直接返回空数据,不查询数据库,而一旦命中后,将value取出,判断value中的过期时间是否满足,如果没有过期,则直接返回redis中的数据,如果过期,则在开启独立线程后直接返回之前的数据,独立线程去重构数据,重构完成后释放互斥锁。

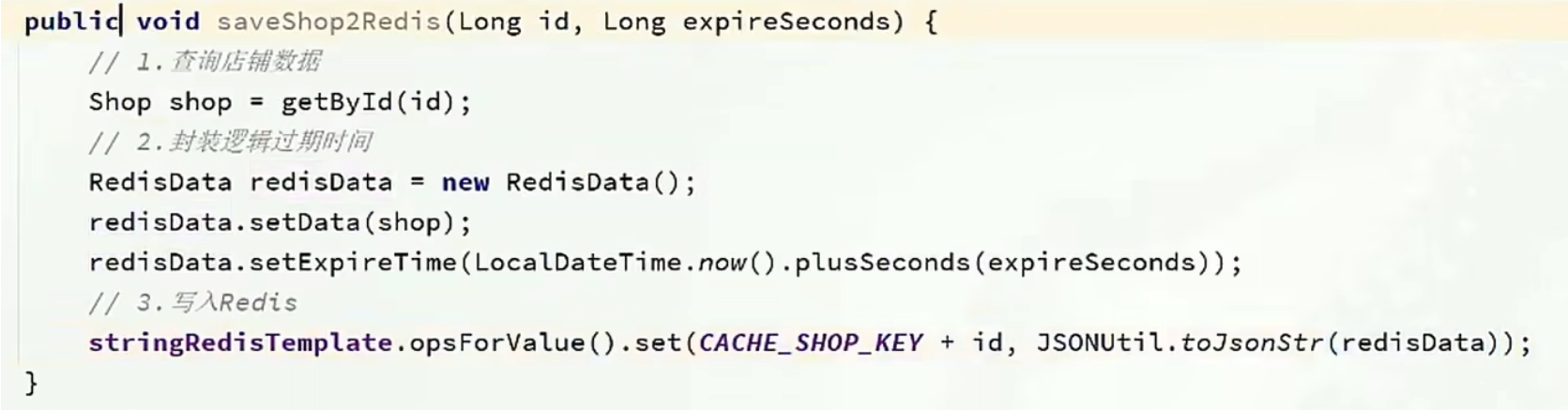

步骤一、

如果封装数据:因为现在redis中存储的数据的value需要带上过期时间,此时要么你去修改原来的实体类,要么你新建一个实体类,我们采用第二个方案,这个方案,对原来代码没有侵入性。

@Data

public class RedisData {

private LocalDateTime expireTime;

private Object data;

}步骤二、

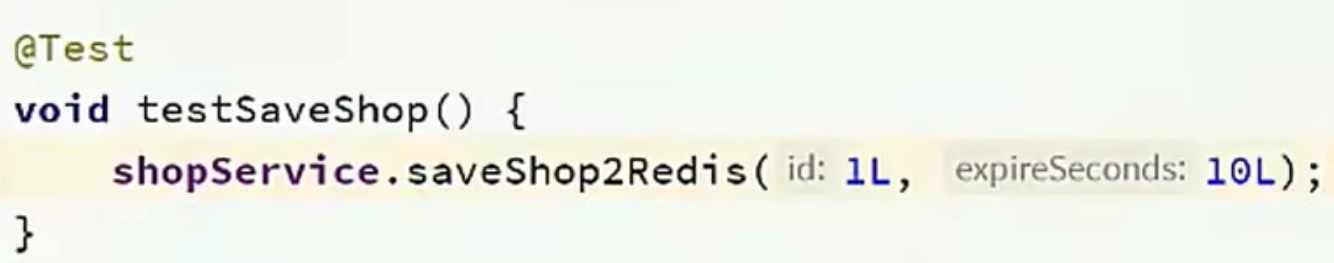

在ShopServiceImpl 新增此方法,利用单元测试进行缓存预热

在测试类中

步骤三

ShopServiceImpl

private static final ExecutorService CACHE_REBUILD_EXECUTOR = Executors.newFixedThreadPool(10);

public Shop queryWithLogicalExpire( Long id ) {

String key = CACHE_SHOP_KEY + id;

// 1.从redis查询商铺缓存

String json = stringRedisTemplate.opsForValue().get(key);

// 2.判断是否存在

if (StrUtil.isBlank(json)) {

// 3.存在,直接返回

return null;

}

// 4.命中,需要先把json反序列化为对象

RedisData redisData = JSONUtil.toBean(json, RedisData.class);

Shop shop = JSONUtil.toBean((JSONObject) redisData.getData(), Shop.class);

LocalDateTime expireTime = redisData.getExpireTime();

// 5.判断是否过期

if(expireTime.isAfter(LocalDateTime.now())) {

// 5.1.未过期,直接返回店铺信息

return shop;

}

// 5.2.已过期,需要缓存重建

// 6.缓存重建

// 6.1.获取互斥锁

String lockKey = LOCK_SHOP_KEY + id;

boolean isLock = tryLock(lockKey);

// 6.2.判断是否获取锁成功

if (isLock){

CACHE_REBUILD_EXECUTOR.submit( ()->{

try{

//重建缓存

this.saveShop2Redis(id,20L);

}catch (Exception e){

throw new RuntimeException(e);

}finally {

unlock(lockKey);

}

});

}

// 6.4.返回过期的商铺信息

return shop;

}通用Redis工具类封装

基于StringRedisTemplate封装一个缓存工具类,满足下列需求:

方法1:将任意Java对象序列化为json并存储在string类型的key中,并且可以设置TTL过期时间

方法2:将任意Java对象序列化为json并存储在string类型的key中,并且可以设置逻辑过期时间,用于处理缓存击穿问题

方法3:根据指定的key查询缓存,并反序列化为指定类型,利用缓存空值的方式解决缓存穿透问题

方法4:根据指定的key查询缓存,并反序列化为指定类型,需要利用逻辑过期解决缓存击穿问题

@Slf4j

@Component

public class CacheClient {

private final StringRedisTemplate stringRedisTemplate;

private static final ExecutorService CACHE_REBUILD_EXECUTOR = Executors.newFixedThreadPool(10);

public CacheClient(StringRedisTemplate stringRedisTemplate) {

this.stringRedisTemplate = stringRedisTemplate;

}

public void set(String key, Object value, Long time, TimeUnit unit) {

stringRedisTemplate.opsForValue().set(key, JSONUtil.toJsonStr(value), time, unit);

}

public void setWithLogicalExpire(String key, Object value, Long time, TimeUnit unit) {

// 设置逻辑过期

RedisData redisData = new RedisData();

redisData.setData(value);

redisData.setExpireTime(LocalDateTime.now().plusSeconds(unit.toSeconds(time)));

// 写入Redis

stringRedisTemplate.opsForValue().set(key, JSONUtil.toJsonStr(redisData));

}

public <R,ID> R queryWithPassThrough(

String keyPrefix, ID id, Class<R> type, Function<ID, R> dbFallback, Long time, TimeUnit unit){

String key = keyPrefix + id;

// 1.从redis查询商铺缓存

String json = stringRedisTemplate.opsForValue().get(key);

// 2.判断是否存在

if (StrUtil.isNotBlank(json)) {

// 3.存在,直接返回

return JSONUtil.toBean(json, type);

}

// 判断命中的是否是空值

if (json != null) {

// 返回一个错误信息

return null;

}

// 4.不存在,根据id查询数据库

R r = dbFallback.apply(id);

// 5.不存在,返回错误

if (r == null) {

// 将空值写入redis

stringRedisTemplate.opsForValue().set(key, "", CACHE_NULL_TTL, TimeUnit.MINUTES);

// 返回错误信息

return null;

}

// 6.存在,写入redis

this.set(key, r, time, unit);

return r;

}

public <R, ID> R queryWithLogicalExpire(

String keyPrefix, ID id, Class<R> type, Function<ID, R> dbFallback, Long time, TimeUnit unit) {

String key = keyPrefix + id;

// 1.从redis查询商铺缓存

String json = stringRedisTemplate.opsForValue().get(key);

// 2.判断是否存在

if (StrUtil.isBlank(json)) {

// 3.存在,直接返回

return null;

}

// 4.命中,需要先把json反序列化为对象

RedisData redisData = JSONUtil.toBean(json, RedisData.class);

R r = JSONUtil.toBean((JSONObject) redisData.getData(), type);

LocalDateTime expireTime = redisData.getExpireTime();

// 5.判断是否过期

if(expireTime.isAfter(LocalDateTime.now())) {

// 5.1.未过期,直接返回店铺信息

return r;

}

// 5.2.已过期,需要缓存重建

// 6.缓存重建

// 6.1.获取互斥锁

String lockKey = LOCK_SHOP_KEY + id;

boolean isLock = tryLock(lockKey);

// 6.2.判断是否获取锁成功

if (isLock){

// 6.3.成功,开启独立线程,实现缓存重建

CACHE_REBUILD_EXECUTOR.submit(() -> {

try {

// 查询数据库

R newR = dbFallback.apply(id);

// 重建缓存

this.setWithLogicalExpire(key, newR, time, unit);

} catch (Exception e) {

throw new RuntimeException(e);

}finally {

// 释放锁

unlock(lockKey);

}

});

}

// 6.4.返回过期的商铺信息

return r;

}

public <R, ID> R queryWithMutex(

String keyPrefix, ID id, Class<R> type, Function<ID, R> dbFallback, Long time, TimeUnit unit) {

String key = keyPrefix + id;

// 1.从redis查询商铺缓存

String shopJson = stringRedisTemplate.opsForValue().get(key);

// 2.判断是否存在

if (StrUtil.isNotBlank(shopJson)) {

// 3.存在,直接返回

return JSONUtil.toBean(shopJson, type);

}

// 判断命中的是否是空值

if (shopJson != null) {

// 返回一个错误信息

return null;

}

// 4.实现缓存重建

// 4.1.获取互斥锁

String lockKey = LOCK_SHOP_KEY + id;

R r = null;

try {

boolean isLock = tryLock(lockKey);

// 4.2.判断是否获取成功

if (!isLock) {

// 4.3.获取锁失败,休眠并重试

Thread.sleep(50);

return queryWithMutex(keyPrefix, id, type, dbFallback, time, unit);

}

// 4.4.获取锁成功,根据id查询数据库

r = dbFallback.apply(id);

// 5.不存在,返回错误

if (r == null) {

// 将空值写入redis

stringRedisTemplate.opsForValue().set(key, "", CACHE_NULL_TTL, TimeUnit.MINUTES);

// 返回错误信息

return null;

}

// 6.存在,写入redis

this.set(key, r, time, unit);

} catch (InterruptedException e) {

throw new RuntimeException(e);

}finally {

// 7.释放锁

unlock(lockKey);

}

// 8.返回

return r;

}

private boolean tryLock(String key) {

Boolean flag = stringRedisTemplate.opsForValue().setIfAbsent(key, "1", 10, TimeUnit.SECONDS);

return BooleanUtil.isTrue(flag);

}

private void unlock(String key) {

stringRedisTemplate.delete(key);

}

}在ShopServiceImpl 中使用:

@Resource

private CacheClient cacheClient;

@Override

public Result queryById(Long id) {

// 解决缓存穿透

Shop shop = cacheClient

.queryWithPassThrough(CACHE_SHOP_KEY, id, Shop.class, this::getById, CACHE_SHOP_TTL, TimeUnit.MINUTES);

// 互斥锁解决缓存击穿

// Shop shop = cacheClient

// .queryWithMutex(CACHE_SHOP_KEY, id, Shop.class, this::getById, CACHE_SHOP_TTL, TimeUnit.MINUTES);

// 逻辑过期解决缓存击穿

// Shop shop = cacheClient

// .queryWithLogicalExpire(CACHE_SHOP_KEY, id, Shop.class, this::getById, 20L, TimeUnit.SECONDS);

if (shop == null) {

return Result.fail("店铺不存在!");

}

// 7.返回

return Result.ok(shop);

}实现全局唯一ID

场景分析:如果我们的id具有太明显的规则,用户或者说商业对手很容易猜测出来我们的一些敏感信息,比如商城在一天时间内,卖出了多少单,这明显不合适。

场景分析二:随着我们商城规模越来越大,mysql的单表的容量不宜超过500W,数据量过大之后,我们要进行拆库拆表,但拆分表了之后,他们从逻辑上讲他们是同一张表,所以他们的id是不能一样的, 于是乎我们需要保证id的唯一性。

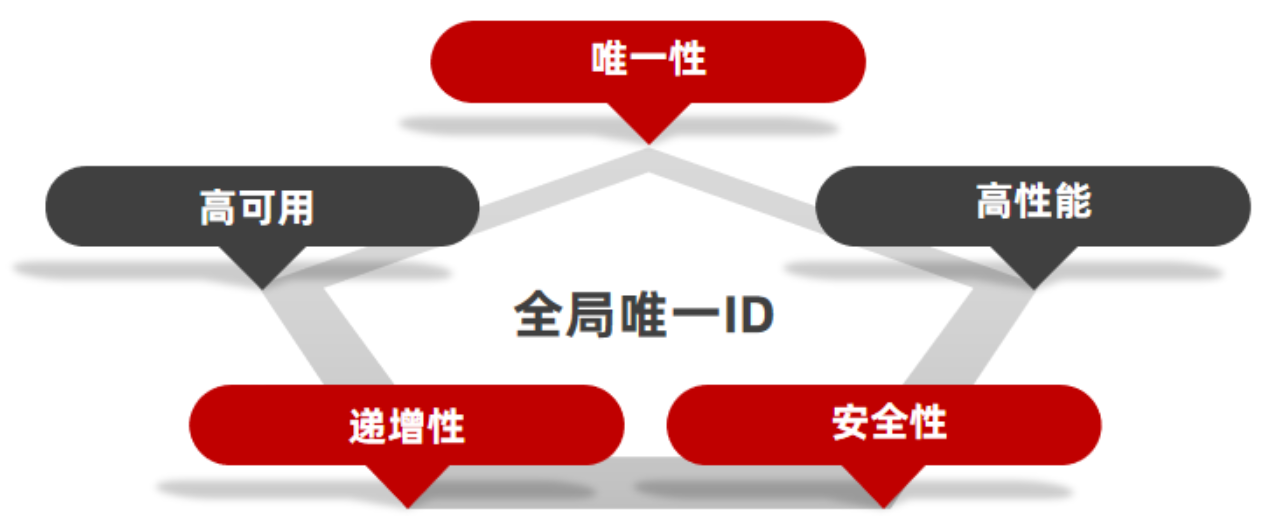

全局ID生成器,是一种在分布式系统下用来生成全局唯一ID的工具,一般要满足下列特性:

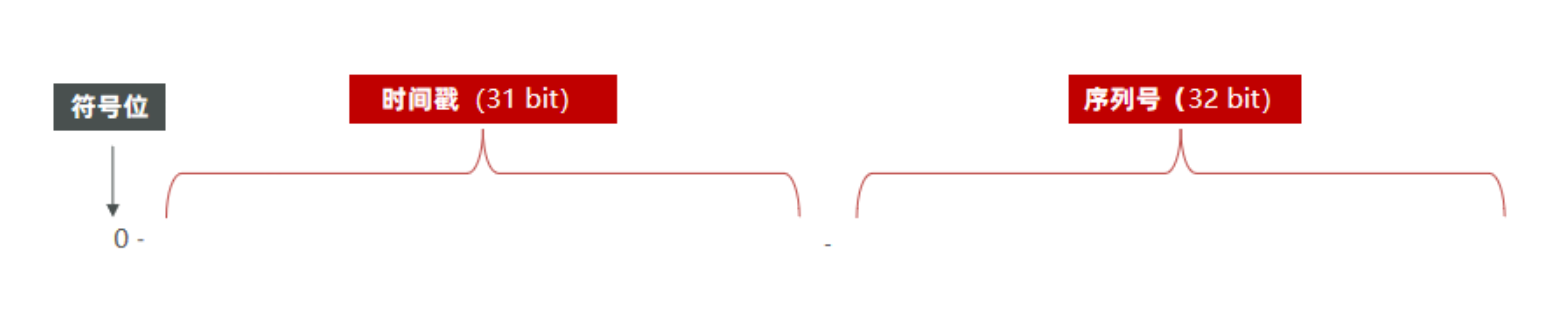

为了增加ID的安全性,我们可以不直接使用Redis自增的数值,而是拼接一些其它信息:

ID的组成部分:符号位:1bit,永远为0。 时间戳:31bit,以秒为单位,可以使用69年。 序列号:32bit,秒内的计数器,支持每秒产生2^32个不同ID。

ID的组成部分:符号位:1bit,永远为0。 时间戳:31bit,以秒为单位,可以使用69年。 序列号:32bit,秒内的计数器,支持每秒产生2^32个不同ID。

@Component

public class RedisIdWorker {

/**

* 开始时间戳

*/

private static final long BEGIN_TIMESTAMP = 1640995200L;

/**

* 序列号的位数

*/

private static final int COUNT_BITS = 32;

private StringRedisTemplate stringRedisTemplate;

public RedisIdWorker(StringRedisTemplate stringRedisTemplate) {

this.stringRedisTemplate = stringRedisTemplate;

}

public long nextId(String keyPrefix) {

// 1.生成时间戳

LocalDateTime now = LocalDateTime.now();

long nowSecond = now.toEpochSecond(ZoneOffset.UTC);

long timestamp = nowSecond - BEGIN_TIMESTAMP;

// 2.生成序列号

// 2.1.获取当前日期,精确到天

String date = now.format(DateTimeFormatter.ofPattern("yyyy:MM:dd"));

// 2.2.自增长

long count = stringRedisTemplate.opsForValue().increment("icr:" + keyPrefix + ":" + date);

// 3.拼接并返回

return timestamp << COUNT_BITS | count;

}

}秒杀下单

秒杀下单应该思考的内容:

下单时需要判断两点:

秒杀是否开始或结束,如果尚未开始或已经结束则无法下单

库存是否充足,不足则无法下单

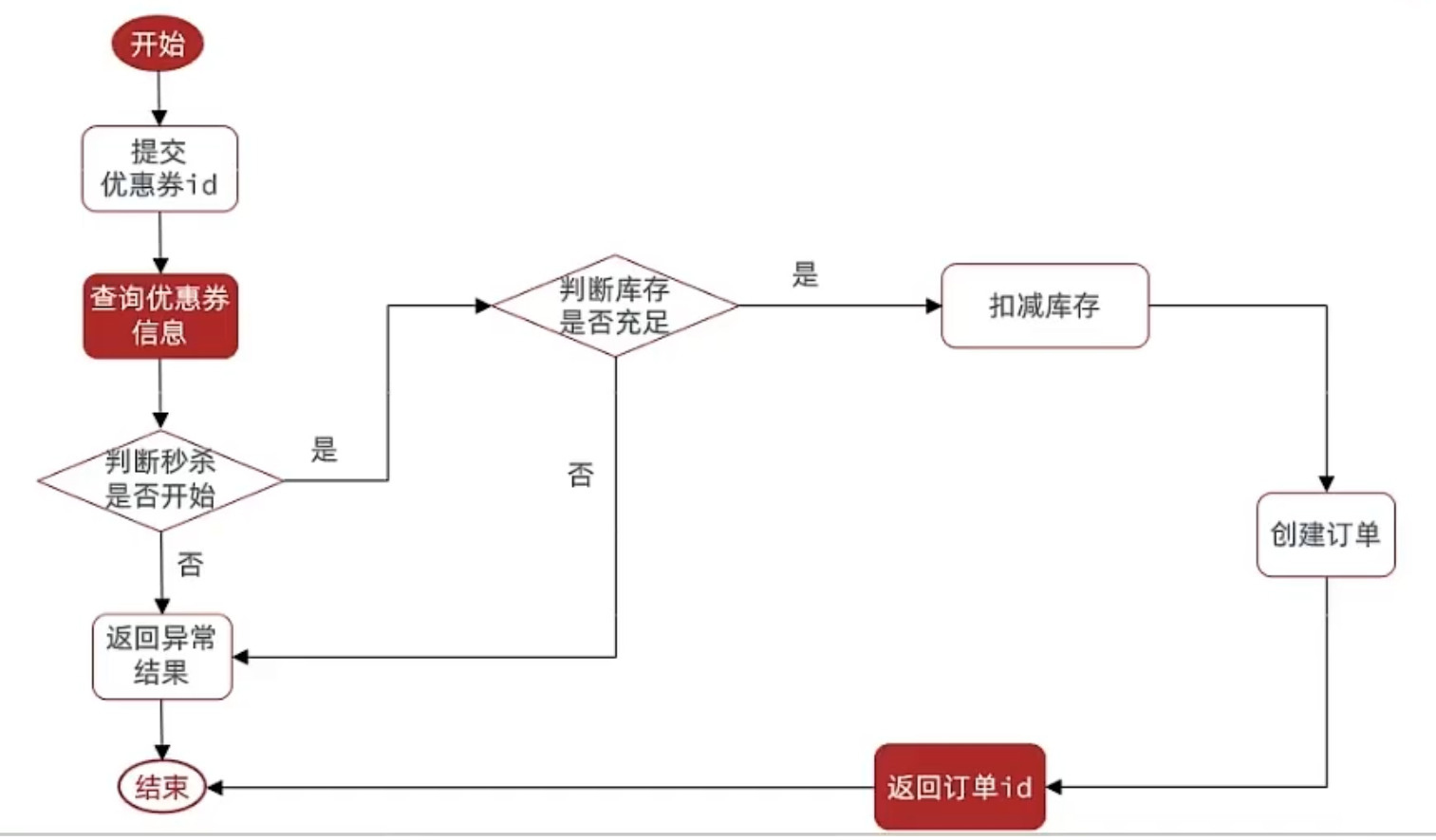

下单核心逻辑分析:

当用户开始进行下单,我们应当去查询优惠卷信息,查询到优惠卷信息,判断是否满足秒杀条件

比如时间是否充足,如果时间充足,则进一步判断库存是否足够,如果两者都满足,则扣减库存,创建订单,然后返回订单id,如果有一个条件不满足则直接结束。

实现

VoucherOrderServiceImpl

@Override

public Result seckillVoucher(Long voucherId) {

// 1.查询优惠券

SeckillVoucher voucher = seckillVoucherService.getById(voucherId);

// 2.判断秒杀是否开始

if (voucher.getBeginTime().isAfter(LocalDateTime.now())) {

// 尚未开始

return Result.fail("秒杀尚未开始!");

}

// 3.判断秒杀是否已经结束

if (voucher.getEndTime().isBefore(LocalDateTime.now())) {

// 尚未开始

return Result.fail("秒杀已经结束!");

}

// 4.判断库存是否充足

if (voucher.getStock() < 1) {

// 库存不足

return Result.fail("库存不足!");

}

//5,扣减库存

boolean success = seckillVoucherService.update()

.setSql("stock= stock -1")

.eq("voucher_id", voucherId).update();

if (!success) {

//扣减库存

return Result.fail("库存不足!");

}

//6.创建订单

VoucherOrder voucherOrder = new VoucherOrder();

// 6.1.订单id

long orderId = redisIdWorker.nextId("order");

voucherOrder.setId(orderId);

// 6.2.用户id

Long userId = UserHolder.getUser().getId();

voucherOrder.setUserId(userId);

// 6.3.代金券id

voucherOrder.setVoucherId(voucherId);

save(voucherOrder);

return Result.ok(orderId);

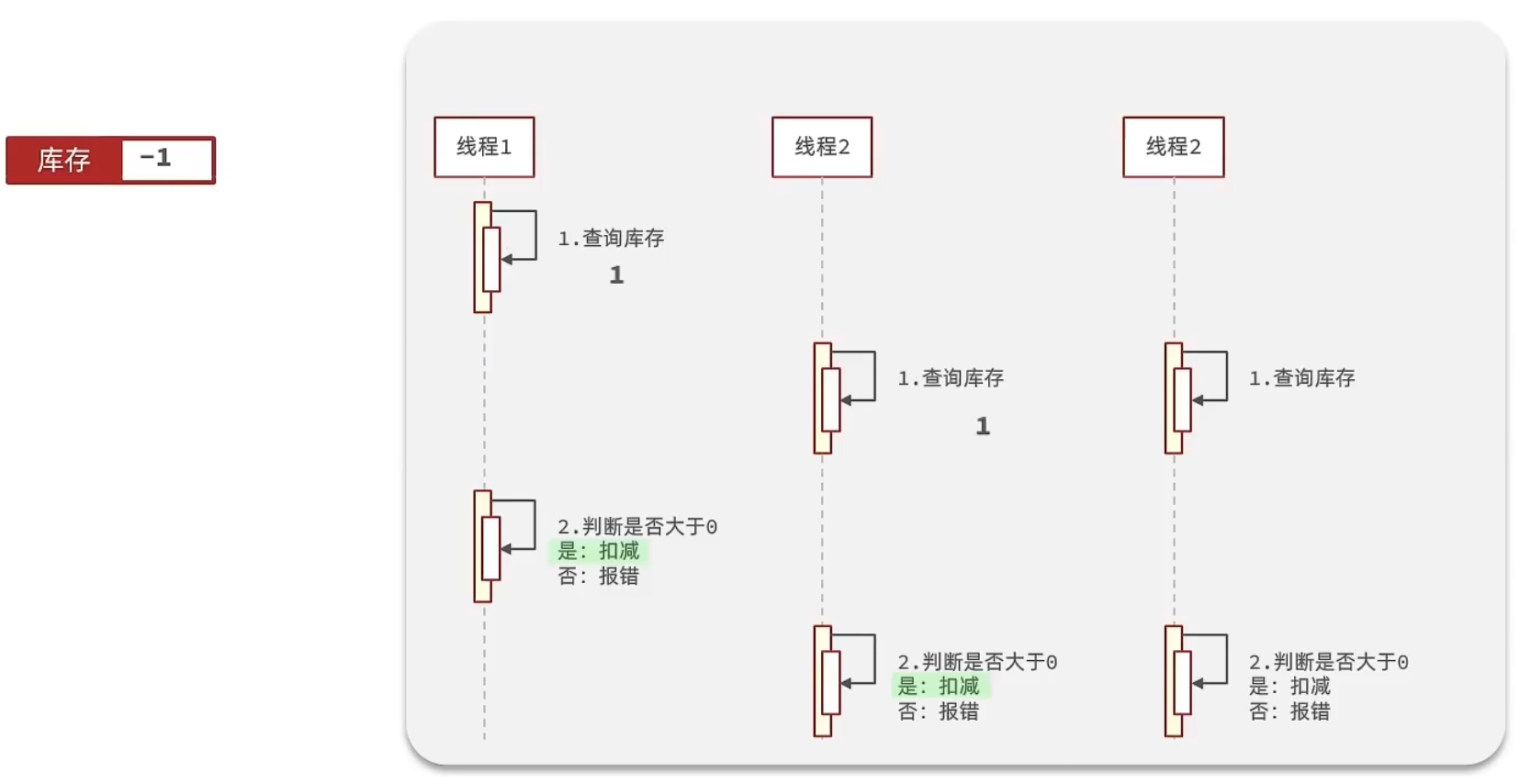

}超卖问题分析

有关超卖问题分析:在原有代码中是这么写的

if (voucher.getStock() < 1) {

// 库存不足

return Result.fail("库存不足!");

}

//5,扣减库存

boolean success = seckillVoucherService.update()

.setSql("stock= stock -1")

.eq("voucher_id", voucherId).update();

if (!success) {

//扣减库存

return Result.fail("库存不足!");

}假设线程1过来查询库存,判断出来库存大于1,正准备去扣减库存,但是还没有来得及去扣减,此时线程2过来,线程2也去查询库存,发现这个数量一定也大于1,那么这两个线程都会去扣减库存,最终多个线程相当于一起去扣减库存,此时就会出现库存的超卖问题。

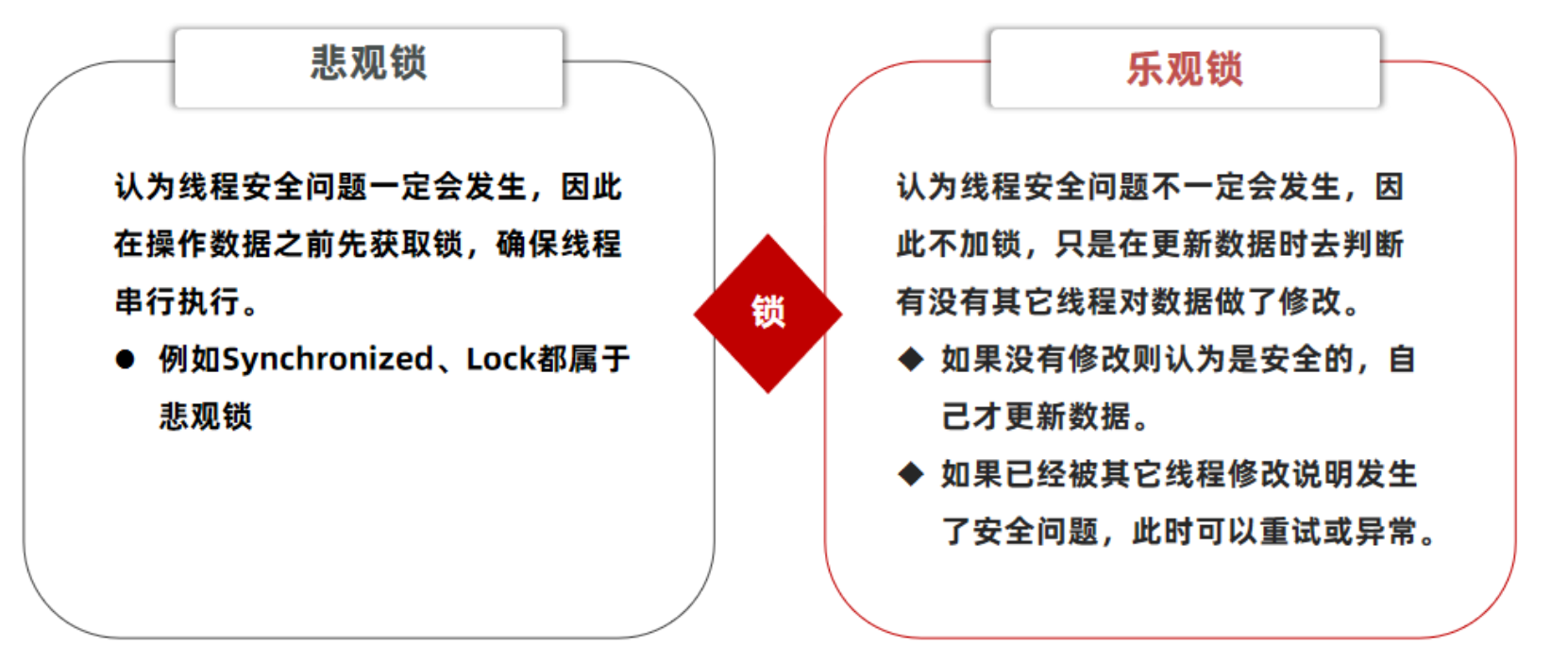

超卖问题是典型的多线程安全问题,针对这一问题的常见解决方案就是加锁:而对于加锁,我们通常有两种解决方案:见下图:

悲观锁:

悲观锁可以实现对于数据的串行化执行,比如syn,和lock都是悲观锁的代表,同时,悲观锁中又可以再细分为公平锁,非公平锁,可重入锁,等等

乐观锁:

乐观锁:会有一个版本号,每次操作数据会对版本号+1,再提交回数据时,会去校验是否比之前的版本大1 ,如果大1 ,则进行操作成功,这套机制的核心逻辑在于,如果在操作过程中,版本号只比原来大1 ,那么就意味着操作过程中没有人对他进行过修改,他的操作就是安全的,如果不大1,则数据被修改过,当然乐观锁还有一些变种的处理方式比如cas

乐观锁的典型代表:就是cas,利用cas进行无锁化机制加锁,var5 是操作前读取的内存值,while中的var1+var2 是预估值,如果预估值 == 内存值,则代表中间没有被人修改过,此时就将新值去替换 内存值

其中do while 是为了在操作失败时,再次进行自旋操作,即把之前的逻辑再操作一次。

int var5;

do {

var5 = this.getIntVolatile(var1, var2);

} while(!this.compareAndSwapInt(var1, var2, var5, var5 + var4));

return var5;乐观锁解决超卖

修改代码方案一、

VoucherOrderServiceImpl 在扣减库存时,改为:

boolean success = seckillVoucherService.update()

.setSql("stock= stock -1") //set stock = stock -1

.eq("voucher_id", voucherId).eq("stock",voucher.getStock()).update(); //where id = ? and stock = ?以上逻辑的核心含义是:只要我扣减库存时的库存和之前我查询到的库存是一样的,就意味着没有人在中间修改过库存,那么此时就是安全的,但是以上这种方式通过测试发现会有很多失败的情况,失败的原因在于:在使用乐观锁过程中假设100个线程同时都拿到了100的库存,然后大家一起去进行扣减,但是100个人中只有1个人能扣减成功,其他的人在处理时,他们在扣减时,库存已经被修改过了,所以此时其他线程都会失败

修改代码方案二、

之前的方式要修改前后都保持一致,但是这样我们分析过,成功的概率太低,所以我们的乐观锁需要变一下,改成stock大于0 即可

boolean success = seckillVoucherService.update()

.setSql("stock= stock -1")

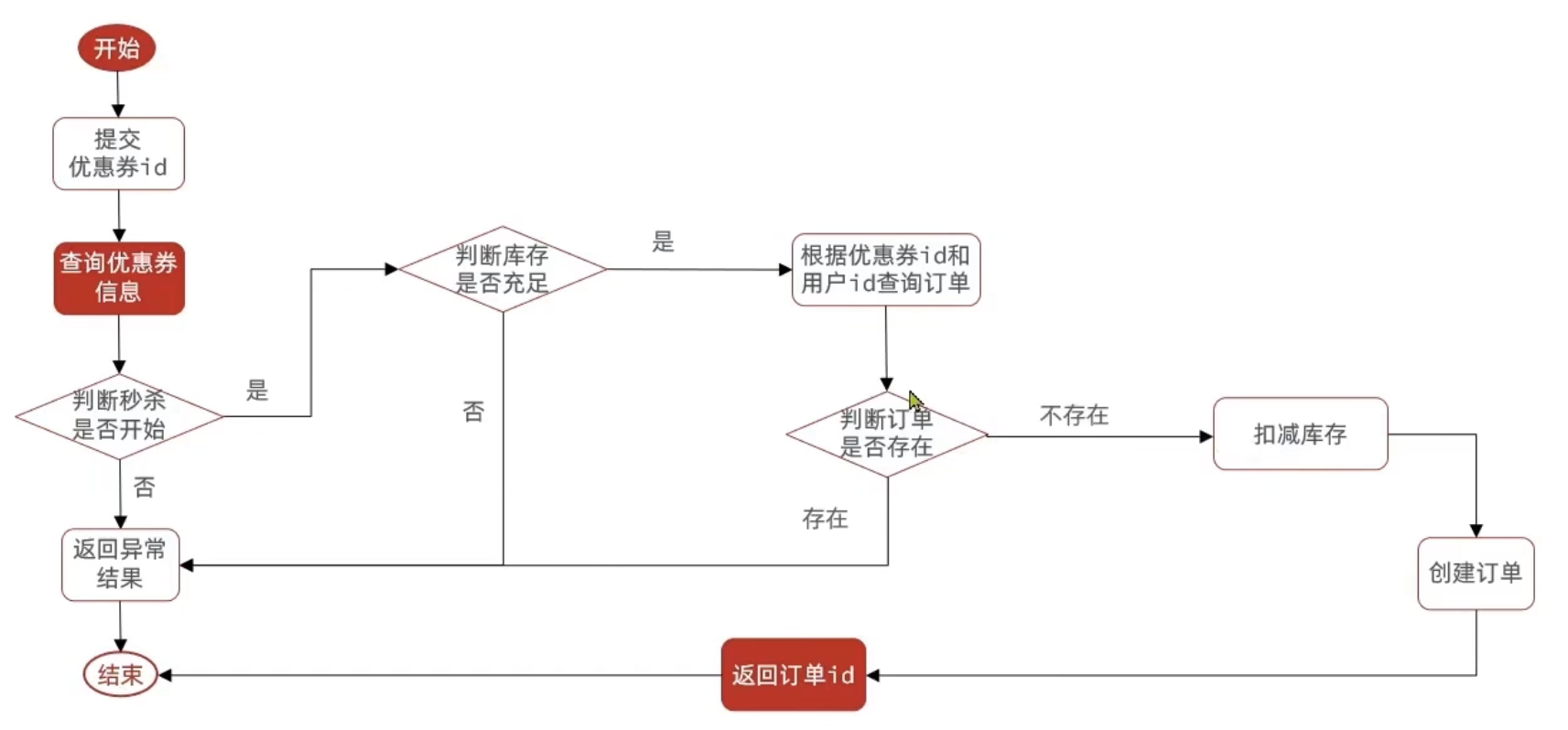

.eq("voucher_id", voucherId).update().gt("stock",0); //where id = ? and stock > 0一人一单

需求:修改秒杀业务,要求同一个优惠券,一个用户只能下一单

现在的问题在于:

优惠卷是为了引流,但是目前的情况是,一个人可以无限制的抢这个优惠卷,所以我们应当增加一层逻辑,让一个用户只能下一个单,而不是让一个用户下多个单

具体操作逻辑如下:比如时间是否充足,如果时间充足,则进一步判断库存是否足够,然后再根据优惠卷id和用户id查询是否已经下过这个订单,如果下过这个订单,则不再下单,否则进行下单。

初步代码:增加一人一单逻辑

@Override

public Result seckillVoucher(Long voucherId) {

// 1.查询优惠券

SeckillVoucher voucher = seckillVoucherService.getById(voucherId);

// 2.判断秒杀是否开始

if (voucher.getBeginTime().isAfter(LocalDateTime.now())) {

// 尚未开始

return Result.fail("秒杀尚未开始!");

}

// 3.判断秒杀是否已经结束

if (voucher.getEndTime().isBefore(LocalDateTime.now())) {

// 尚未开始

return Result.fail("秒杀已经结束!");

}

// 4.判断库存是否充足

if (voucher.getStock() < 1) {

// 库存不足

return Result.fail("库存不足!");

}

// 5.一人一单逻辑

// 5.1.用户id

Long userId = UserHolder.getUser().getId();

int count = query().eq("user_id", userId).eq("voucher_id", voucherId).count();

// 5.2.判断是否存在

if (count > 0) {

// 用户已经购买过了

return Result.fail("用户已经购买过一次!");

}

//6,扣减库存

boolean success = seckillVoucherService.update()

.setSql("stock= stock -1")

.eq("voucher_id", voucherId).update();

if (!success) {

//扣减库存

return Result.fail("库存不足!");

}

//7.创建订单

VoucherOrder voucherOrder = new VoucherOrder();

// 7.1.订单id

long orderId = redisIdWorker.nextId("order");

voucherOrder.setId(orderId);

voucherOrder.setUserId(userId);

// 7.3.代金券id

voucherOrder.setVoucherId(voucherId);

save(voucherOrder);

return Result.ok(orderId);

}存在问题: 现在的问题还是和之前一样,并发过来,查询数据库,都不存在订单,所以我们还是需要加锁,但是操作。

注意: 在这里提到了非常多的问题,我们需要慢慢的来思考,首先我们的初始方案是封装了一个createVoucherOrder方法,同时为了确保他线程安全,在方法上添加了一把synchronized 锁

@Transactional

public synchronized Result createVoucherOrder(Long voucherId) {

Long userId = UserHolder.getUser().getId();

// 5.1.查询订单

int count = query().eq("user_id", userId).eq("voucher_id", voucherId).count();

// 5.2.判断是否存在

if (count > 0) {

// 用户已经购买过了

return Result.fail("用户已经购买过一次!");

}

// 6.扣减库存

boolean success = seckillVoucherService.update()

.setSql("stock = stock - 1") // set stock = stock - 1

.eq("voucher_id", voucherId).gt("stock", 0) // where id = ? and stock > 0

.update();

if (!success) {

// 扣减失败

return Result.fail("库存不足!");

}

// 7.创建订单

VoucherOrder voucherOrder = new VoucherOrder();

// 7.1.订单id

long orderId = redisIdWorker.nextId("order");

voucherOrder.setId(orderId);

// 7.2.用户id

voucherOrder.setUserId(userId);

// 7.3.代金券id

voucherOrder.setVoucherId(voucherId);

save(voucherOrder);

// 7.返回订单id

return Result.ok(orderId);

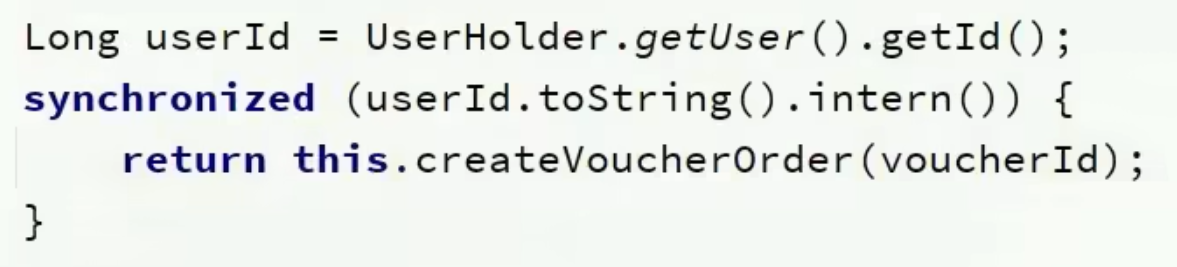

}但是这样添加锁,锁的粒度太粗了,在使用锁过程中,控制锁粒度 是一个非常重要的事情,因为如果锁的粒度太大,会导致每个线程进来都会锁住,所以我们需要去控制锁的粒度,以下这段代码需要修改为: intern() 这个方法是从常量池中拿到数据,如果我们直接使用userId.toString() 他拿到的对象实际上是不同的对象,new出来的对象,我们使用锁必须保证锁必须是同一把,所以我们需要使用intern()方法。

@Transactional

public Result createVoucherOrder(Long voucherId) {

Long userId = UserHolder.getUser().getId();

synchronized(userId.toString().intern()){

// 5.1.查询订单

int count = query().eq("user_id", userId).eq("voucher_id", voucherId).count();

// 5.2.判断是否存在

if (count > 0) {

// 用户已经购买过了

return Result.fail("用户已经购买过一次!");

}

// 6.扣减库存

boolean success = seckillVoucherService.update()

.setSql("stock = stock - 1") // set stock = stock - 1

.eq("voucher_id", voucherId).gt("stock", 0) // where id = ? and stock > 0

.update();

if (!success) {

// 扣减失败

return Result.fail("库存不足!");

}

// 7.创建订单

VoucherOrder voucherOrder = new VoucherOrder();

// 7.1.订单id

long orderId = redisIdWorker.nextId("order");

voucherOrder.setId(orderId);

// 7.2.用户id

voucherOrder.setUserId(userId);

// 7.3.代金券id

voucherOrder.setVoucherId(voucherId);

save(voucherOrder);

// 7.返回订单id

return Result.ok(orderId);

}

}但是以上代码还是存在问题,问题的原因在于当前方法被spring的事务控制,如果你在方法内部加锁,可能会导致当前方法事务还没有提交,但是锁已经释放也会导致问题,所以我们选择将当前方法整体包裹起来,确保事务不会出现问题:如下:

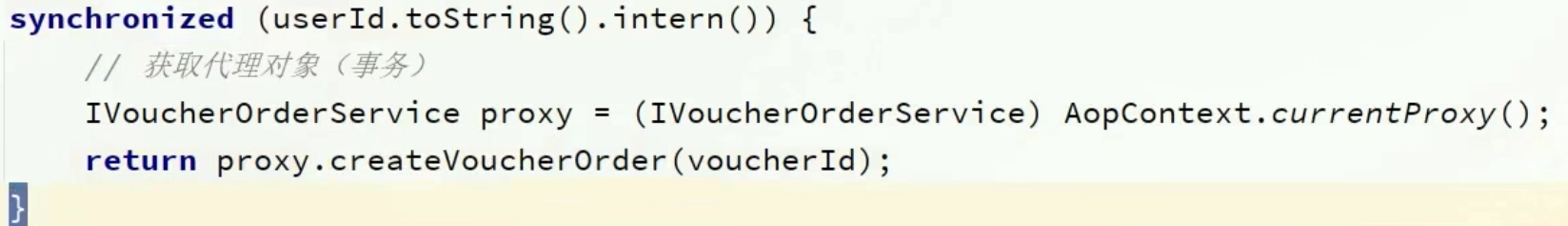

在seckillVoucher 方法中,添加以下逻辑,这样就能保证事务的特性,同时也控制了锁的粒度。

但是以上做法依然有问题,因为你调用的方法,其实是this.的方式调用的,事务想要生效,还得利用代理来生效,所以这个地方,我们需要获得原始的事务对象, 来操作事务。

(PS:汗流浃背了。。。)

集群环境下的并发问题

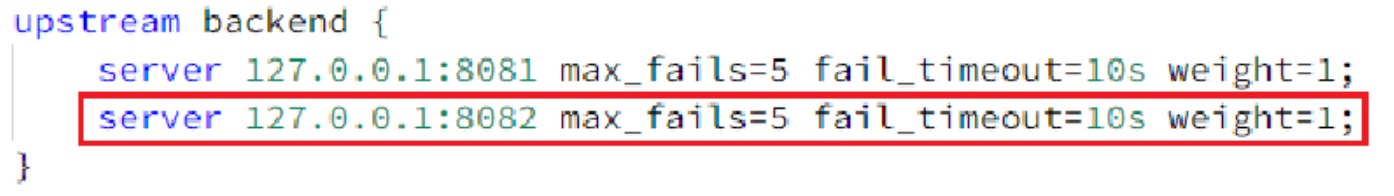

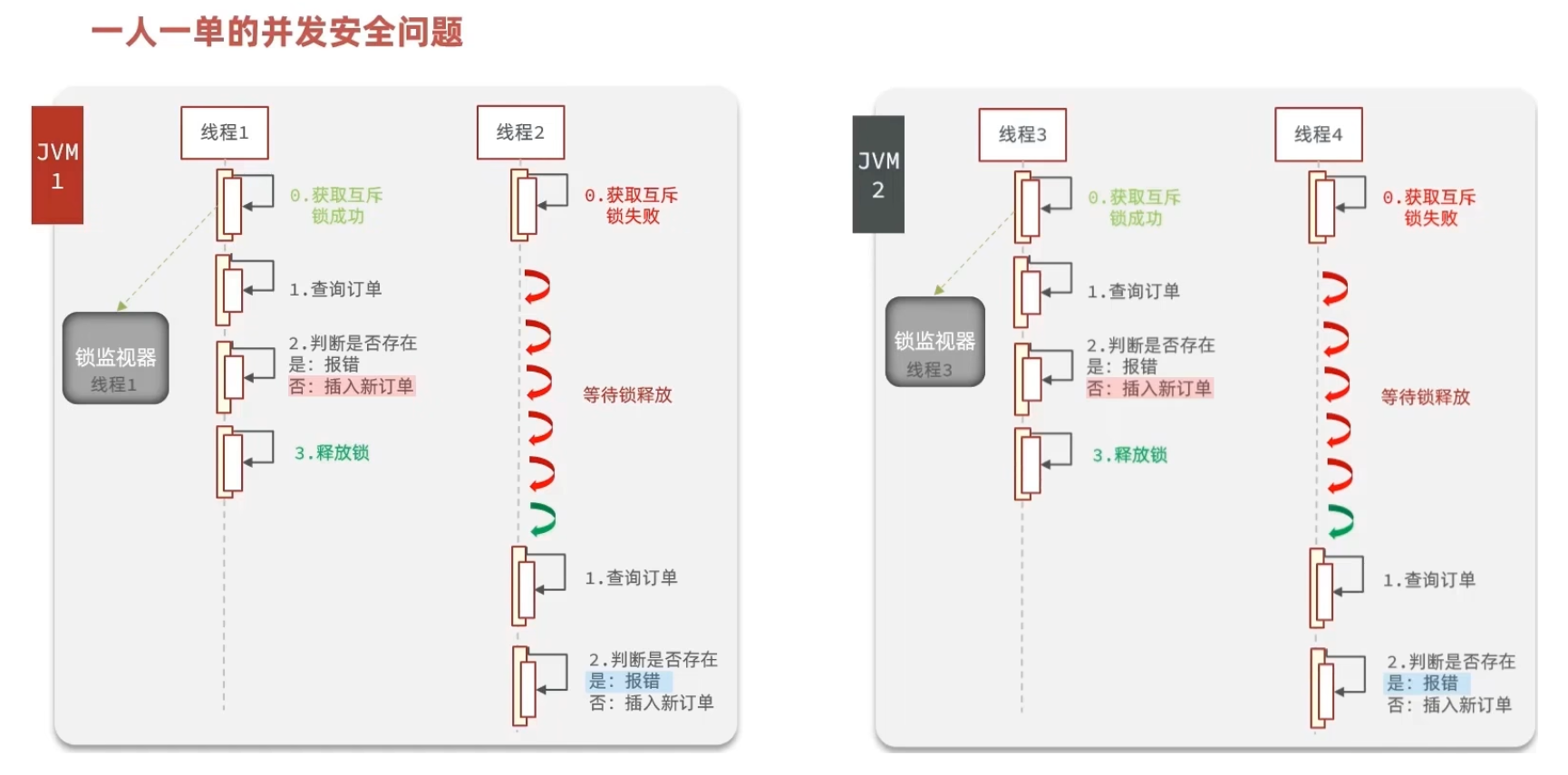

通过加锁可以解决在单机情况下的一人一单安全问题,但是在集群模式下就不行了。

1、我们将服务启动两份,端口分别为8081和8082

2、然后修改nginx的conf目录下的nginx.conf文件,配置反向代理和负载均衡

具体操作(略)

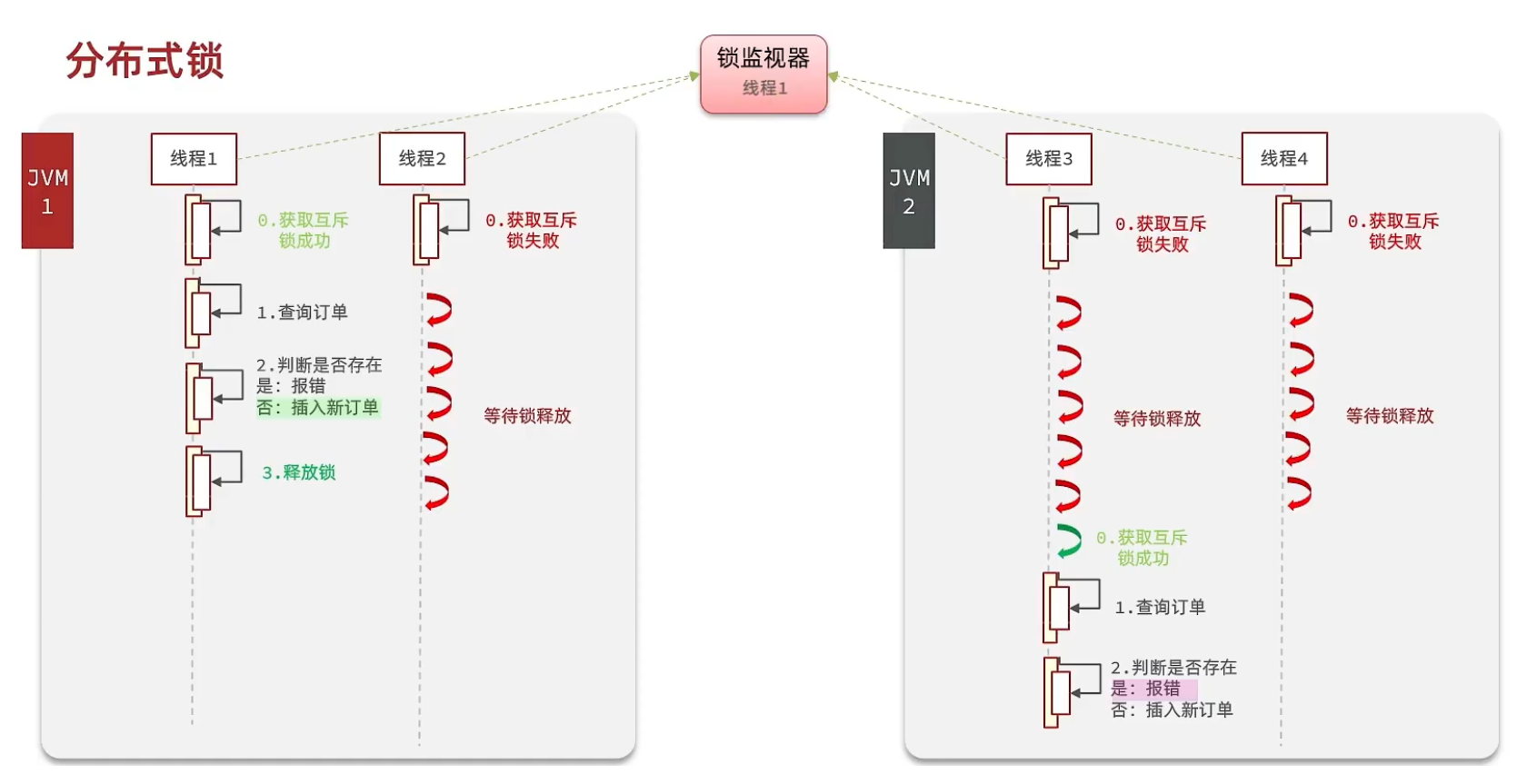

有关锁失效原因分析

由于现在我们部署了多个tomcat,每个tomcat都有一个属于自己的jvm,那么假设在服务器A的tomcat内部,有两个线程,这两个线程由于使用的是同一份代码,那么他们的锁对象是同一个,是可以实现互斥的,但是如果现在是服务器B的tomcat内部,又有两个线程,但是他们的锁对象写的虽然和服务器A一样,但是锁对象却不是同一个,所以线程3和线程4可以实现互斥,但是却无法和线程1和线程2实现互斥,这就是 集群环境下,syn锁失效的原因,在这种情况下,我们就需要使用分布式锁来解决这个问题。

分布式锁

基本原理和实现方式对比

分布式锁:满足分布式系统或集群模式下多进程可见并且互斥的锁。

分布式锁的核心思想就是让大家都使用同一把锁,只要大家使用的是同一把锁,那么我们就能锁住线程,不让线程进行,让程序串行执行,这就是分布式锁的核心思路。

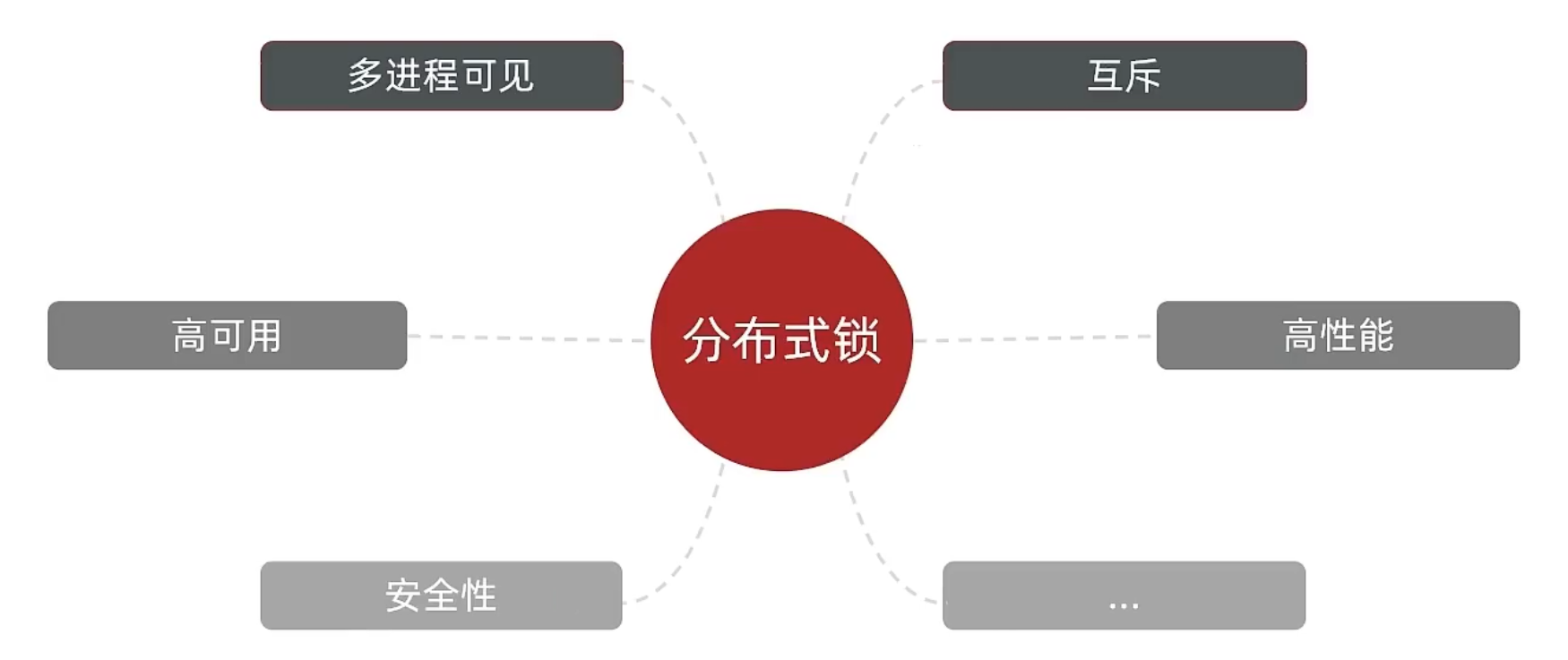

那么分布式锁他应该满足一些什么样的条件呢?

可见性:多个线程都能看到相同的结果,注意:这个地方说的可见性并不是并发编程中指的内存可见性,只是说多个进程之间都能感知到变化的意思

互斥:互斥是分布式锁的最基本的条件,使得程序串行执行

高可用:程序不易崩溃,时时刻刻都保证较高的可用性

高性能:由于加锁本身就让性能降低,所有对于分布式锁本身需要他就较高的加锁性能和释放锁性能

安全性:安全也是程序中必不可少的一环

常见的分布式锁有三种

Mysql:mysql本身就带有锁机制,但是由于mysql性能本身一般,所以采用分布式锁的情况下,其实使用mysql作为分布式锁比较少见

Redis:redis作为分布式锁是非常常见的一种使用方式,现在企业级开发中基本都使用redis或者zookeeper作为分布式锁,利用setnx这个方法,如果插入key成功,则表示获得到了锁,如果有人插入成功,其他人插入失败则表示无法获得到锁,利用这套逻辑来实现分布式锁

Zookeeper:zookeeper也是企业级开发中较好的一个实现分布式锁的方案,由于本套视频并不讲解zookeeper的原理和分布式锁的实现,所以不过多阐述

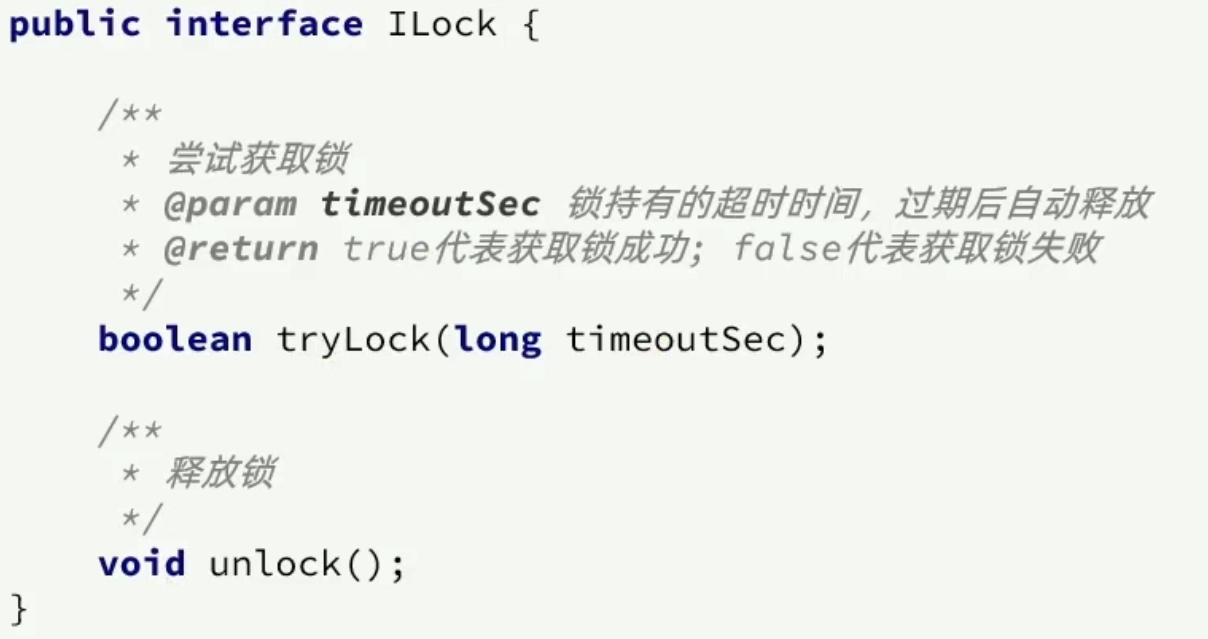

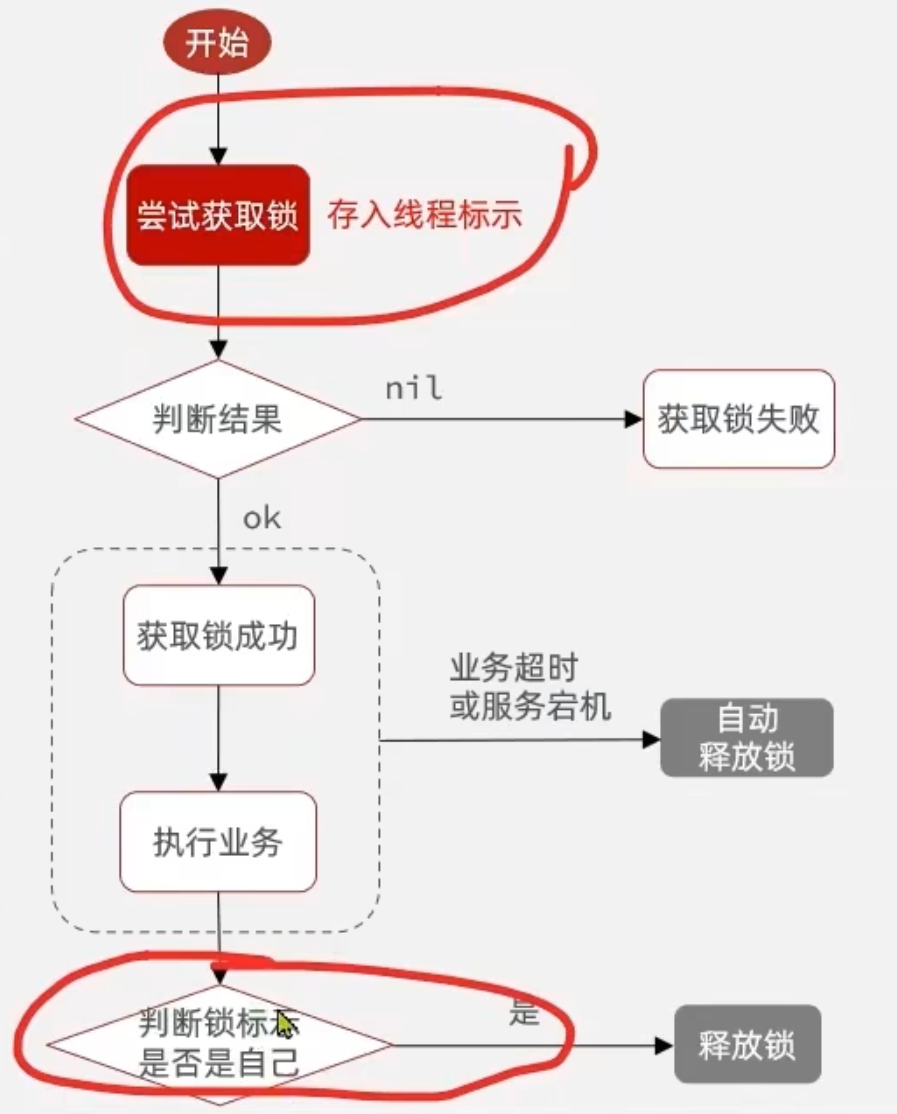

Redis分布式锁核心

实现分布式锁时需要实现的两个基本方法:

获取锁:

互斥:确保只能有一个线程获取锁

非阻塞:尝试一次,成功返回true,失败返回false

释放锁:

手动释放

超时释放:获取锁时添加一个超时时间

核心思路:

我们利用redis 的setNx 方法,当有多个线程进入时,我们就利用该方法,第一个线程进入时,redis 中就有这个key 了,返回了1,如果结果是1,则表示他抢到了锁,那么他去执行业务,然后再删除锁,退出锁逻辑,没有抢到锁的哥们,等待一定时间后重试即可。

实现分布式锁

锁的基本接口

SimpleRedisLock

利用setnx方法进行加锁,同时增加过期时间,防止死锁,此方法可以保证加锁和增加过期时间具有原子性

private static final String KEY_PREFIX="lock:"

@Override

public boolean tryLock(long timeoutSec) {

// 获取线程标示

String threadId = Thread.currentThread().getId()

// 获取锁

Boolean success = stringRedisTemplate.opsForValue()

.setIfAbsent(KEY_PREFIX + name, threadId + "", timeoutSec, TimeUnit.SECONDS);

return Boolean.TRUE.equals(success);

}释放锁逻辑

SimpleRedisLock

释放锁,防止删除别人的锁

public void unlock() {

//通过del删除锁

stringRedisTemplate.delete(KEY_PREFIX + name);

}修改业务代码

@Override

public Result seckillVoucher(Long voucherId) {

// 1.查询优惠券

SeckillVoucher voucher = seckillVoucherService.getById(voucherId);

// 2.判断秒杀是否开始

if (voucher.getBeginTime().isAfter(LocalDateTime.now())) {

// 尚未开始

return Result.fail("秒杀尚未开始!");

}

// 3.判断秒杀是否已经结束

if (voucher.getEndTime().isBefore(LocalDateTime.now())) {

// 尚未开始

return Result.fail("秒杀已经结束!");

}

// 4.判断库存是否充足

if (voucher.getStock() < 1) {

// 库存不足

return Result.fail("库存不足!");

}

Long userId = UserHolder.getUser().getId();

//创建锁对象(新增代码)

SimpleRedisLock lock = new SimpleRedisLock("order:" + userId, stringRedisTemplate);

//获取锁对象

boolean isLock = lock.tryLock(1200);

//加锁失败

if (!isLock) {

return Result.fail("不允许重复下单");

}

try {

//获取代理对象(事务)

IVoucherOrderService proxy = (IVoucherOrderService) AopContext.currentProxy();

return proxy.createVoucherOrder(voucherId);

} finally {

//释放锁

lock.unlock();

}

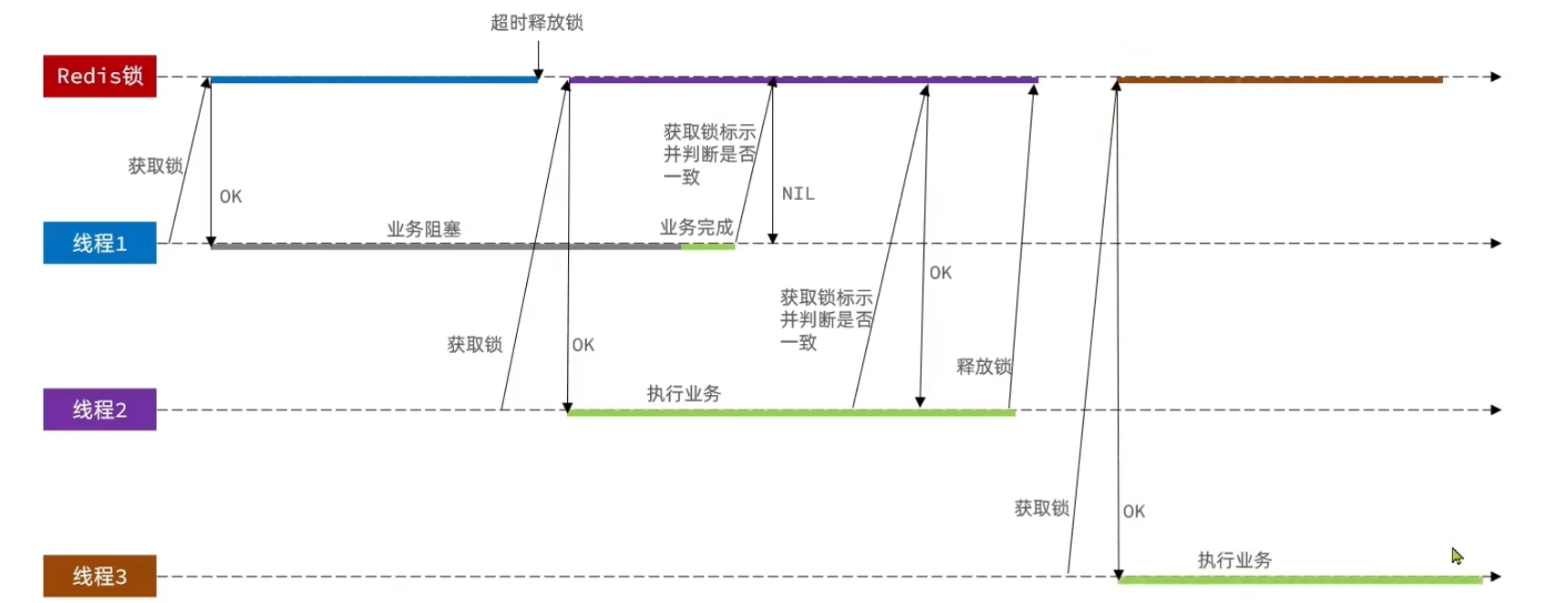

}锁误删

逻辑说明:

持有锁的线程在锁的内部出现了阻塞,导致他的锁自动释放,这时其他线程,线程2来尝试获得锁,就拿到了这把锁,然后线程2在持有锁执行过程中,线程1反应过来,继续执行,而线程1执行过程中,走到了删除锁逻辑,此时就会把本应该属于线程2的锁进行删除,这就是误删别人锁的情况说明

解决方案:解决方案就是在每个线程释放锁的时候,去判断一下当前这把锁是否属于自己,如果属于自己,则不进行锁的删除,假设还是上边的情况,线程1卡顿,锁自动释放,线程2进入到锁的内部执行逻辑,此时线程1反应过来,然后删除锁,但是线程1,一看当前这把锁不是属于自己,于是不进行删除锁逻辑,当线程2走到删除锁逻辑时,如果没有卡过自动释放锁的时间点,则判断当前这把锁是属于自己的,于是删除这把锁。

锁误删解决思路

需求:修改之前的分布式锁实现,满足:在获取锁时存入线程标示(可以用UUID表示) 在释放锁时先获取锁中的线程标示,判断是否与当前线程标示一致

如果一致则释放锁

如果不一致则不释放锁

核心逻辑:在存入锁时,放入自己线程的标识,在删除锁时,判断当前这把锁的标识是不是自己存入的,如果是,则进行删除,如果不是,则不进行删除。

具体代码如下:加锁

private static final String ID_PREFIX = UUID.randomUUID().toString(true) + "-";

@Override

public boolean tryLock(long timeoutSec) {

// 获取线程标示

String threadId = ID_PREFIX + Thread.currentThread().getId();

// 获取锁

Boolean success = stringRedisTemplate.opsForValue()

.setIfAbsent(KEY_PREFIX + name, threadId, timeoutSec, TimeUnit.SECONDS);

return Boolean.TRUE.equals(success);

}释放锁

public void unlock() {

// 获取线程标示

String threadId = ID_PREFIX + Thread.currentThread().getId();

// 获取锁中的标示

String id = stringRedisTemplate.opsForValue().get(KEY_PREFIX + name);

// 判断标示是否一致

if(threadId.equals(id)) {

// 释放锁

stringRedisTemplate.delete(KEY_PREFIX + name);

}

}分布式锁的原子性

更为极端的误删逻辑说明:

线程1现在持有锁之后,在执行业务逻辑过程中,他正准备删除锁,而且已经走到了条件判断的过程中,比如他已经拿到了当前这把锁确实是属于他自己的,正准备删除锁,但是此时他的锁到期了,那么此时线程2进来,但是线程1他会接着往后执行,当他卡顿结束后,他直接就会执行删除锁那行代码,相当于条件判断并没有起到作用,这就是删锁时的原子性问题,之所以有这个问题,是因为线程1的拿锁,比锁,删锁,实际上并不是原子性的。

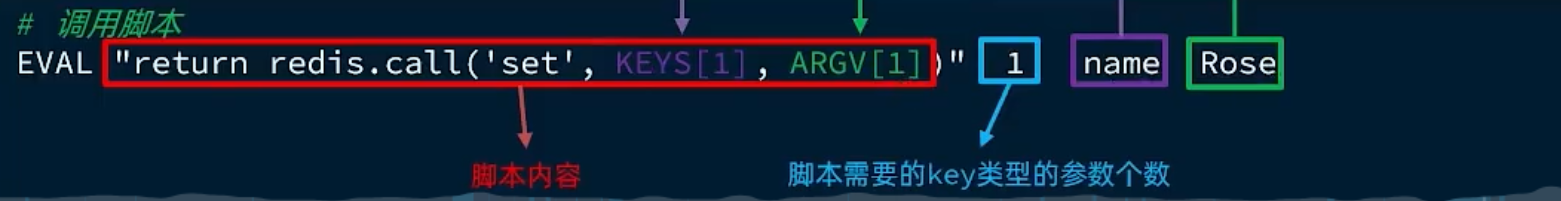

Redis提供了Lua脚本功能,在一个脚本中编写多条Redis命令,确保多条命令执行时的原子性。Lua是一种编程语言,它的基本语法大家可以参考网站:https://www.runoob.com/lua/lua-tutorial.html,这里重点介绍Redis提供的调用函数,我们可以使用lua去操作redis,又能保证他的原子性,这样就可以实现拿锁比锁删锁是一个原子性动作了。

这里重点介绍Redis提供的调用函数,语法如下:

redis.call('命令名称', 'key', '其它参数', ...)例如,要执行set name jack,则脚本是这样:

## 执行 set name jack

redis.call('set', 'name', 'jack')例如,要先执行set name Rose,再执行get name,则脚本如下:

## 先执行 set name jack

redis.call('set', 'name', 'Rose')

## 再执行 get name

local name = redis.call('get', 'name')

## 返回

return name如果脚本中的key、value不想写死,可以作为参数传递。key类型参数会放入KEYS数组,其它参数会放入ARGV数组,在脚本中可以从KEYS和ARGV数组获取这些参数:

接下来我们来回一下我们释放锁的逻辑:

释放锁的业务流程是这样的

1、获取锁中的线程标示

2、判断是否与指定的标示(当前线程标示)一致

3、如果一致则释放锁(删除)

4、如果不一致则什么都不做

如果用Lua脚本来表示则是这样的:

-- 这里的 KEYS[1] 就是锁的key,这里的ARGV[1] 就是当前线程标示

-- 获取锁中的标示,判断是否与当前线程标示一致

if (redis.call('GET', KEYS[1]) == ARGV[1]) then

-- 一致,则删除锁

return redis.call('DEL', KEYS[1])

end

-- 不一致,则直接返回

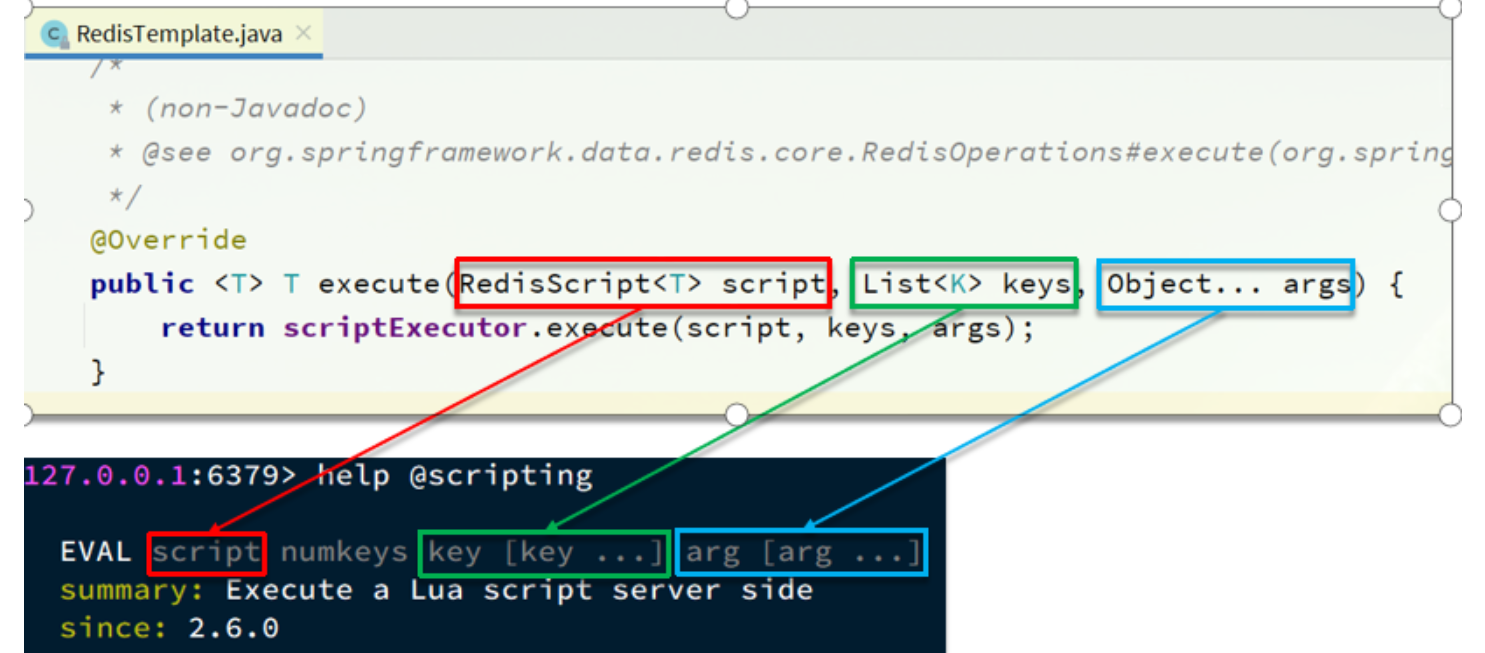

return 0利用Java代码调用Lua脚本改造分布式锁

我们的RedisTemplate中,可以利用execute方法去执行lua脚本,参数对应关系就如下图:

java代码

private static final DefaultRedisScript<Long> UNLOCK_SCRIPT;

static {

UNLOCK_SCRIPT = new DefaultRedisScript<>();

UNLOCK_SCRIPT.setLocation(new ClassPathResource("unlock.lua"));

UNLOCK_SCRIPT.setResultType(Long.class);

}

public void unlock() {

// 调用lua脚本

stringRedisTemplate.execute(

UNLOCK_SCRIPT,

Collections.singletonList(KEY_PREFIX + name),

ID_PREFIX + Thread.currentThread().getId());

}

//经过以上代码改造后,我们就能够实现 拿锁比锁删锁的原子性动作了~redission

基于setnx实现的分布式锁存在下面的问题:

重入问题:重入问题是指 获得锁的线程可以再次进入到相同的锁的代码块中,可重入锁的意义在于防止死锁,比如HashTable这样的代码中,他的方法都是使用synchronized修饰的,假如他在一个方法内,调用另一个方法,那么此时如果是不可重入的,不就死锁了吗?所以可重入锁他的主要意义是防止死锁,我们的synchronized和Lock锁都是可重入的。

不可重试:是指目前的分布式只能尝试一次,我们认为合理的情况是:当线程在获得锁失败后,他应该能再次尝试获得锁。

**超时释放:**我们在加锁时增加了过期时间,这样的我们可以防止死锁,但是如果卡顿的时间超长,虽然我们采用了lua表达式防止删锁的时候,误删别人的锁,但是毕竟没有锁住,有安全隐患

主从一致性: 如果Redis提供了主从集群,当我们向集群写数据时,主机需要异步的将数据同步给从机,而万一在同步过去之前,主机宕机了,就会出现死锁问题。

那么什么是Redission呢

Redisson是一个在Redis的基础上实现的Java驻内存数据网格(In-Memory Data Grid)。它不仅提供了一系列的分布式的Java常用对象,还提供了许多分布式服务,其中就包含了各种分布式锁的实现。

Redission提供了分布式锁的多种多样的功能

如何使用

引入依赖:

<dependency>

<groupId>org.redisson</groupId>

<artifactId>redisson</artifactId>

<version>3.13.6</version>

</dependency>配置Redisson客户端:

@Configuration

public class RedissonConfig {

@Bean

public RedissonClient redissonClient(){

// 配置

Config config = new Config();

config.useSingleServer().setAddress("redis://192.168.150.101:6379")

.setPassword("123321");

// 创建RedissonClient对象

return Redisson.create(config);

}

}如何使用Redission的分布式锁

@Resource

private RedissionClient redissonClient;

@Test

void testRedisson() throws Exception{

//获取锁(可重入),指定锁的名称

RLock lock = redissonClient.getLock("anyLock");

//尝试获取锁,参数分别是:获取锁的最大等待时间(期间会重试),锁自动释放时间,时间单位

boolean isLock = lock.tryLock(1,10,TimeUnit.SECONDS);

//判断获取锁成功

if(isLock){

try{

System.out.println("执行业务");

}finally{

//释放锁

lock.unlock();

}

}

}在 VoucherOrderServiceImpl

注入RedissonClient

@Resource

private RedissonClient redissonClient;

@Override

public Result seckillVoucher(Long voucherId) {

// 1.查询优惠券

SeckillVoucher voucher = seckillVoucherService.getById(voucherId);

// 2.判断秒杀是否开始

if (voucher.getBeginTime().isAfter(LocalDateTime.now())) {

// 尚未开始

return Result.fail("秒杀尚未开始!");

}

// 3.判断秒杀是否已经结束

if (voucher.getEndTime().isBefore(LocalDateTime.now())) {

// 尚未开始

return Result.fail("秒杀已经结束!");

}

// 4.判断库存是否充足

if (voucher.getStock() < 1) {

// 库存不足

return Result.fail("库存不足!");

}

Long userId = UserHolder.getUser().getId();

//创建锁对象 这个代码不用了,因为我们现在要使用分布式锁

//SimpleRedisLock lock = new SimpleRedisLock("order:" + userId, stringRedisTemplate);

RLock lock = redissonClient.getLock("lock:order:" + userId);

//获取锁对象

boolean isLock = lock.tryLock();

//加锁失败

if (!isLock) {

return Result.fail("不允许重复下单");

}

try {

//获取代理对象(事务)

IVoucherOrderService proxy = (IVoucherOrderService) AopContext.currentProxy();

return proxy.createVoucherOrder(voucherId);

} finally {

//释放锁

lock.unlock();

}

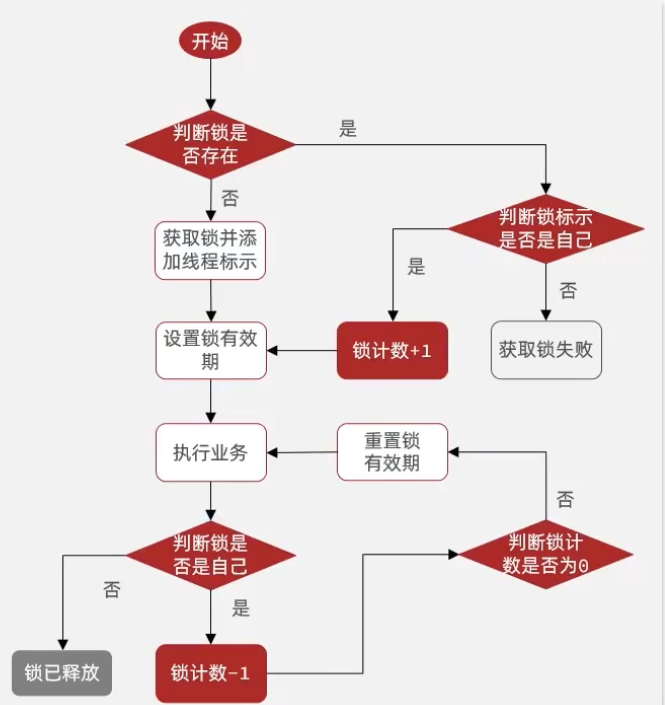

}redission可重入锁原理

在Lock锁中,他是借助于底层的一个voaltile的一个state变量来记录重入的状态的,比如当前没有人持有这把锁,那么state=0,假如有人持有这把锁,那么state=1,如果持有这把锁的人再次持有这把锁,那么state就会+1 ,如果是对于synchronized而言,他在c语言代码中会有一个count,原理和state类似,也是重入一次就加一,释放一次就-1 ,直到减少成0 时,表示当前这把锁没有被人持有。

在redission中,我们的也支持支持可重入锁

Redisson是基于hash结构实现的,记录线程id和重入次数。代替了自定义锁时用的string结构。每一次获取锁的时候先判断锁是否存在,如果不存在就直接获取,如果已经存在那么不代表获取锁失败了,这时候如果发现线程标识就是当前线程,那么就代表我可以再次获取,只用把重入次数加1。将来在释放锁的时候,每释放一次,重入次数就减一,知道重入次数减为0,证明走到最外层,所有业务都结束了,在真正的释放锁。从而实现所的可重入。这个和jdk提供的reententLock原理是基本一致的。

锁重试和WatchDog机制

Redission的锁重试机制是在Redisson是基于信号量,和PubSub发布订阅这样功能实现的。在第一次尝试获取锁失败以后,不是立即失败,而是做一个等待。等待什么呢?等待一个释放锁的消息,利用pubsub机制。而获取锁成功的线程在释放锁的时候去发布这样一个消息,从而被捕获到。当捕获到这个消息时,就可以去重新尝试获取锁了,如果再次获取又失败了,就可以继续去等待这样一个锁释放的信号,然后再次去重试,从而实现重试机制。当然这个重试也不是无限制的,会有一个等待的时间,如果超过了时间就不在等待了。因为重试机制采用了等待唤醒这种方案,所以并不会过多的占用cpu。效率还是不错的。

WatchDog机制可以延续锁时间。默认情况下,如果锁超过默认时间还没有结束,看门狗会自动续期1/3 的时间。

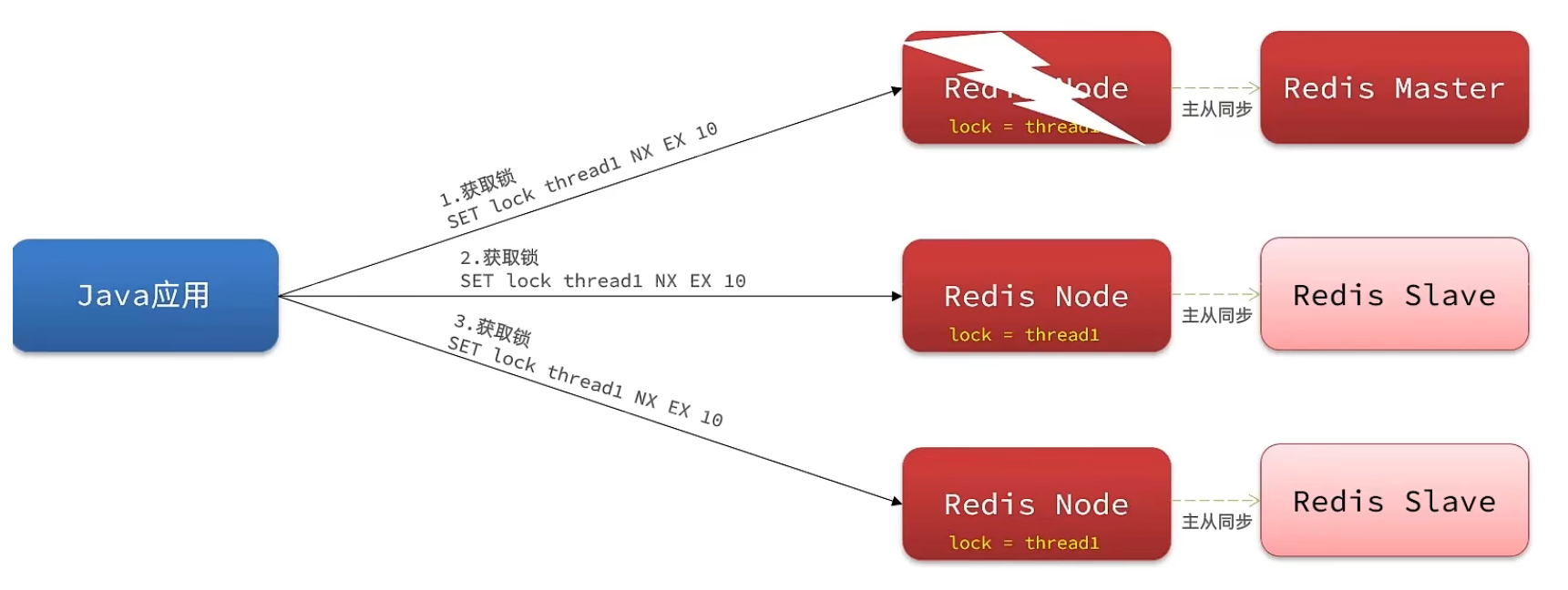

MultiLock原理

为了提高redis的可用性,我们会搭建集群或者主从,现在以主从为例

此时我们去写命令,写在主机上, 主机会将数据同步给从机,但是假设在主机还没有来得及把数据写入到从机去的时候,此时主机宕机,哨兵会发现主机宕机,并且选举一个slave变成master,而此时新的master中实际上并没有锁信息,此时锁信息就已经丢掉了。

为了解决这个问题,redission提出来了MutiLock锁,使用这把锁咱们就不使用主从了,每个节点的地位都是一样的, 这把锁加锁的逻辑需要写入到每一个主丛节点上,只有所有的服务器都写入成功,此时才是加锁成功,假设现在某个节点挂了,那么他去获得锁的时候,只要有一个节点拿不到,都不能算是加锁成功,就保证了加锁的可靠性。

MutiLock 加锁原理:

当我们去设置了多个锁时,redission会将多个锁添加到一个集合中,然后用while循环去不停去尝试拿锁,但是会有一个总共的加锁时间,这个时间是用需要加锁的个数 * 1500ms ,假设有3个锁,那么时间就是4500ms,假设在这4500ms内,所有的锁都加锁成功, 那么此时才算是加锁成功,如果在4500ms有线程加锁失败,则会再次去进行重试。

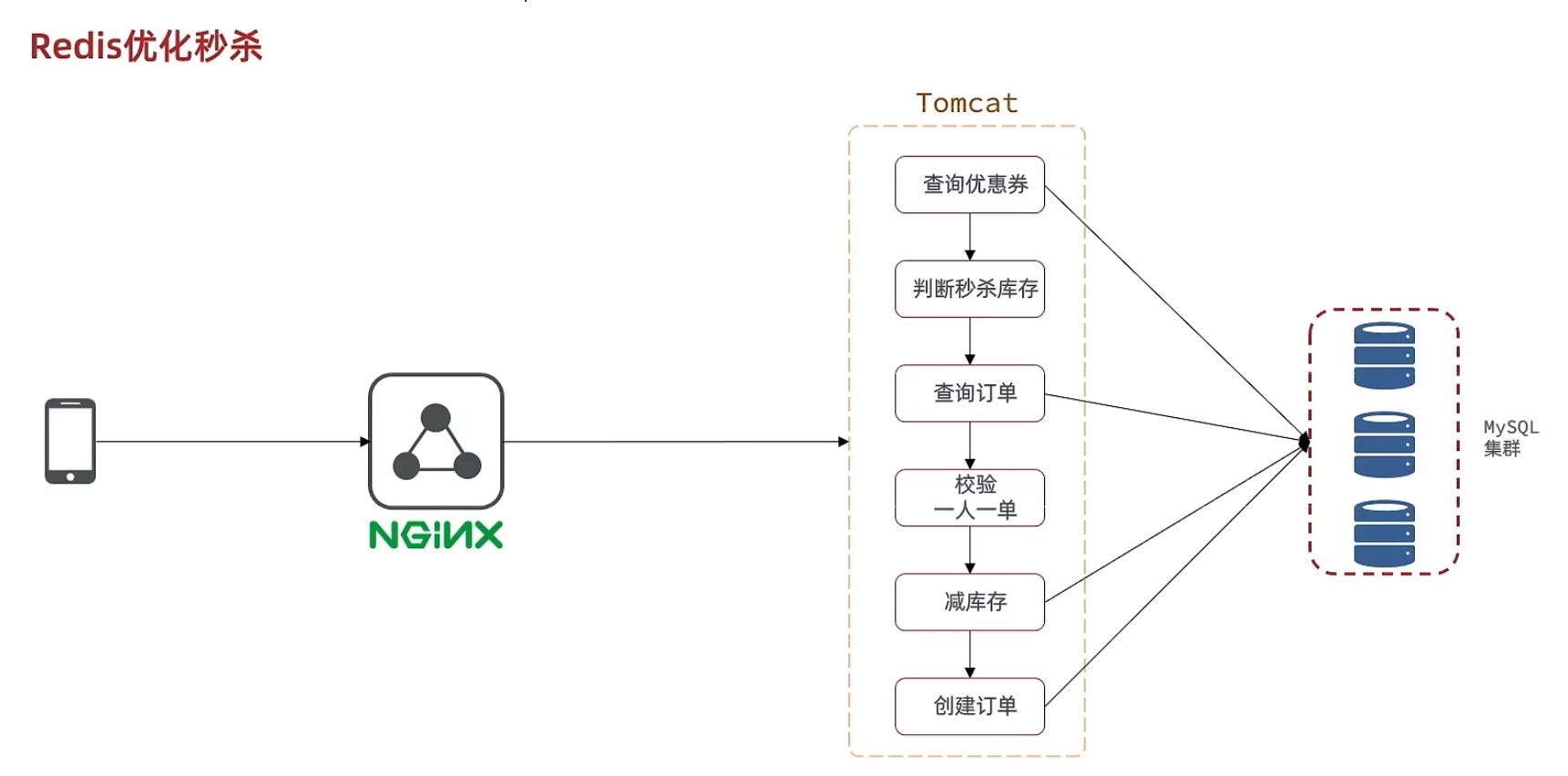

秒杀优化

思路分析

回顾一下下单流程

当用户发起请求,此时会请求nginx,nginx会访问到tomcat,而tomcat中的程序,会进行串行操作,分成如下几个步骤

1、查询优惠卷

2、判断秒杀库存是否足够

3、查询订单

4、校验是否是一人一单

5、扣减库存

6、创建订单

在这六步操作中,又有很多操作是要去操作数据库的,而且还是一个线程串行执行, 这样就会导致我们的程序执行的很慢,所以我们需要异步程序执行,那么如何加速呢?

我们现在来看看整体思路:当用户下单之后,判断库存是否充足只需要导redis中去根据key找对应的value是否大于0即可,如果不充足,则直接结束,如果充足,继续在redis中判断用户是否可以下单,如果set集合中没有这条数据,说明他可以下单,如果set集合中没有这条记录,则将userId和优惠卷存入到redis中,并且返回0,整个过程需要保证是原子性的,我们可以使用lua来操作

当以上判断逻辑走完之后,我们可以判断当前redis中返回的结果是否是0 ,如果是0,则表示可以下单,则将之前说的信息存入到到queue中去,然后返回,然后再来个线程异步的下单,前端可以通过返回的订单id来判断是否下单成功。

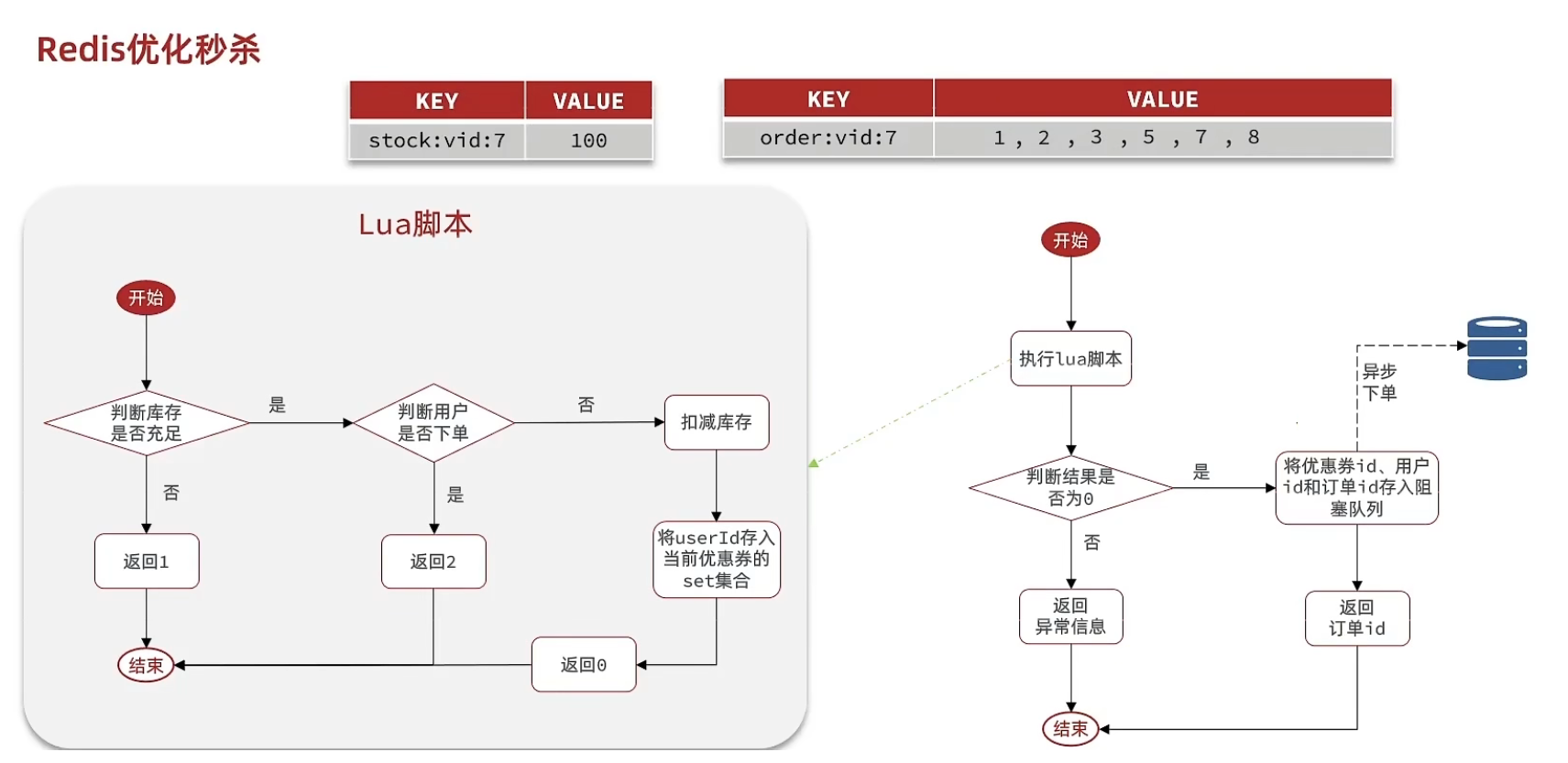

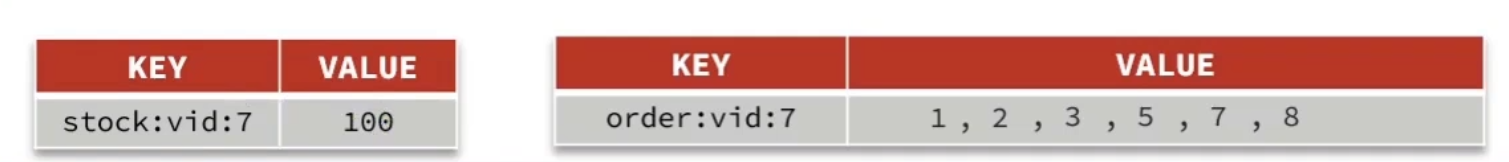

秒杀资格判断

需求:

新增秒杀优惠券的同时,将优惠券信息保存到Redis中

基于Lua脚本,判断秒杀库存、一人一单,决定用户是否抢购成功

如果抢购成功,将优惠券id和用户id封装后存入阻塞队列

开启线程任务,不断从阻塞队列中获取信息,实现异步下单功能

VoucherServiceImpl

@Override

@Transactional

public void addSeckillVoucher(Voucher voucher) {

// 保存优惠券

save(voucher);

// 保存秒杀信息

SeckillVoucher seckillVoucher = new SeckillVoucher();

seckillVoucher.setVoucherId(voucher.getId());

seckillVoucher.setStock(voucher.getStock());

seckillVoucher.setBeginTime(voucher.getBeginTime());

seckillVoucher.setEndTime(voucher.getEndTime());

seckillVoucherService.save(seckillVoucher);

// 保存秒杀库存到Redis中

//SECKILL_STOCK_KEY 这个变量定义在RedisConstans中

//private static final String SECKILL_STOCK_KEY ="seckill:stock:"

stringRedisTemplate.opsForValue().set(SECKILL_STOCK_KEY + voucher.getId(), voucher.getStock().toString());

}完整lua脚本

-- 1.参数列表

-- 1.1.优惠券id

local voucherId = ARGV[1]

-- 1.2.用户id

local userId = ARGV[2]

-- 1.3.订单id

local orderId = ARGV[3]

-- 2.数据key

-- 2.1.库存key

local stockKey = 'seckill:stock:' .. voucherId

-- 2.2.订单key

local orderKey = 'seckill:order:' .. voucherId

-- 3.脚本业务

-- 3.1.判断库存是否充足 get stockKey

if(tonumber(redis.call('get', stockKey)) <= 0) then

-- 3.2.库存不足,返回1

return 1

end

-- 3.2.判断用户是否下单 SISMEMBER orderKey userId

if(redis.call('sismember', orderKey, userId) == 1) then

-- 3.3.存在,说明是重复下单,返回2

return 2

end

-- 3.4.扣库存 incrby stockKey -1

redis.call('incrby', stockKey, -1)

-- 3.5.下单(保存用户)sadd orderKey userId

redis.call('sadd', orderKey, userId)

-- 3.6.发送消息到队列中, XADD stream.orders * k1 v1 k2 v2 ...

redis.call('xadd', 'stream.orders', '*', 'userId', userId, 'voucherId', voucherId, 'id', orderId)

return 0当以上lua表达式执行完毕后,剩下的就是根据步骤3,4来执行我们接下来的任务了

VoucherOrderServiceImpl

@Override

public Result seckillVoucher(Long voucherId) {

//获取用户

Long userId = UserHolder.getUser().getId();

long orderId = redisIdWorker.nextId("order");

// 1.执行lua脚本

Long result = stringRedisTemplate.execute(

SECKILL_SCRIPT,

Collections.emptyList(),

voucherId.toString(), userId.toString(), String.valueOf(orderId)

);

int r = result.intValue();

// 2.判断结果是否为0

if (r != 0) {

// 2.1.不为0 ,代表没有购买资格

return Result.fail(r == 1 ? "库存不足" : "不能重复下单");

}

//TODO 保存阻塞队列

// 3.返回订单id

return Result.ok(orderId);

}基于阻塞队列实现秒杀优化

VoucherOrderServiceImpl

修改下单动作,现在我们去下单时,是通过lua表达式去原子执行判断逻辑,如果判断出来不为0 ,则要么是库存不足,要么是重复下单,返回错误信息,如果是0,则把下单的逻辑保存到队列中去,然后异步执行

//异步处理线程池

private static final ExecutorService SECKILL_ORDER_EXECUTOR = Executors.newSingleThreadExecutor();

//在类初始化之后执行,因为当这个类初始化好了之后,随时都是有可能要执行的

@PostConstruct

private void init() {

SECKILL_ORDER_EXECUTOR.submit(new VoucherOrderHandler());

}

// 用于线程池处理的任务

// 当初始化完毕后,就会去从对列中去拿信息

private class VoucherOrderHandler implements Runnable{

@Override

public void run() {

while (true){

try {

// 1.获取队列中的订单信息

VoucherOrder voucherOrder = orderTasks.take();

// 2.创建订单

handleVoucherOrder(voucherOrder);

} catch (Exception e) {

log.error("处理订单异常", e);

}

}

}

private void handleVoucherOrder(VoucherOrder voucherOrder) {

//1.获取用户

Long userId = voucherOrder.getUserId();

// 2.创建锁对象

RLock redisLock = redissonClient.getLock("lock:order:" + userId);

// 3.尝试获取锁

boolean isLock = redisLock.lock();

// 4.判断是否获得锁成功

if (!isLock) {

// 获取锁失败,直接返回失败或者重试

log.error("不允许重复下单!");

return;

}

try {

//注意:由于是spring的事务是放在threadLocal中,此时的是多线程,事务会失效

proxy.createVoucherOrder(voucherOrder);

} finally {

// 释放锁

redisLock.unlock();

}

}

//a

private BlockingQueue<VoucherOrder> orderTasks =new ArrayBlockingQueue<>(1024 * 1024);

@Override

public Result seckillVoucher(Long voucherId) {

Long userId = UserHolder.getUser().getId();

long orderId = redisIdWorker.nextId("order");

// 1.执行lua脚本

Long result = stringRedisTemplate.execute(

SECKILL_SCRIPT,

Collections.emptyList(),

voucherId.toString(), userId.toString(), String.valueOf(orderId)

);

int r = result.intValue();

// 2.判断结果是否为0

if (r != 0) {

// 2.1.不为0 ,代表没有购买资格

return Result.fail(r == 1 ? "库存不足" : "不能重复下单");

}

VoucherOrder voucherOrder = new VoucherOrder();

// 2.3.订单id

long orderId = redisIdWorker.nextId("order");

voucherOrder.setId(orderId);

// 2.4.用户id

voucherOrder.setUserId(userId);

// 2.5.代金券id

voucherOrder.setVoucherId(voucherId);

// 2.6.放入阻塞队列

orderTasks.add(voucherOrder);

//3.获取代理对象

proxy = (IVoucherOrderService)AopContext.currentProxy();

//4.返回订单id

return Result.ok(orderId);

}

@Transactional

public void createVoucherOrder(VoucherOrder voucherOrder) {

Long userId = voucherOrder.getUserId();

// 5.1.查询订单

int count = query().eq("user_id", userId).eq("voucher_id", voucherOrder.getVoucherId()).count();

// 5.2.判断是否存在

if (count > 0) {

// 用户已经购买过了

log.error("用户已经购买过了");

return ;

}

// 6.扣减库存

boolean success = seckillVoucherService.update()

.setSql("stock = stock - 1") // set stock = stock - 1

.eq("voucher_id", voucherOrder.getVoucherId()).gt("stock", 0) // where id = ? and stock > 0

.update();

if (!success) {

// 扣减失败

log.error("库存不足");

return ;

}

save(voucherOrder);

}总结:

秒杀业务的优化思路是什么?

先利用Redis完成库存余量、一人一单判断,完成抢单业务

再将下单业务放入阻塞队列,利用独立线程异步下单

基于阻塞队列的异步秒杀存在哪些问题?

内存限制问题

数据安全问题

Redis消息队列

认识Redis消息队列

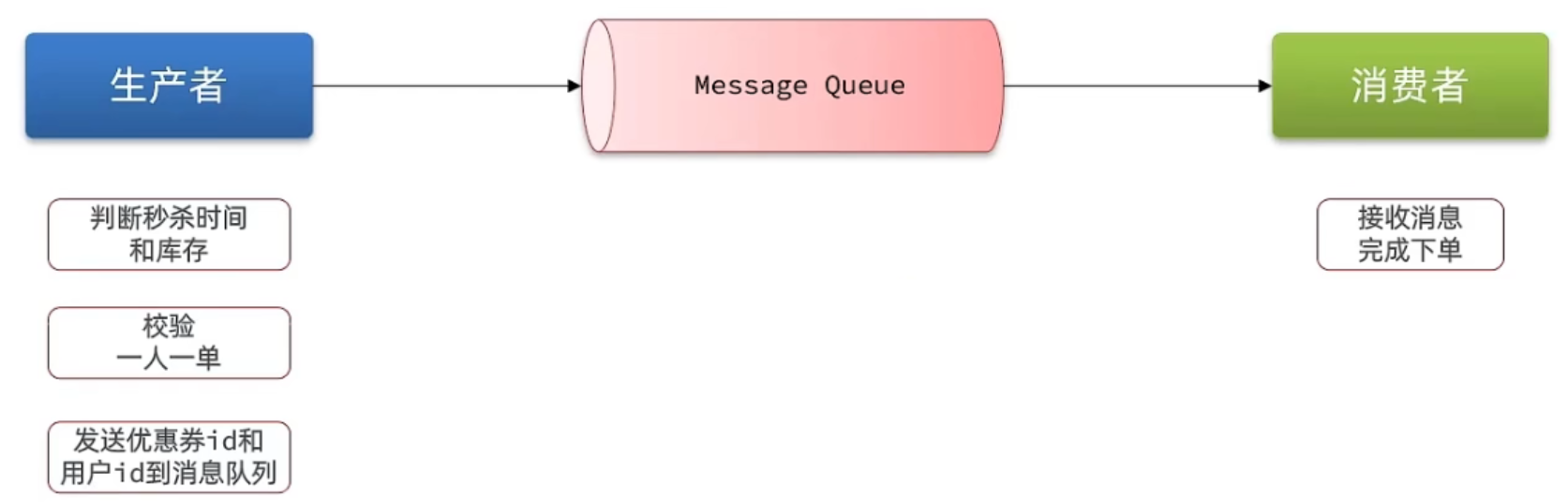

什么是消息队列:字面意思就是存放消息的队列。最简单的消息队列模型包括3个角色:

消息队列:存储和管理消息,也被称为消息代理(Message Broker)

生产者:发送消息到消息队列

消费者:从消息队列获取消息并处理消息

使用队列的好处在于 解耦: 所谓解耦,举一个生活中的例子就是:快递员(生产者)把快递放到快递柜里边(Message Queue)去,我们(消费者)从快递柜里边去拿东西,这就是一个异步,如果耦合,那么这个快递员相当于直接把快递交给你,这事固然好,但是万一你不在家,那么快递员就会一直等你,这就浪费了快递员的时间,所以这种思想在我们日常开发中,是非常有必要的。

这种场景在我们秒杀中就变成了:我们下单之后,利用redis去进行校验下单条件,再通过队列把消息发送出去,然后再启动一个线程去消费这个消息,完成解耦,同时也加快我们的响应速度。

这里我们可以使用一些现成的mq,比如kafka,rabbitmq等等,但是呢,如果没有安装mq,我们也可以直接使用redis提供的mq方案,降低我们的部署和学习成本。

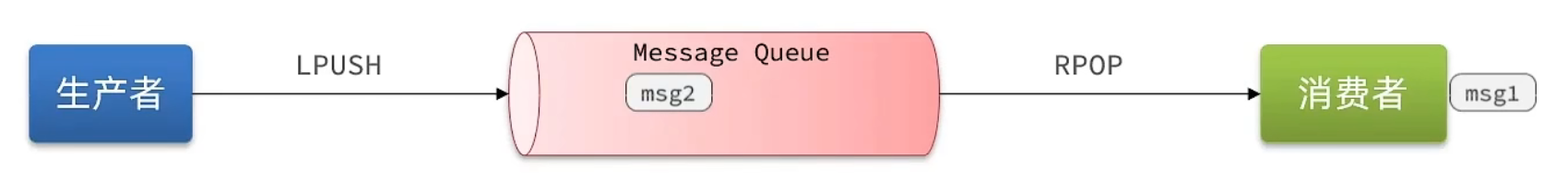

基于List实现消息队列

基于List结构模拟消息队列

消息队列(Message Queue),字面意思就是存放消息的队列。而Redis的list数据结构是一个双向链表,很容易模拟出队列效果。

队列是入口和出口不在一边,因此我们可以利用:LPUSH 结合 RPOP、或者 RPUSH 结合 LPOP来实现。 不过要注意的是,当队列中没有消息时RPOP或LPOP操作会返回null,并不像JVM的阻塞队列那样会阻塞并等待消息。因此这里应该使用BRPOP或者BLPOP来实现阻塞效果。

基于List的消息队列有哪些优缺点? 优点:

利用Redis存储,不受限于JVM内存上限

基于Redis的持久化机制,数据安全性有保证

可以满足消息有序性

缺点:

无法避免消息丢失

只支持单消费者

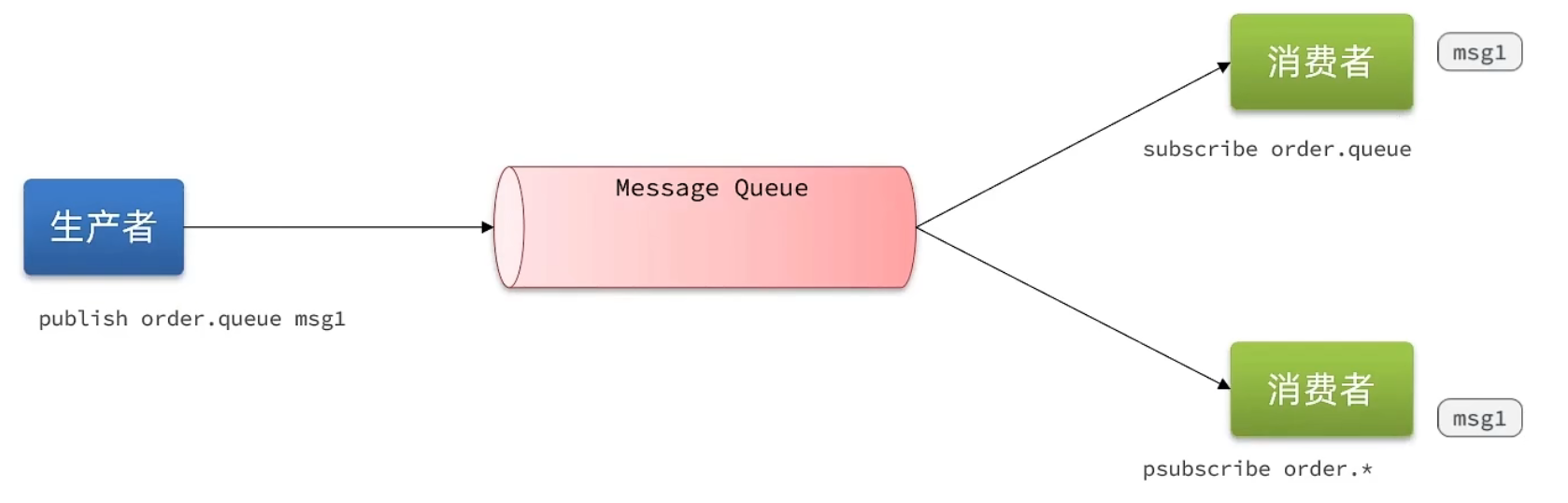

基于PubSub的消息队列

PubSub(发布订阅)是Redis2.0版本引入的消息传递模型。顾名思义,消费者可以订阅一个或多个channel,生产者向对应channel发送消息后,所有订阅者都能收到相关消息。

SUBSCRIBE channel [channel] :订阅一个或多个频道 PUBLISH channel msg :向一个频道发送消息 PSUBSCRIBE pattern[pattern] :订阅与pattern格式匹配的所有频道

基于PubSub的消息队列有哪些优缺点? 优点:

- 采用发布订阅模型,支持多生产、多消费

缺点:

不支持数据持久化

无法避免消息丢失

消息堆积有上限,超出时数据丢失

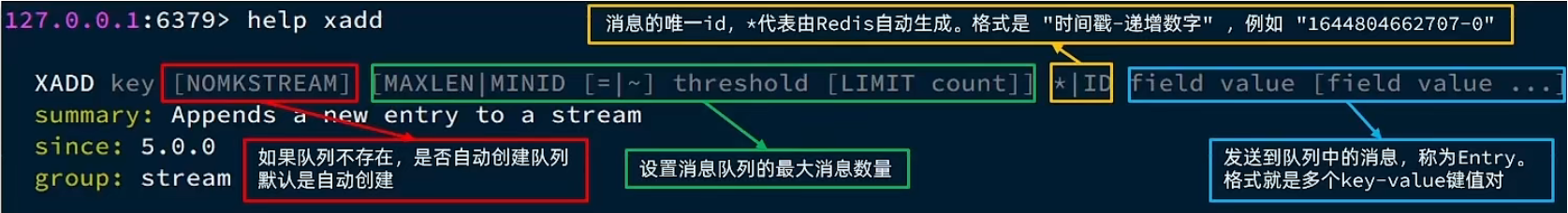

基于Stream的消息队列

Stream 是 Redis 5.0 引入的一种新数据类型,可以实现一个功能非常完善的消息队列。

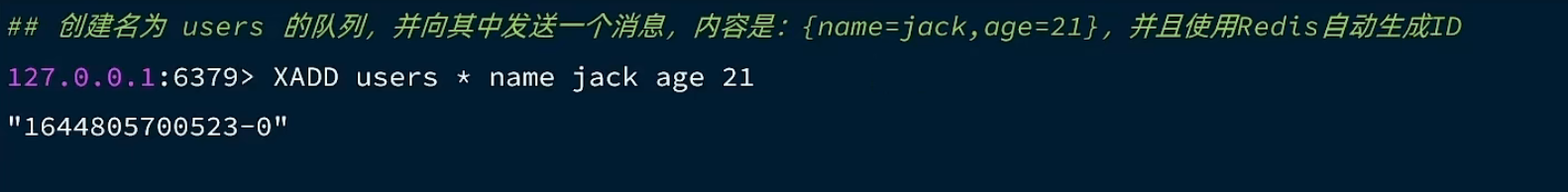

发送消息的命令:

例如:

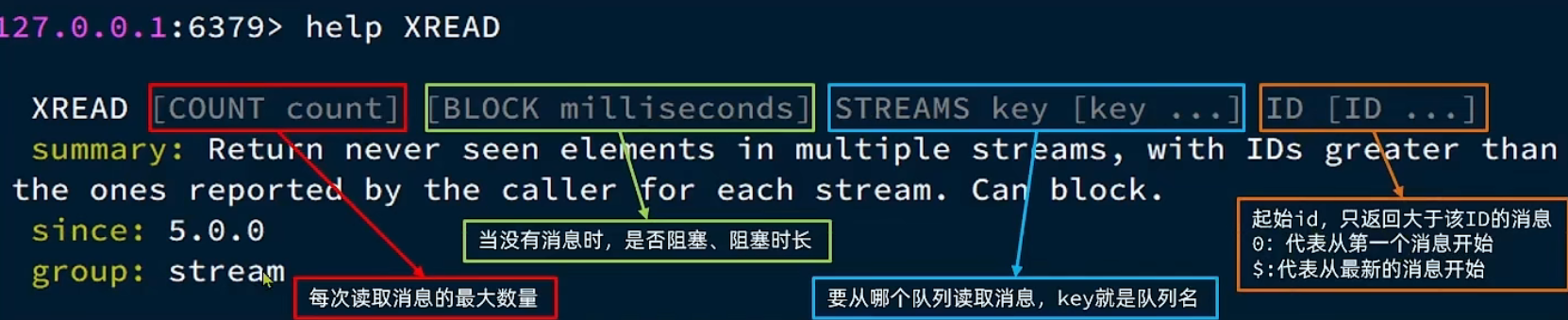

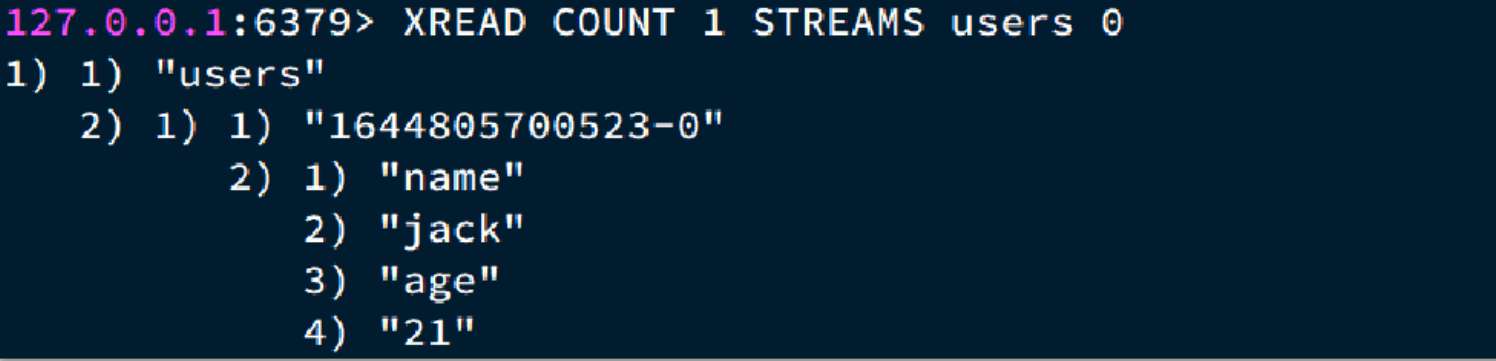

读取消息的方式之一:XREAD

例如:

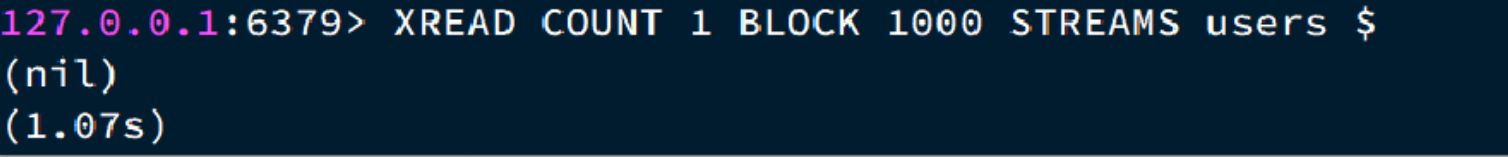

XREAD阻塞方式,读取最新的消息:

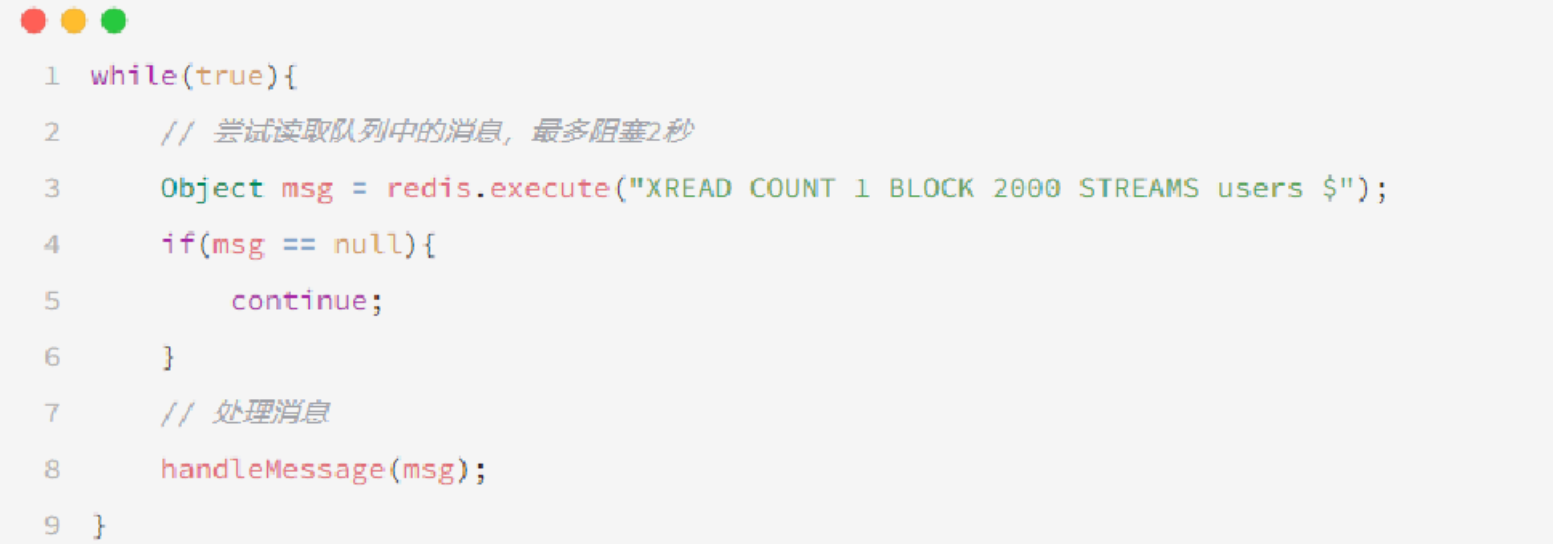

在业务开发中,我们可以循环的调用XREAD阻塞方式来查询最新消息,从而实现持续监听队列的效果,伪代码如下

STREAM类型消息队列的XREAD命令特点:

消息可回溯

一个消息可以被多个消费者读取

可以阻塞读取

有消息漏读的风险

对比

点赞功能

@GetMapping("/likes/{id}")

public Result queryBlogLikes(@PathVariable("id") Long id) {

//修改点赞数量

blogService.update().setSql("liked = liked +1 ").eq("id",id).update();

return Result.ok();

}问题分析:这种方式会导致一个用户无限点赞,明显是不合理的

造成这个问题的原因是,我们现在的逻辑,发起请求只是给数据库+1,所以才会出现这个问题。

完善点赞功能

需求:

同一个用户只能点赞一次,再次点击则取消点赞

如果当前用户已经点赞,则点赞按钮高亮显示(前端已实现,判断字段Blog类的isLike属性)

实现步骤:

给Blog类中添加一个isLike字段,标示是否被当前用户点赞

修改点赞功能,利用Redis的set集合判断是否点赞过,未点赞过则点赞数+1,已点赞过则点赞数-1

修改根据id查询Blog的业务,判断当前登录用户是否点赞过,赋值给isLike字段

修改分页查询Blog业务,判断当前登录用户是否点赞过,赋值给isLike字段

为什么采用set集合:

因为我们的数据是不能重复的,当用户操作过之后,无论他怎么操作,都是

具体步骤:

1、在Blog 添加一个字段

@TableField(exist = false)

private Boolean isLike;2、修改代码

@Override

public Result likeBlog(Long id){

// 1.获取登录用户

Long userId = UserHolder.getUser().getId();

// 2.判断当前登录用户是否已经点赞

String key = BLOG_LIKED_KEY + id;

Boolean isMember = stringRedisTemplate.opsForSet().isMember(key, userId.toString());

if(BooleanUtil.isFalse(isMember)){

//3.如果未点赞,可以点赞

//3.1 数据库点赞数+1

boolean isSuccess = update().setSql("liked = liked + 1").eq("id", id).update();

//3.2 保存用户到Redis的set集合

if(isSuccess){

stringRedisTemplate.opsForSet().add(key,userId.toString());

}

}else{

//4.如果已点赞,取消点赞

//4.1 数据库点赞数-1

boolean isSuccess = update().setSql("liked = liked - 1").eq("id", id).update();

//4.2 把用户从Redis的set集合移除

if(isSuccess){

stringRedisTemplate.opsForSet().remove(key,userId.toString());

}

}排行榜功能

在探店笔记的详情页面,应该把给该笔记点赞的人显示出来,比如最早点赞的TOP5,形成点赞排行榜:

之前的点赞是放到set集合,但是set集合是不能排序的,所以这个时候,咱们可以采用一个可以排序的set集合,就是咱们的sortedSet。

所有点赞的人,需要是唯一的,所以我们应当使用set或者是sortedSet

其次我们需要排序,就可以直接锁定使用sortedSet

修改代码

BlogServiceImpl

点赞逻辑代码

@Override

public Result likeBlog(Long id) {

// 1.获取登录用户

Long userId = UserHolder.getUser().getId();

// 2.判断当前登录用户是否已经点赞

String key = BLOG_LIKED_KEY + id;

Double score = stringRedisTemplate.opsForZSet().score(key, userId.toString());

if (score == null) {

// 3.如果未点赞,可以点赞

// 3.1.数据库点赞数 + 1

boolean isSuccess = update().setSql("liked = liked + 1").eq("id", id).update();

// 3.2.保存用户到Redis的set集合 zadd key value score

if (isSuccess) {

stringRedisTemplate.opsForZSet().add(key, userId.toString(), System.currentTimeMillis());

}

} else {

// 4.如果已点赞,取消点赞

// 4.1.数据库点赞数 -1

boolean isSuccess = update().setSql("liked = liked - 1").eq("id", id).update();

// 4.2.把用户从Redis的set集合移除

if (isSuccess) {

stringRedisTemplate.opsForZSet().remove(key, userId.toString());

}

}

return Result.ok();

}

private void isBlogLiked(Blog blog) {

// 1.获取登录用户

UserDTO user = UserHolder.getUser();

if (user == null) {

// 用户未登录,无需查询是否点赞

return;

}

Long userId = user.getId();

// 2.判断当前登录用户是否已经点赞

String key = "blog:liked:" + blog.getId();

Double score = stringRedisTemplate.opsForZSet().score(key, userId.toString());

blog.setIsLike(score != null);

}点赞列表查询列表

BlogController

@GetMapping("/likes/{id}")

public Result queryBlogLikes(@PathVariable("id") Long id) {

return blogService.queryBlogLikes(id);

}BlogService

@Override

public Result queryBlogLikes(Long id) {

String key = BLOG_LIKED_KEY + id;

// 1.查询top5的点赞用户 zrange key 0 4

Set<String> top5 = stringRedisTemplate.opsForZSet().range(key, 0, 4);

if (top5 == null || top5.isEmpty()) {

return Result.ok(Collections.emptyList());

}

// 2.解析出其中的用户id

List<Long> ids = top5.stream().map(Long::valueOf).collect(Collectors.toList());

String idStr = StrUtil.join(",", ids);

// 3.根据用户id查询用户 WHERE id IN ( 5 , 1 ) ORDER BY FIELD(id, 5, 1)

List<UserDTO> userDTOS = userService.query()

.in("id", ids).last("ORDER BY FIELD(id," + idStr + ")").list()

.stream()

.map(user -> BeanUtil.copyProperties(user, UserDTO.class))

.collect(Collectors.toList());

// 4.返回

return Result.ok(userDTOS);

}用户签到

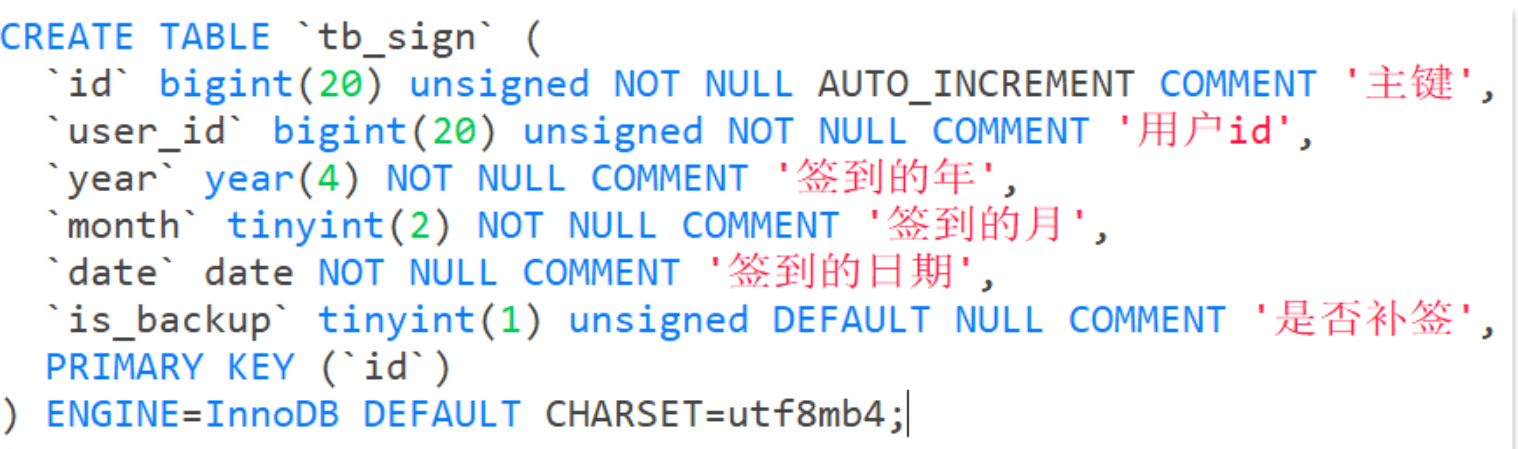

我们针对签到功能完全可以通过mysql来完成,比如说以下这张表

用户一次签到,就是一条记录,假如有1000万用户,平均每人每年签到次数为10次,则这张表一年的数据量为 1亿条

每签到一次需要使用(8 + 8 + 1 + 1 + 3 + 1)共22 字节的内存,一个月则最多需要600多字节

我们如何能够简化一点呢?其实可以考虑小时候一个挺常见的方案,就是小时候,咱们准备一张小小的卡片,你只要签到就打上一个勾,我最后判断你是否签到,其实只需要到小卡片上看一看就知道了

我们可以采用类似这样的方案来实现我们的签到需求。

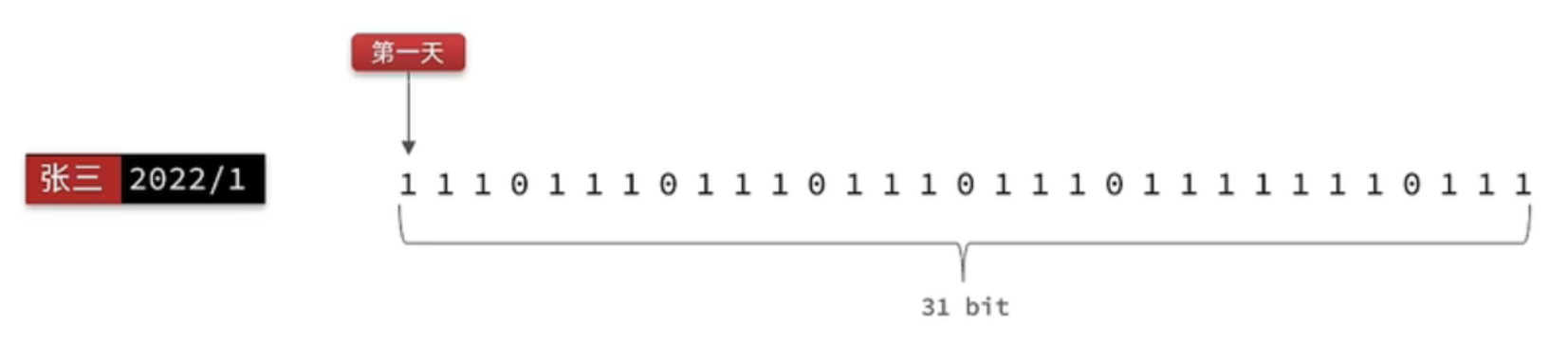

我们按月来统计用户签到信息,签到记录为1,未签到则记录为0.

把每一个bit位对应当月的每一天,形成了映射关系。用0和1标示业务状态,这种思路就称为位图(BitMap)。这样我们就用极小的空间,来实现了大量数据的表示

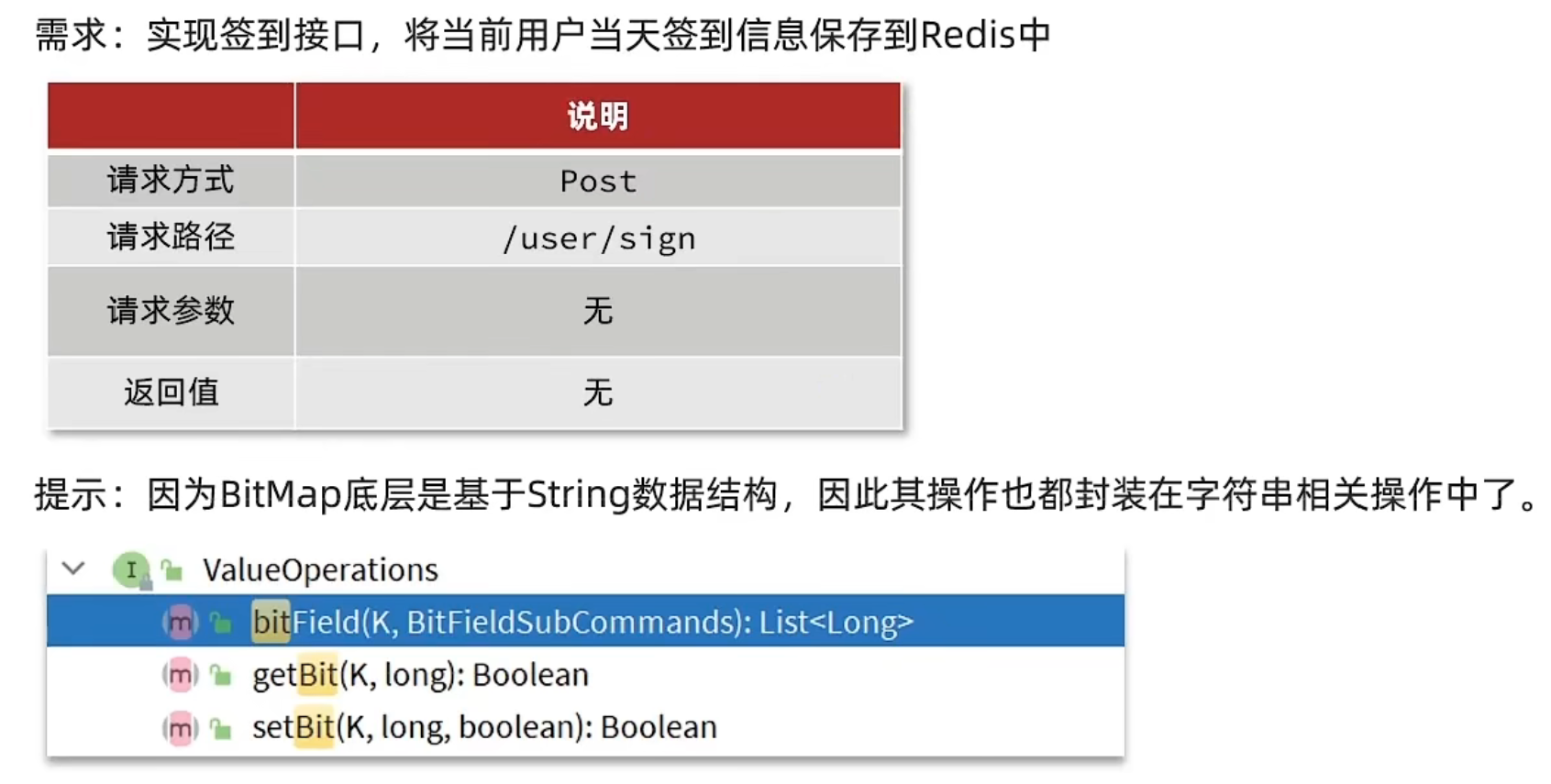

Redis中是利用string类型数据结构实现BitMap,因此最大上限是512M,转换为bit则是 2^32个bit位。

BitMap的操作命令有:

SETBIT:向指定位置(offset)存入一个0或1

GETBIT :获取指定位置(offset)的bit值

BITCOUNT :统计BitMap中值为1的bit位的数量

BITFIELD :操作(查询、修改、自增)BitMap中bit数组中的指定位置(offset)的值

BITFIELD_RO :获取BitMap中bit数组,并以十进制形式返回

BITOP :将多个BitMap的结果做位运算(与 、或、异或)

BITPOS :查找bit数组中指定范围内第一个0或1出现的位置

需求实现

需求:实现签到接口,将当前用户当天签到信息保存到Redis中

思路:我们可以把年和月作为bitMap的key,然后保存到一个bitMap中,每次签到就到对应的位上把数字从0变成1,只要对应是1,就表明说明这一天已经签到了,反之则没有签到。

我们通过接口文档发现,此接口并没有传递任何的参数,没有参数怎么确实是哪一天签到呢?这个很容易,可以通过后台代码直接获取即可,然后到对应的地址上去修改bitMap。

代码

UserController

@PostMapping("/sign")

public Result sign(){

return userService.sign();

}UserServiceImpl

@Override

public Result sign() {

// 1.获取当前登录用户

Long userId = UserHolder.getUser().getId();

// 2.获取日期

LocalDateTime now = LocalDateTime.now();

// 3.拼接key

String keySuffix = now.format(DateTimeFormatter.ofPattern(":yyyyMM"));

String key = USER_SIGN_KEY + userId + keySuffix;

// 4.获取今天是本月的第几天

int dayOfMonth = now.getDayOfMonth();

// 5.写入Redis SETBIT key offset 1

stringRedisTemplate.opsForValue().setBit(key, dayOfMonth - 1, true);

return Result.ok();

}用户签到统计

问题1: 什么叫做连续签到天数? 从最后一次签到开始向前统计,直到遇到第一次未签到为止,计算总的签到次数,就是连续签到天数。

Java逻辑代码:获得当前这个月的最后一次签到数据,定义一个计数器,然后不停的向前统计,直到获得第一个非0的数字即可,每得到一个非0的数字计数器+1,直到遍历完所有的数据,就可以获得当前月的签到总天数了

**问题2:**如何得到本月到今天为止的所有签到数据?

BITFIELD key GET u[dayOfMonth] 0

假设今天是10号,那么我们就可以从当前月的第一天开始,获得到当前这一天的位数,是10号,那么就是10位,去拿这段时间的数据,就能拿到所有的数据了,那么这10天里边签到了多少次呢?统计有多少个1即可。

问题3:如何从后向前遍历每个bit位?

注意:bitMap返回的数据是10进制,哪假如说返回一个数字8,那么我哪儿知道到底哪些是0,哪些是1呢?我们只需要让得到的10进制数字和1做与运算就可以了,因为1只有遇见1 才是1,其他数字都是0 ,我们把签到结果和1进行与操作,每与一次,就把签到结果向右移动一位,依次内推,我们就能完成逐个遍历的效果了。

需求:实现下面接口,统计当前用户截止当前时间在本月的连续签到天数

有用户有时间我们就可以组织出对应的key,此时就能找到这个用户截止这天的所有签到记录,再根据这套算法,就能统计出来他连续签到的次数了。

代码

UserController

@GetMapping("/sign/count")

public Result signCount(){

return userService.signCount();

}UserServiceImpl

@Override

public Result signCount() {

// 1.获取当前登录用户

Long userId = UserHolder.getUser().getId();

// 2.获取日期

LocalDateTime now = LocalDateTime.now();

// 3.拼接key

String keySuffix = now.format(DateTimeFormatter.ofPattern(":yyyyMM"));

String key = USER_SIGN_KEY + userId + keySuffix;

// 4.获取今天是本月的第几天

int dayOfMonth = now.getDayOfMonth();

// 5.获取本月截止今天为止的所有的签到记录,返回的是一个十进制的数字 BITFIELD sign:5:202203 GET u14 0

List<Long> result = stringRedisTemplate.opsForValue().bitField(

key,

BitFieldSubCommands.create()

.get(BitFieldSubCommands.BitFieldType.unsigned(dayOfMonth)).valueAt(0)

);

if (result == null || result.isEmpty()) {

// 没有任何签到结果

return Result.ok(0);

}

Long num = result.get(0);

if (num == null || num == 0) {

return Result.ok(0);

}

// 6.循环遍历

int count = 0;

while (true) {

// 6.1.让这个数字与1做与运算,得到数字的最后一个bit位 // 判断这个bit位是否为0

if ((num & 1) == 0) {

// 如果为0,说明未签到,结束

break;

}else {

// 如果不为0,说明已签到,计数器+1

count++;

}

// 把数字右移一位,抛弃最后一个bit位,继续下一个bit位

num >>>= 1;

}

return Result.ok(count);

}UV统计

首先我们搞懂两个概念:

UV:全称Unique Visitor,也叫独立访客量,是指通过互联网访问、浏览这个网页的自然人。1天内同一个用户多次访问该网站,只记录1次。

PV:全称Page View,也叫页面访问量或点击量,用户每访问网站的一个页面,记录1次PV,用户多次打开页面,则记录多次PV。往往用来衡量网站的流量。

通常来说UV会比PV大很多,所以衡量同一个网站的访问量,我们需要综合考虑很多因素,所以我们只是单纯的把这两个值作为一个参考值

UV统计在服务端做会比较麻烦,因为要判断该用户是否已经统计过了,需要将统计过的用户信息保存。但是如果每个访问的用户都保存到Redis中,数据量会非常恐怖,那怎么处理呢?

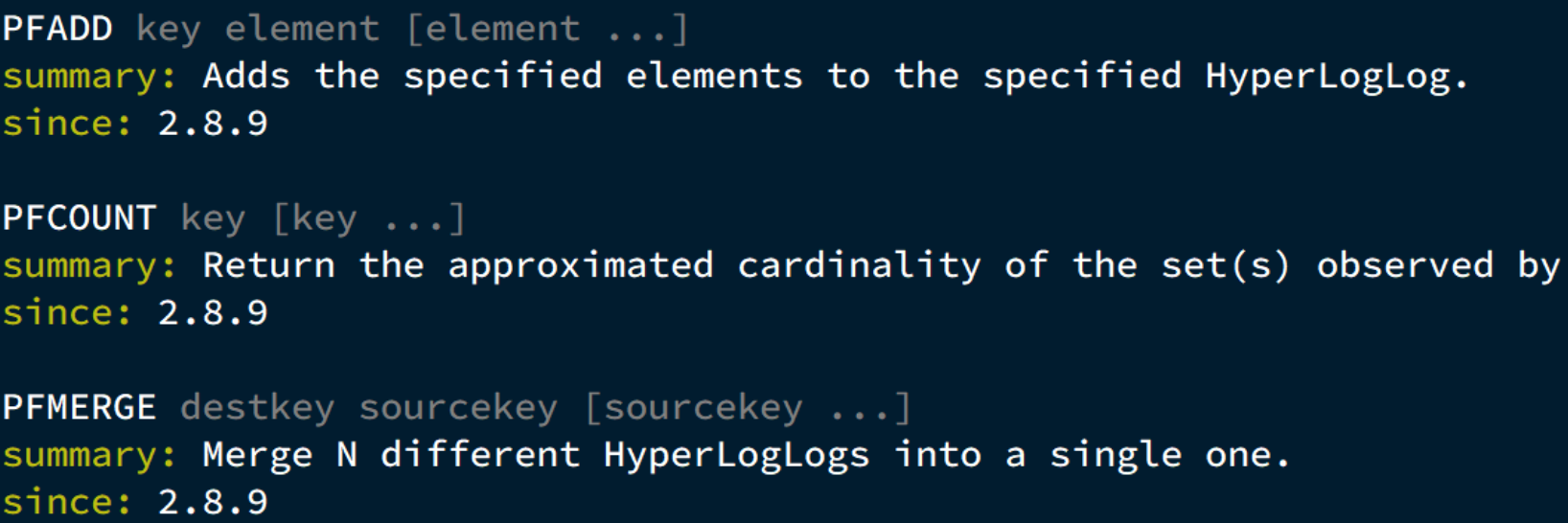

Hyperloglog(HLL)是从Loglog算法派生的概率算法,用于确定非常大的集合的基数,而不需要存储其所有值。相关算法原理大家可以参考:https://juejin.cn/post/6844903785744056333#heading-0 Redis中的HLL是基于string结构实现的,单个HLL的内存永远小于16kb,内存占用低的令人发指!作为代价,其测量结果是概率性的,有小于0.81%的误差。不过对于UV统计来说,这完全可以忽略。

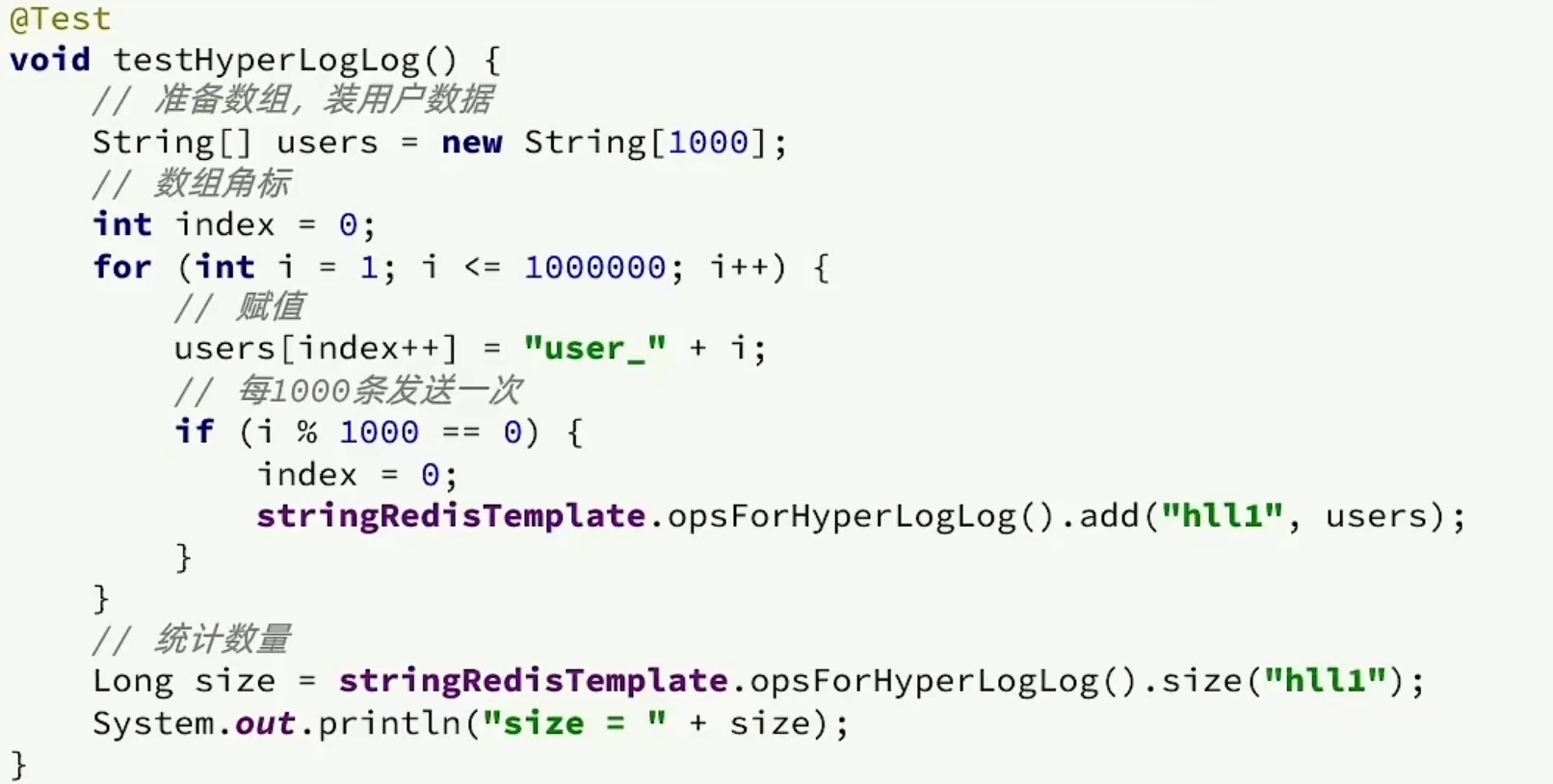

测试百万数据的统计

测试思路:我们直接利用单元测试,向HyperLogLog中添加100万条数据,看看内存占用和统计效果如何。

经过测试:我们会发生他的误差是在允许范围内,并且内存占用极小